SEO:爬虫禁抓协议robots.txt和sitemap网站地图

文章目录爬虫禁抓协议robots.txtsitemap网站地图如何创建sitemap网站地图爬虫禁抓协议robots.txtRobots协议是国际互联网界通行的道德规范。由网站所有者指定的一个文件:robot.txt,这个文件指明了哪些目录下的网页是不允许爬虫抓取的。sitemap网站地图sitemap是什么?sitemap是网站目录检索Google、雅虎、和微软都支持xml网站地图(xml Si

·

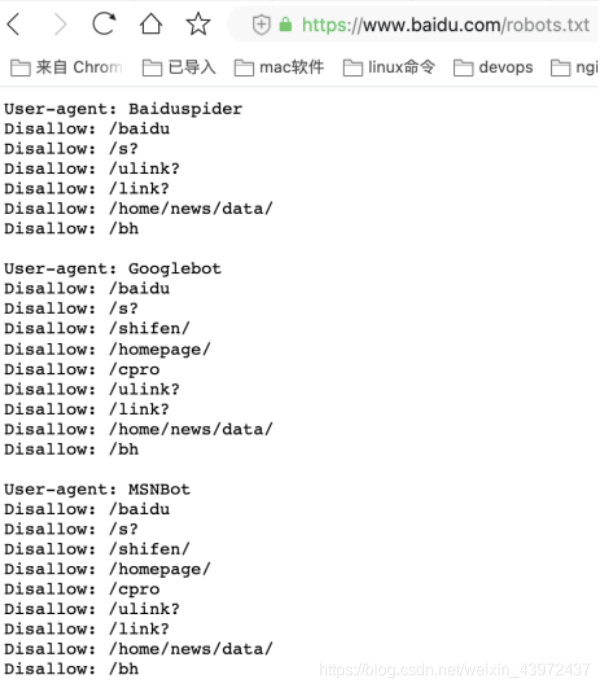

爬虫禁抓协议robots.txt

Robots协议是国际互联网界通行的道德规范。

由网站所有者指定的一个文件:robot.txt,这个文件指明了哪些目录下的网页是不允许爬虫抓取的。

sitemap网站地图

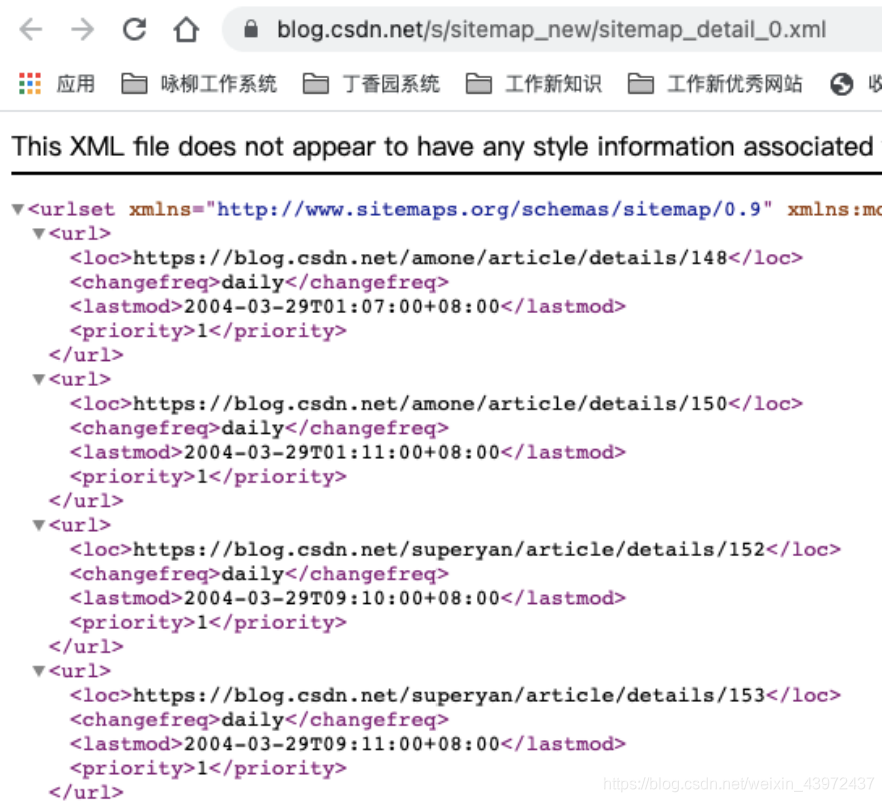

sitemap是什么?

sitemap是网站目录检索

Google、雅虎、和微软都支持xml网站地图(xml Sitemaps)的协议。

百度的Sitemap是指百度支持的收录标准,在原有协议上做出了扩展。

作用?

通过sitemap文件,搜索引擎可以更全面的了解网站结构,有利于蜘蛛爬行!

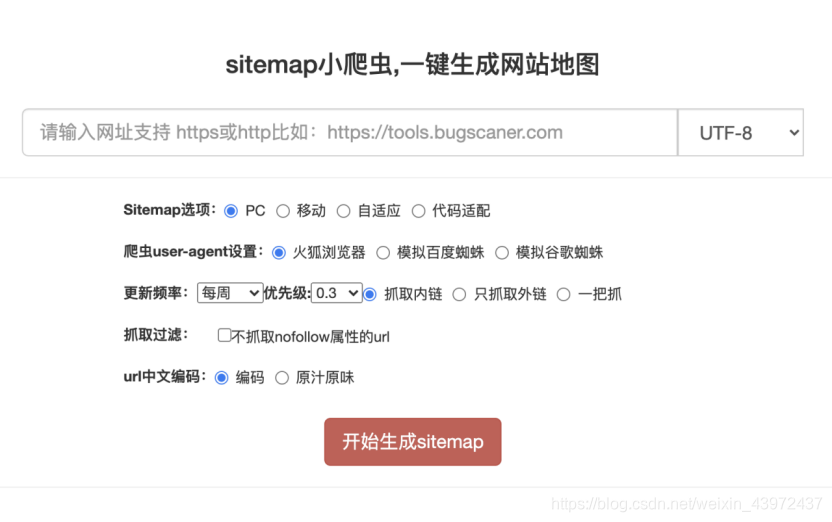

如何创建sitemap网站地图

1、网上搜索sitemap生成器,自己生成一个文件

2、将该文件部署到网站根目录。

3、将该地图的链接放在robots.txt文件的最后。

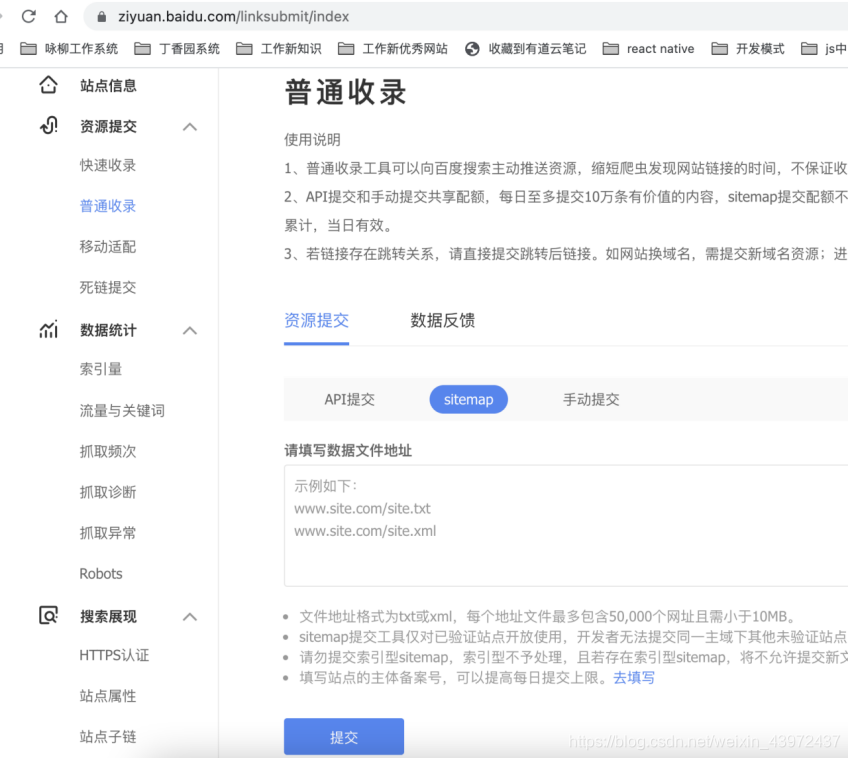

4、提交到百度/谷歌收录。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)