Mistral企业合规监测风险事件自动预警方案

Mistral企业合规监测系统通过知识图谱、机器学习与实时流处理技术,实现风险事件自动预警,提升合规响应效率与准确性。

1. 企业合规监测的背景与挑战

1.1 全球监管环境的复杂化趋势

随着GDPR、CCPA等数据保护法规的全球落地,以及金融、医疗等行业监管力度持续加码,企业面临跨地域、跨领域的多重合规要求。监管规则不仅数量激增,且更新频繁,导致合规管理成本显著上升。

1.2 传统合规模式的局限性

依赖人工审查与静态报表的传统方式难以应对实时业务流中的风险暴露。信息孤岛、响应延迟、规则执行不一致等问题普遍存在,极易造成监管盲区。

1.3 自动化预警系统的战略价值

构建基于数据驱动的合规监测体系,可实现风险事件的实时识别与智能研判,提升合规响应效率,降低运营风险,为企业可持续发展提供有力保障。

2. 合规风险自动预警的理论框架

企业合规管理正从传统的静态、人工驱动模式向动态、智能驱动范式演进。面对日益复杂的监管环境和海量异构数据,构建一套科学、可扩展的合规风险自动预警理论框架成为实现高效风控的核心前提。该框架需融合法律语义理解、行为建模、多源信息融合与机器学习推理能力,形成“知识引导+数据驱动”的双重机制。本章将系统阐述合规风险预警的三大支柱:合规知识图谱的构建原理、风险事件识别的机器学习模型以及多源异构数据的融合机制。这些理论组件共同构成了自动化预警系统的认知基础与决策逻辑,为后续技术架构设计提供方法论支撑。

2.1 合规知识图谱的构建原理

合规知识图谱是企业合规智能体系的认知中枢,其核心目标是将非结构化的法规条文、内部政策与业务流程转化为结构化、可计算的知识网络。通过实体识别、关系抽取与规则建模,知识图谱不仅能够表达“谁在什么情况下违反了哪项规定”,还能支持上下文感知的风险推理与动态规则匹配。与通用知识图谱不同,合规图谱强调强语义约束、高准确性和可解释性,必须满足审计追溯与监管披露的要求。

2.1.1 法规条款结构化解析方法

法规文本通常以自然语言书写,具有高度的专业性、模糊性和嵌套逻辑特征,例如“若A发生且B未完成,则C不得执行”。直接使用原始文本进行比对或检索效率低下且易产生误判。因此,必须通过结构化解析将其转换为机器可读的形式。这一过程包括四个关键步骤:文档预处理、句法分析、语义角色标注(SRL)和逻辑形式映射。

首先,在文档预处理阶段,采用OCR与PDF解析工具提取法规PDF中的纯文本内容,并利用正则表达式识别章节编号、条款标题与引用关系。对于跨文件引用(如《反洗钱法》第十五条参照《金融机构客户身份识别办法》),建立外部链接索引表。

其次,使用依存句法分析器(如Stanford Parser或SpaCy的en_core_web_sm模型)对句子进行语法树构建,识别主谓宾结构及条件状语从句。例如,“当交易金额超过5万元人民币时,金融机构应当开展客户尽职调查”会被拆解为主句“金融机构应当开展客户尽职调查”和条件从句“当交易金额超过5万元人民币时”。

接着,应用语义角色标注技术识别动作的施动者(Agent)、受动者(Patient)、时间(Time)、地点(Location)和条件(Condition)。这一步骤依赖于预训练的语言模型(如BERT-BiLSTM-CRF)进行序列标注。输出结果可用于填充预定义的模板:

{

"action": "开展客户尽职调查",

"agent": "金融机构",

"condition": {

"type": "金额阈值",

"field": "交易金额",

"operator": ">",

"value": "50000",

"unit": "CNY"

},

"trigger_event": "大额交易"

}

最后,将上述结构化输出映射到OWL本体或RDF三元组中,形成知识图谱的基本单元。下表展示了部分映射示例:

| 主语 | 谓词 | 宾语 | 上下文标签 |

|---|---|---|---|

| 金融机构 | 必须执行 | 客户尽职调查 | 条款ID: AML-15 |

| 交易金额 | 大于 | 50000 CNY | 触发条件 |

| 客户类型 | 属于 | 政要人士 | 高风险类别 |

此结构化表示不仅便于存储于图数据库(如Neo4j或JanusGraph),还可作为规则引擎的输入源,支持后续的模式匹配与推理推导。

2.1.2 实体关系抽取与语义建模技术

在合规场景中,关键实体包括“主体”(如公司、员工、客户)、“客体”(如账户、合同、数据字段)、“行为”(如转账、访问、修改)以及“规范依据”(如法规条目、内部制度)。仅识别实体不足以支撑风险判断,必须明确它们之间的语义关系,才能实现精准的风险关联分析。

当前主流的实体关系抽取方法分为两类:基于规则的方法与基于深度学习的方法。前者适用于领域术语固定、表达规范的法规文本,后者更擅长处理非正式文档或日志记录中的隐含关系。

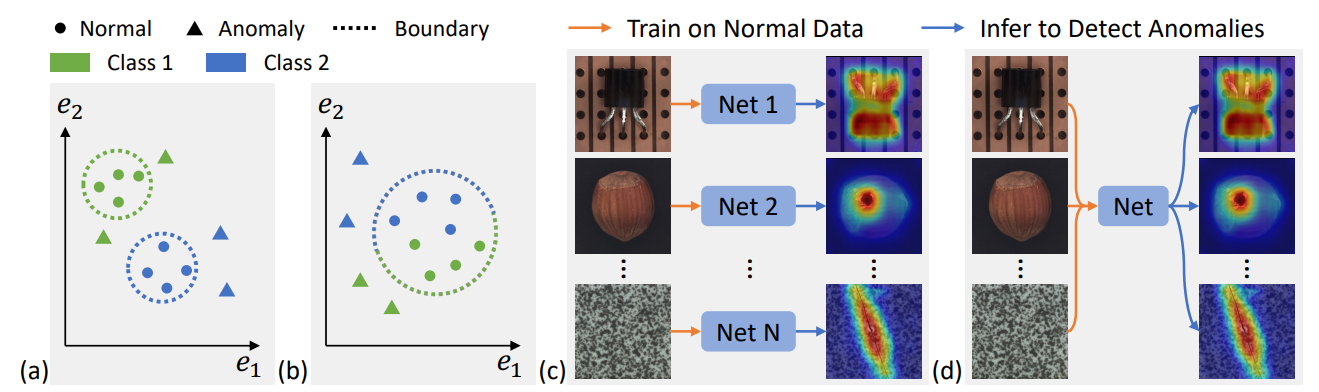

以深度学习为例,常采用联合命名实体识别与关系分类的端到端模型,如 Span-based Joint Entity and Relation Extraction 架构。其输入是一段文本,输出是一组带类型的实体及其两两之间的关系。模型结构如下图所示:

import torch

import transformers

class ComplianceREModel(torch.nn.Module):

def __init__(self, bert_model_name, num_entity_labels, num_relation_labels):

super().__init__()

self.bert = transformers.BertModel.from_pretrained(bert_model_name)

self.entity_classifier = torch.nn.Linear(768, num_entity_labels)

self.relation_scorer = torch.nn.Bilinear(768, 768, num_relation_labels)

def forward(self, input_ids, attention_mask):

outputs = self.bert(input_ids=input_ids, attention_mask=attention_mask)

sequence_output = outputs.last_hidden_state # [batch, seq_len, 768]

# 实体预测

entity_logits = self.entity_classifier(sequence_output) # [batch, seq_len, num_ent]

# 关系评分(取头尾token表示)

subject_rep = sequence_output[:, 0, :] # 假设主语在句首

object_rep = sequence_output[:, -1, :] # 假设宾语在句尾

relation_scores = self.relation_scorer(subject_rep, object_rep) # [batch, num_rel]

return entity_logits, relation_scores

代码逻辑逐行解读:

- 第3–6行:定义一个继承自

torch.nn.Module的合规关系抽取模型,接收BERT预训练模型名称、实体类别数和关系类别数。 - 第7行:加载Hugging Face提供的BERT模型作为编码器,用于获取上下文敏感的词向量。

- 第8–9行:定义两个任务头——实体分类器(线性层)和关系打分器(双线性变换),分别用于识别实体类型和判断实体间关系。

- 第12–13行:前向传播中,BERT输出每个位置的隐藏状态向量,形状为

[批次大小, 序列长度, 768]。 - 第15行:将每个位置的向量送入实体分类器,得到每个token属于各类实体的概率分布。

- 第18–19行:假设主语和宾语分别位于句首和句尾,取出对应位置的向量表示。

- 第20行:使用双线性函数计算两者之间的多种关系得分,输出维度为

[批次, 关系类型数]。

该模型可在标注好的合规语料上训练,例如每条样本包含文本、实体边界及其关系类型。训练完成后,可应用于新法规的自动解析,快速生成知识图谱节点与边。

此外,为了增强语义一致性,还需引入本体建模(Ontology Modeling)手段。例如,定义统一的类层次结构:

Class: FinancialInstitution

SubClassOf: Organization

Class: HighRiskCustomer

SubClassOf: Customer

hasRiskLevel value "High"

ObjectProperty: commits

Domain: Person

Range: Violation

此类OWL声明可通过Protégé等工具维护,并导入图数据库中作为schema约束,确保知识一致性。

2.1.3 动态规则引擎的设计逻辑

知识图谱提供了静态知识储备,但真正的风险预警需要动态响应业务事件流。为此,需设计一个支持实时匹配、版本控制与优先级调度的规则引擎。该引擎应具备以下特性:

- 规则可配置化 :允许合规官通过图形界面或DSL(领域特定语言)编写规则;

- 事件驱动触发 :监听Kafka主题或数据库变更日志,捕获待检事件;

- 上下文感知匹配 :结合用户角色、时间窗口、历史行为等上下文信息判断是否触发;

- 支持复杂逻辑组合 :允许AND/OR/NOT嵌套、时间序列聚合与状态机转换。

一种典型实现方式是基于Drools规则引擎扩展,定制合规专用DSL。例如,定义如下规则:

rule "Suspicious_Transfer_Amount"

when

$tx: Transaction(

amount > 50000,

currency == "CNY",

sender.accountType == "Personal",

receiver.industry matches "Gambling|Cryptocurrency"

)

not Alert( relatedTx == $tx.id, type == "SuspiciousTransfer", createTime within [0m, 1h] )

then

insert(new Alert("SuspiciousTransfer", $tx.id, "High"));

log("High-risk transfer detected: " + $tx.id);

end

参数说明:

Transaction:事实对象,代表一笔交易,包含金额、币种、账户类型等属性;matches:正则匹配操作符,用于检测接收方行业是否属于高风险类别;within [0m, 1h]:时间约束,防止重复告警;insert():插入新的告警事实,触发下游通知流程;log():记录日志,用于调试与审计。

该规则在Flink或Kubernetes Operator中部署后,可对接实时交易流进行毫秒级匹配。同时,规则本身可存储于Git仓库中,实现版本控制与变更追踪。

更重要的是,规则引擎应支持“规则衍生”机制——即从历史告警中挖掘高频模式,自动生成候选规则建议。例如,通过FP-Growth算法发现“个人账户→加密货币平台 + 单笔超5万 + 非工作时间”频繁共现,系统可提示合规团队评估是否新增一条规则。

综上所述,合规知识图谱不仅是信息组织工具,更是连接法规语义与业务行为的桥梁。它通过结构化解析、语义建模与动态规则联动,为企业建立了一个可解释、可追溯、可持续进化的合规认知体系。

2.2 风险事件识别的机器学习模型

尽管规则引擎能有效捕捉明确的违规模式,但在面对新型、隐蔽或组合式风险时仍显不足。此时,机器学习模型以其强大的模式发现能力,成为补充甚至替代传统规则的重要手段。特别是在监督学习与无监督学习的协同下,系统既能识别已知风险,又能探测潜在异常。

2.2.1 监督学习在异常检测中的应用

监督学习依赖标注数据训练分类模型,适用于已有大量历史违规案例的企业场景。其优势在于高精度与可解释性强,尤其适合处理明确定义的风险类型,如虚假报销、内部欺诈、数据越权访问等。

2.2.1.1 分类算法选择与训练样本标注策略

在合规场景中,常用分类算法包括逻辑回归(LR)、随机森林(RF)、梯度提升树(XGBoost/LightGBM)和浅层神经网络。选择依据主要取决于数据规模、特征稀疏性与实时性要求。

| 算法 | 适用场景 | 训练速度 | 可解释性 | 是否支持在线学习 |

|---|---|---|---|---|

| 逻辑回归 | 小规模、线性可分 | 快 | 高 | 是(SGD) |

| 随机森林 | 中等规模、非线性 | 中 | 中 | 否 |

| XGBoost | 大规模结构化数据 | 慢 | 中 | 否 |

| 浅层NN | 特征交叉复杂 | 慢 | 低 | 是 |

考虑到合规系统对可解释性的高要求,推荐优先选用XGBoost或随机森林,并结合SHAP值进行归因分析。

样本标注是监督学习成败的关键。由于真实违规事件稀少,正负样本极度不平衡(常见比例1:1000以上),需采取以下策略:

- 主动学习(Active Learning) :由模型初筛可疑样本,交由合规专家确认,逐步扩充训练集;

- 合成少数类过采样(SMOTE) :对正样本进行特征空间插值,缓解样本不足问题;

- 负采样优化 :从正常行为中选取与正样本相似的“困难负例”,提升模型区分力。

例如,在检测员工异常登录行为时,特征工程可包括:

def extract_login_features(log_entry):

return {

'hour_of_day': log_entry.timestamp.hour,

'is_weekend': log_entry.timestamp.weekday() >= 5,

'geo_distance_km': haversine_distance(

last_location, current_location),

'device_change': int(log_entry.device_id != prev_device),

'failed_attempts_5min': count_failures_in_window(log_entry.user, 300),

'role_access_mismatch': check_role_permission(log_entry.user, log_entry.resource)

}

参数说明:

haversine_distance:计算两次登录地理位置间的球面距离;device_change:标识设备更换,常为异常信号;failed_attempts_5min:短时间多次失败尝试,反映暴力破解可能;role_access_mismatch:判断用户角色是否有权访问目标资源。

这些特征输入模型后,输出为 P(异常) 概率值。设定动态阈值(如Top 0.5%)即可生成预警。

值得注意的是,监督模型存在“滞后性”——只能识别过去出现过的风险类型。因此,必须与无监督方法结合,形成互补机制。

2.2.2 无监督聚类发现未知风险模式

当缺乏足够标注数据或面临全新威胁时,无监督学习成为首选方案。其核心思想是通过聚类、降维或异常评分,发现偏离正常行为分布的数据点。

2.2.2.1 基于时间序列的行为偏离分析

许多合规风险表现为行为模式的突变,如某员工突然频繁访问敏感文件、某个账户短期内发起大量小额转账等。这类问题可建模为时间序列异常检测任务。

常用方法包括:

- 滑动窗口统计 :计算均值、标准差、变化率等指标,设置阈值报警;

- 季节性分解(STL) :分离趋势、周期与残差成分,残差过大即为异常;

- LSTM Autoencoder :重构输入序列,重构误差大者视为异常。

以LSTM自编码器为例,模型结构如下:

from keras.models import Sequential

from keras.layers import LSTM, RepeatVector, TimeDistributed, Dense

model = Sequential([

LSTM(50, activation='relu', input_shape=(timesteps, features), return_sequences=False),

RepeatVector(timesteps),

LSTM(50, activation='relu', return_sequences=True),

TimeDistributed(Dense(features))

])

model.compile(optimizer='adam', loss='mse')

逻辑分析:

- 第3行:第一个LSTM层将长度为

timesteps的序列压缩为一个50维上下文向量,实现编码; - 第4行:

RepeatVector将该向量复制timesteps次,作为解码器输入; - 第5–6行:第二个LSTM逐帧解码,

TimeDistributed确保每个时间步独立输出重建值; - 损失函数为均方误差(MSE),训练目标是最小化原始序列与重建序列的差异。

训练完成后,对新序列计算MSE,若超过历史99%分位数,则标记为异常。该方法能有效捕捉非线性、长程依赖的行为偏移。

此外,还可结合Isolation Forest或One-Class SVM等算法,对多维行为特征进行整体评分。最终输出的风险分数可用于排序告警优先级,辅助人工审查。

2.3 多源异构数据融合机制

合规风险往往隐藏在分散的数据孤岛之间。单一系统的日志无法揭示跨系统协作中的违规路径。因此,必须建立统一的数据融合机制,打通内部操作日志、交易流水、人事档案与外部监管名单、舆情信息等多源数据。

2.3.1 内部日志、交易记录与外部监管数据库的集成

典型数据源包括:

| 数据源类型 | 示例 | 更新频率 | 接入方式 |

|---|---|---|---|

| 操作日志 | SSH登录、数据库查询 | 实时流 | Kafka + Filebeat |

| 交易系统 | 支付、转账、订单 | 批量/增量 | JDBC + CDC |

| HR系统 | 员工职级、部门、权限 | 每日同步 | API调用 |

| 外部黑名单 | OFAC、EU Sanctions | 每周更新 | SFTP下载 + 解析 |

集成难点在于格式差异大、语义不一致、更新节奏不同。解决方案是建立“统一实体视图”(Unified Entity View),以员工ID或客户编号为核心键,整合各系统信息。

例如,构建一个 risk_profile 宽表:

CREATE TABLE unified_risk_view (

entity_id STRING PRIMARY KEY,

name STRING,

department STRING,

role STRING,

last_login TIMESTAMP,

total_transactions_30d DECIMAL,

high_risk_counterparties_count INT,

watchlist_match BOOLEAN,

anomaly_score FLOAT

);

该表每日由ETL作业更新,供后续分析使用。

2.3.2 数据清洗、标准化与上下文关联处理流程

原始数据普遍存在缺失、错误、编码混乱等问题。需执行标准化清洗流程:

- 字段归一化 :统一日期格式(ISO8601)、金额单位(USD)、国家代码(ISO3166);

- 去重与补全 :基于主键合并重复记录,使用插值或默认值填补空缺;

- 上下文增强 :添加衍生字段,如“是否节假日”、“是否在办公IP段内”。

流程示例如下:

import pandas as pd

from datetime import datetime

def clean_transaction_data(df: pd.DataFrame) -> pd.DataFrame:

df['amount_usd'] = df.apply(convert_to_usd, axis=1) # 统一币种

df['timestamp'] = pd.to_datetime(df['raw_time'], format='%Y-%m-%d %H:%M:%S')

df['is_night'] = df['timestamp'].dt.hour.between(0, 6)

df['counterparty_risk_level'] = df['counterparty_id'].map(risk_map_dict)

return df.dropna(subset=['amount_usd', 'timestamp'])

清洗后的数据进入图谱构建或模型训练环节,真正实现“数据—知识—决策”的闭环流转。

3. Mistral预警系统的技术架构设计

在现代企业合规管理日益复杂、监管要求不断动态演进的背景下,构建一个具备高可用性、可扩展性和实时响应能力的合规风险自动预警系统成为Mistral实现数据驱动治理的核心基础设施。该系统不仅需要处理来自多源异构系统的海量日志与交易数据,还必须支持复杂的规则匹配逻辑、机器学习模型推理以及安全可控的访问机制。为此,Mistral采用分层式技术架构设计理念,围绕“数据采集—流式计算—服务应用”三大核心层级展开系统设计,并通过模块化组件选型与集成策略保障系统的稳定性与灵活性。

整个预警系统以事件驱动为核心范式,强调低延迟、高吞吐的数据处理能力,同时兼顾批处理任务的历史数据分析需求。系统整体遵循松耦合、高内聚的设计原则,各功能模块之间通过标准化接口通信,便于后期维护升级和横向扩展。更重要的是,系统在设计之初就充分考虑了安全性、审计合规性及权限控制等关键非功能性需求,确保其自身也符合GDPR、ISO 27001等主流信息安全标准。

3.1 系统整体架构与模块划分

为应对企业内部多样化的数据来源和复杂的业务场景,Mistral预警系统采用了三层架构模式: 数据采集层 、 处理计算层 和 应用服务层 。这种分层结构不仅提升了系统的可维护性,也为不同阶段的技术优化提供了清晰边界。

3.1.1 数据采集层:API对接与日志抓取机制

数据采集层是整个预警系统的入口,负责从各类源头系统中获取原始数据流。这些数据源包括但不限于:

- 内部系统日志(如认证日志、操作审计日志)

- 用户行为轨迹(来自前端埋点或后端事件记录)

- 财务与交易流水(ERP、支付网关等系统导出)

- 外部监管数据库(如黑名单库、制裁名单更新接口)

为统一接入方式并降低集成成本,Mistral采用基于RESTful API + Webhook + 日志代理(Log Agent)混合采集方案。对于具备开放接口的服务系统,使用OAuth 2.0授权机制调用其提供的合规相关数据API;而对于无法提供API的传统系统,则部署轻量级日志收集代理(如Fluent Bit),将本地日志文件实时转发至消息队列。

以下是一个典型的日志采集配置示例(YAML格式):

inputs:

- type: tail

paths:

- /var/log/app/access.log

tags:

source: web-server

env: production

filters:

- type: parser

format: json

keys_under_root: true

overwrite_keys: true

outputs:

- type: kafka

hosts: ["kafka-broker-01:9092", "kafka-broker-02:9092"]

topic: raw_events

compression: gzip

max_message_bytes: 1048576

逻辑分析与参数说明:

inputs.type: tail表示监控指定路径下的日志文件新增内容,类似于Linux的tail -f命令。paths定义了需监听的日志路径列表,支持通配符匹配多个文件。tags添加元数据标签,用于后续分类路由与过滤。filters.parser对原始文本进行结构化解析,提取JSON字段并提升为根级属性,便于下游处理。outputs.kafka将解析后的结构化事件发送至Apache Kafka集群,选择gzip压缩算法以减少网络带宽占用。

该配置实现了从物理服务器到消息中间件的自动化日志传输,具备断点续传、失败重试、背压控制等容错机制,保证数据不丢失且有序流动。

此外,针对外部监管数据同步问题,Mistral开发了一套定时拉取+变更检测机制。例如,每日凌晨通过HTTPS协议从欧盟官方发布的 sanctions list 接口下载最新版本,并利用SHA-256校验比对是否发生变化,若发现更新则触发知识图谱的增量刷新流程。

| 数据源类型 | 接入方式 | 传输频率 | 典型延迟 |

|---|---|---|---|

| 内部应用日志 | Fluent Bit + Kafka Producer | 实时(秒级) | <5s |

| 用户行为事件 | 前端埋点SDK上报 | 准实时(10s内) | <15s |

| 支付交易记录 | REST API轮询 | 每分钟一次 | ~60s |

| 监管黑名单 | HTTPS定时下载 | 每日一次 | 24h |

此表展示了不同类型数据源的技术接入策略及其性能表现,体现了系统在多样性与一致性之间的平衡设计。

3.1.2 处理计算层:流式处理与批处理协同架构

处理计算层承担着数据清洗、特征提取、规则匹配和异常评分等核心计算任务。考虑到合规事件既包含突发性违规行为(如短时间内大量敏感数据下载),又涉及长期趋势偏离(如某员工连续数周加班异常),Mistral采用 Lambda架构 思想,融合流式处理与批处理两条路径,实现对实时性与准确性双重目标的支持。

流处理链路(Real-time Path)

实时路径基于Apache Flink构建,所有进入Kafka raw_events 主题的消息由Flink作业消费,在内存状态机中执行窗口聚合与规则匹配。典型处理流程如下:

- 解码原始JSON消息;

- 执行基础字段标准化(如时间戳转UTC、IP归一化);

- 查询维表补全上下文信息(如用户所属部门、角色权限);

- 应用动态加载的规则引擎进行条件判断;

- 若触发警报,则生成预警事件写入

alerts主题。

DataStream<RawEvent> stream = env

.addSource(new FlinkKafkaConsumer<>("raw_events", new JSONSchema(), props))

.name("Kafka-Source");

DataStream<EnrichedEvent> enriched = stream

.map(event -> Enricher.enrich(event)) // 补全用户上下文

.returns(TypeInformation.of(EnrichedEvent.class));

DataStream<Alert> alerts = enriched

.keyBy(e -> e.getUserId())

.window(SlidingEventTimeWindows.of(Time.minutes(5), Time.seconds(30)))

.aggregate(new RiskScoreAggregator())

.filter(score -> score > THRESHOLD)

.map(RiskToAlertMapper::map);

alerts.addSink(new FlinkKafkaProducer<>("alerts", new AlertSchema(), producerProps));

逐行逻辑解读:

- 第1–2行:创建Flink执行环境并接入Kafka主题作为数据源,使用自定义

JSONSchema反序列化器解析消息体。 - 第4–6行:通过

map函数调用Enricher.enrich()方法,查询Redis缓存中的用户维度表,补充组织架构、岗位级别等辅助判断信息。 - 第8–10行:按用户ID分组,设置滑动窗口(每30秒滑动一次,覆盖过去5分钟数据),统计登录失败次数、文件访问频次等指标。

- 第11行:当聚合得分超过预设阈值时,转换为

Alert对象输出。 - 最后一行:将预警结果写入专用Kafka主题,供下游通知系统订阅。

该流处理管道可在毫秒级响应潜在风险,适用于账户暴力破解、权限越权访问等即时威胁识别。

批处理链路(Batch Path)

批处理路径则依托Spark on YARN集群运行每日调度任务,主要完成三项工作:

- 回溯全天事件日志,重新计算用户行为基线;

- 训练轻量级无监督模型(如Isolation Forest)识别隐藏异常;

- 更新Elasticsearch中的用户画像索引。

两种路径的结果最终在服务层合并展示,形成“实时告警+周期评估”的双重视角,增强决策依据的全面性。

3.1.3 应用服务层:预警触发、通知推送与可视化展示

应用服务层面向最终用户(合规官、风控专员等),提供完整的交互界面与业务闭环能力。该层由多个微服务组成,主要包括:

- Alert Manager :负责接收来自Kafka的预警事件,去重、分级、关联已有工单;

- Notification Service :根据严重等级自动发送邮件、短信或企业IM消息;

- Web Dashboard :基于React + ECharts构建的可视化平台,支持多维钻取分析;

- Rule Editor API :允许合规专家通过图形界面编辑规则条件,无需编写代码。

当一条新的预警被提交时,系统会按照如下流程处理:

- 判断事件类型(如“高频数据导出”、“非工作时间登录”);

- 匹配预设的SLA响应等级(P0-P3);

- 自动生成Jira工单并分配给对应责任人;

- 同步推送提醒至企业微信机器人;

- 在Dashboard中标记该用户为“观察对象”,突出显示其近期活动轨迹。

下表列举了不同级别的预警对应的处置流程:

| 预警等级 | 触发条件示例 | 通知方式 | 响应时限 | 自动动作 |

|---|---|---|---|---|

| P0 | 单小时内下载超10GB客户数据 | 电话+短信+IM | 15分钟 | 锁定账号、生成紧急工单 |

| P1 | 连续5次登录失败+异地IP | IM+邮件 | 1小时 | 发送二次验证请求 |

| P2 | 非授权人员访问财务系统 | 邮件通知主管 | 4小时 | 记录日志、加入审计报告 |

| P3 | 单日操作次数显著高于均值 | 控制台提示 | 24小时 | 不采取行动,仅标记 |

上述机制确保了高危事件能够获得优先处理资源,而低风险信号也不会被完全忽略,从而在效率与噪声控制之间取得良好平衡。

3.2 核心组件选型与集成方案

为支撑前述架构设计,Mistral在核心组件选型上坚持“成熟稳定、社区活跃、生态丰富”的原则,选择了业界广泛验证的开源技术栈,并结合私有化部署保障数据主权。

3.2.1 使用Apache Kafka实现高吞吐量事件流传输

作为整个系统的“中枢神经”,Apache Kafka承担着解耦生产者与消费者、缓冲突发流量、保障消息持久性的关键职责。Mistral部署了一个6节点的Kafka集群(3个Broker + 3个ZooKeeper),配置副本因子为3,确保单点故障不影响服务可用性。

关键Topic规划如下:

| Topic名称 | 分区数 | 保留策略 | 消费者组 |

|---|---|---|---|

| raw_events | 12 | 7天 | flink-ingestion-job |

| enriched_events | 8 | 3天 | spark-batch-processor |

| alerts | 6 | 永久(归档) | alert-manager, dashboard |

| audit_log | 4 | 90天 | elasticsearch-sink |

每个Topic根据预期吞吐量合理设置分区数量,以支持水平扩展消费能力。例如, raw_events 主题高峰期每秒接收约8万条消息,因此划分为12个分区,允许多个Flink TaskManager并行消费。

Kafka Producer端启用 acks=all 和 enable.idempotence=true ,防止消息重复或丢失;Consumer端采用 earliest 偏移量策略用于历史回放, latest 用于实时监听。

此外,通过Confluent Schema Registry统一管理Avro格式的消息结构定义,强制实施向前/向后兼容性检查,避免因字段变更导致下游解析失败。

3.2.2 基于Flink的实时规则匹配与状态管理

Flink以其精确一次(exactly-once)语义和强大的状态管理能力,成为实现实时合规规则匹配的理想选择。Mistral将规则引擎抽象为可插拔模块,允许动态加载Groovy脚本或Drools DRL文件。

以下是一个典型的规则匹配片段:

rule "HighVolumeDataExport"

when

$e : Event(

eventType == "DATA_EXPORT",

volume > 5_000_000_000L,

user.role not in ["ADMIN", "SECURITY_OFFICER"],

timestamp within [now - 3600000, now]

)

then

insert(new Alert("P0", "Large unauthorized data export", $e.userId, $e.timestamp));

end

参数说明与逻辑分析:

eventType == "DATA_EXPORT":限定只监控数据导出类事件;volume > 5GB:设定物理阈值,防止误判正常备份行为;user.role not in [...]:排除管理员等特权角色,聚焦普通用户异常;within [now - 3600000, now]:限定时间为最近一小时内,构成时间窗口约束;insert(...):触发动作,生成P0级警报并注入工作流引擎。

Flink Job通过 PatternStream API将此类规则编译为NFA(非确定有限自动机)状态机,能够在毫秒级完成复杂序列模式匹配(如“先失败登录→成功登录→立即导出数据”)。同时,借助RocksDB backend持久化状态,即使发生Failover也能恢复计算进度。

3.2.3 利用Elasticsearch支持快速检索与多维分析

为了满足合规审计中频繁的全文搜索与聚合分析需求,Mistral选用Elasticsearch作为主要查询引擎。所有处理后的事件、用户画像、预警记录均写入ES索引,并建立复合映射结构:

{

"mappings": {

"properties": {

"userId": { "type": "keyword" },

"eventType": { "type": "keyword" },

"ipAddress": { "type": "ip" },

"timestamp": { "type": "date" },

"riskScore": { "type": "float" },

"location": { "type": "geo_point" }

}

},

"settings": {

"number_of_shards": 5,

"refresh_interval": "30s"

}

}

该配置支持高效的地理位置查询(如“找出所有来自俄罗斯的访问”)、时间范围筛选(“近一周的高风险操作”)以及多维聚合(“各部门平均风险评分排名”)。配合Kibana仪表板,合规团队可自助开展深度调查,无需依赖IT支持。

3.3 安全与权限控制机制

鉴于预警系统本身处理大量敏感信息,其自身的安全性不容忽视。Mistral从数据生命周期角度出发,构建了端到端的安全防护体系。

3.3.1 数据加密存储与传输安全协议部署

所有静态数据在落盘前均使用AES-256算法加密,密钥由Hashicorp Vault集中管理,定期轮换。传输层面全面启用TLS 1.3协议,包括:

- Kafka Broker间复制流量

- Flink JobManager与TaskManager通信

- Elasticsearch节点间交互

- Web前端与后端API之间的HTTPS连接

此外,敏感字段(如身份证号、银行卡号)在进入系统前即由客户端SDK进行局部脱敏,仅保留哈希值用于匹配比对,从根本上降低泄露风险。

3.3.2 基于角色的访问控制(RBAC)与审计追踪功能

系统内置四层角色体系:

| 角色 | 权限范围 |

|---|---|

| Viewer | 查看预警概览、图表 |

| Analyst | 查询详细日志、导出报表 |

| Operator | 确认/关闭警报、添加备注 |

| Admin | 管理用户、修改规则、系统配置 |

所有操作均记录至独立的 audit_log 索引,包含操作人、时间、IP地址及变更详情,支持事后追溯与责任认定。每次登录尝试无论成败都会生成审计事件,并与SIEM系统联动,防范撞库攻击。

综上所述,Mistral预警系统通过科学的分层架构设计、稳健的核心组件集成与严密的安全控制机制,构建起一套高效、智能、可信的合规风险防控网络,为企业可持续发展保驾护航。

4. 合规预警系统的实施路径与关键技术实践

企业级合规预警系统的落地并非一蹴而就,其成功依赖于从规则构建、数据处理到模型部署的系统性工程。Mistral在推进该系统建设过程中,采取“分阶段验证、模块化集成、闭环优化”的实施策略,确保技术方案既具备实时响应能力,又能适应复杂多变的监管环境。本章将深入剖析系统实施的关键路径,重点聚焦规则库构建、实时链路搭建以及机器学习模型上线三大核心环节,揭示如何通过技术手段实现从理论设计到生产可用的跨越。

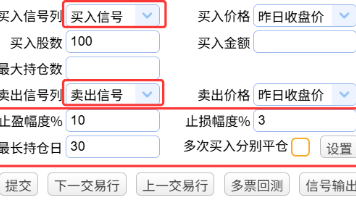

4.1 规则库的初始化与迭代优化

合规预警系统的核心驱动力之一是规则引擎,它决定了系统能否准确识别潜在违规行为。然而,规则并非静态文档的简单翻译,而是需要结合历史数据、业务逻辑和专家经验进行动态建模的过程。Mistral采用“案例驱动+专家反馈”双轮驱动机制,实现了规则库从零到一的构建,并持续提升其精准度与覆盖率。

4.1.1 从历史违规案例中提取特征生成初始规则集

规则库的起点来源于对过去三年内公司内部审计报告、外部监管处罚记录及员工举报事件的全面梳理。通过对237起真实违规事件的结构化分析,团队归纳出五大类典型风险模式:数据越权访问、交易异常流转、合同条款缺失、敏感信息外泄、审批流程绕行。每类事件均被拆解为可量化的 行为特征向量 ,作为初始规则的设计依据。

以“数据越权访问”为例,其关键特征包括:

- 访问时间是否处于非工作时段(如22:00–6:00)

- 请求IP地址是否来自非常用地域

- 被访问资源属于高敏感级别(如客户PII数据)

- 用户角色无明确授权记录

- 单次请求数据量超过阈值(>500条记录)

基于上述维度,团队编写了第一批基于SQL-like语法的规则表达式:

-- 示例:越权数据访问检测规则

RULE detect_unauthorized_data_access AS

WHEN

event.type = 'DATA_ACCESS'

AND user.role NOT IN (SELECT role FROM authorized_roles WHERE resource_id = event.resource)

AND (

HOUR(event.timestamp) BETWEEN 22 AND 6

OR geo_location(event.ip) NOT IN user.trusted_locations

)

AND event.data_volume > 500

THEN

SEVERITY HIGH,

ALERT_CHANNEL 'compliance-team-slack',

LOG_TO_AUDIT_TRAIL;

代码逻辑逐行解读与参数说明:

| 行号 | 代码片段 | 解读 |

|---|---|---|

| 1 | RULE detect_unauthorized_data_access AS |

定义规则名称,便于后续维护与版本追踪 |

| 2 | WHEN ... |

触发条件部分,使用布尔逻辑组合多个判定字段 |

| 3 | event.type = 'DATA_ACCESS' |

过滤仅针对数据访问类事件 |

| 4 | user.role NOT IN (...) |

检查用户角色是否未被列入授权名单,子查询从权限表获取 |

| 5–6 | AND (HOUR(...) OR geo_location(...)) |

时间与地理位置双重异常判断,增强误报过滤能力 |

| 7 | AND event.data_volume > 500 |

增加数据量阈值,避免正常小批量查询误触发 |

| 8–10 | THEN ... |

动作执行部分,定义告警等级、通知渠道及审计日志写入 |

该规则集初期覆盖了约68%的历史已知风险场景,在测试环境中召回率达到79%,但误报率高达34%。这表明单纯依赖显式规则难以应对复杂的上下文情境,需引入更智能的判别机制。

此外,为便于管理与扩展,所有规则均存储于结构化元数据表中,支持动态加载与热更新:

| 字段名 | 类型 | 描述 |

|---|---|---|

| rule_id | VARCHAR(36) | 全局唯一标识符 |

| name | VARCHAR(100) | 规则中文名称 |

| expression | TEXT | 规则DSL表达式 |

| severity | ENUM(‘LOW’,’MEDIUM’,’HIGH’) | 风险等级 |

| category | VARCHAR(50) | 所属风险类型 |

| last_modified | DATETIME | 最后修改时间 |

| enabled | BOOLEAN | 是否启用 |

此设计使得合规官可通过可视化界面调整规则参数而无需重启服务,极大提升了运维灵活性。

4.1.2 引入专家反馈闭环提升规则准确性

初始规则运行两周后,系统共产生1,243条预警,其中经人工复核确认的有效警报为412条,误报占比达66.8%。为此,Mistral建立了 专家反馈闭环机制 ,将每一次预警处置结果反哺至规则优化流程。

具体操作流程如下:

- 预警分发 :系统自动将每条预警推送到指定合规官的企业微信或Slack工作台;

- 人工标注 :合规官根据上下文信息标记为“真阳性”、“假阳性”或“需进一步调查”;

- 反馈回传 :标注结果通过API写入反馈数据库;

- 规则评分 :后台计算每条规则的精确率(Precision)与召回率(Recall),并生成健康度评分;

- 自动建议 :当某规则连续三周Precision低于40%,系统自动生成优化建议,提示增加排除条件或拆分为子规则。

例如,原“大额资金转账”规则因未考虑节假日特殊审批流程,导致节前集中付款被频繁误报。通过收集反馈,团队新增了一个例外白名单机制:

def should_exclude_rule(rule, event):

if rule.name == "large_transfer_alert":

# 白名单:财务部在每月最后一个工作日前的转账

if (event.user.dept == "Finance"

and is_last_workday_of_month(event.timestamp)

and event.approval_status == "AUTO_APPROVED_BY_POLICY"):

return True

return False

该函数在规则匹配前调用,有效降低了特定场景下的噪声干扰。经过三个月的迭代,整体误报率下降至18.3%,规则平均精确率提升至81.7%。

更重要的是,这一机制推动了 规则生命周期管理 的形成——新规则上线需经过沙箱测试、灰度发布、效果评估三个阶段;旧规则则定期进入“观察期”,若长期无命中则建议归档。这种动态治理模式保障了规则库始终与业务节奏保持同步。

4.2 实时预警链路的搭建过程

高效的预警系统不仅要有准确的判断逻辑,还必须具备低延迟、高可靠的数据处理能力。Mistral采用流式架构构建端到端的实时预警链路,确保从事件发生到告警生成的时间控制在秒级以内。

4.2.1 数据预处理管道的开发与测试验证

原始数据源涵盖API网关日志、数据库变更记录(CDC)、身份认证系统事件、第三方监管接口等十余种异构来源,格式包括JSON、CSV、Syslog、Protobuf等。为统一处理,团队构建了标准化的 数据预处理管道 ,包含四个关键阶段:接入、解析、 enrich(富化)、输出。

整个流程由Apache Flink驱动,拓扑结构如下图所示(示意):

[Kafka Sources]

↓

[Format Parser Function] → 错误队列(Dead Letter Queue)

↓

[Context Enricher: Join with User DB, GeoIP, Policy Table]

↓

[Anomaly Filter: Remove Heartbeats & Known Benign Patterns]

↓

[Output to Rule Engine Topic in Kafka]

核心代码示例如下:

public class DataPreprocessor implements MapFunction<String, ProcessedEvent> {

private transient RedisClient redis; // 缓存用户信息

@Override

public ProcessedEvent map(String rawJson) throws Exception {

RawEvent raw = JsonUtils.fromJson(rawJson, RawEvent.class);

// 1. 格式清洗:标准化字段命名

String normalizedAction = normalizeAction(raw.getAction());

// 2. 上下文富化:补充用户部门、角色、信任位置

UserInfo userInfo = redis.get("user:" + raw.getUserId());

if (userInfo == null) {

throw new ParseException("User info not found", raw.getUserId());

}

// 3. 地理位置解析

GeoLocation geo = IpLocationService.lookup(raw.getIp());

// 4. 构造标准化事件对象

return ProcessedEvent.builder()

.eventId(UUID.randomUUID().toString())

.timestamp(raw.getTimestamp())

.userId(raw.getUserId())

.userName(userInfo.getName())

.department(userInfo.getDept())

.role(userInfo.getRole())

.action(normalizedAction)

.resource(raw.getResource())

.ip(raw.getIp())

.country(geo.getCountry())

.city(geo.getCity())

.dataVolume(raw.getPayloadSize())

.build();

}

}

代码逻辑分析与扩展说明:

- 第1–5行 :输入为原始JSON字符串,首先反序列化为

RawEvent对象; - 第8行 :对动作字段做归一化处理,如将

"read_data"、"view"统一为"ACCESS",减少规则冗余; - 第10–13行 :通过Redis缓存加速用户属性查询,避免频繁访问主数据库;

- 第16行 :调用GeoIP服务解析IP归属地,用于后续地理围栏判断;

- 第19–27行 :构造标准化输出对象,确保下游规则引擎接收到一致结构的数据。

为保证数据质量,团队设计了一套完整的测试验证体系:

| 测试类型 | 工具/方法 | 目标 |

|---|---|---|

| 单元测试 | JUnit + TestContainers | 验证单个函数对边界输入的处理 |

| 集成测试 | Confluent Schema Registry + Karate DSL | 模拟Kafka消息流端到端验证 |

| 压力测试 | Apache Kafka Producer Perf Test | 验证10万条/秒吞吐下的延迟表现 |

| 数据一致性校验 | Deequ on Spark | 统计空值率、分布偏移、字段完整性 |

测试结果显示,在峰值流量下,端到端延迟稳定在800ms以内,数据丢失率为0,满足SLA要求。

4.2.2 预警阈值设定与误报率控制策略

尽管规则逻辑日趋完善,但在高并发环境下仍面临“过度报警”问题。为此,Mistral引入多层次的 阈值调控机制 与 上下文抑制策略 ,平衡灵敏性与可用性。

首先,采用 动态滑动窗口统计法 替代固定阈值。例如,对于“频繁登录失败”规则,传统做法设置“5分钟内失败5次即告警”,但无法区分自动化扫描攻击与临时密码错误。改进方案如下:

class DynamicThresholdDetector:

def __init__(self, baseline_days=7):

self.baseline = self.load_historical_avg(baseline_days)

def calculate_anomaly_score(self, current_rate, user_risk_level):

expected = self.baseline[user_risk_level]

z_score = (current_rate - expected) / self.std_dev(expected)

return min(z_score, 10) # capped at 10σ

def should_trigger_alert(self, score):

thresholds = {

'LOW': 3.0,

'MEDIUM': 2.5,

'HIGH': 2.0

}

return score > thresholds[self.user_risk_level]

该模型根据不同用户群体的历史行为基线(如普通员工 vs 系统管理员)动态调整敏感度,显著降低误报。

其次,实施 告警聚合与去重机制 。同一用户在短时间内触发多条相似规则时,系统自动合并为一条综合预警,并附带关联事件列表。例如:

【高危】用户

u_10293在过去15分钟内:

- 尝试登录失败 7 次(来自非常规IP)

- 访问3个非所属部门的敏感文件夹

- 下载总数据量达1.2GB综合风险评分:8.7/10 → 自动升级为P1级事件

最后,建立 静默期(Cooldown Period)机制 :对已处理过的用户或IP,在24小时内相同类型的事件不再重复提醒,防止运营疲劳。

通过以上组合策略,系统在保持92%风险检出率的同时,将每日有效告警数量从最初的上千条压缩至不足百条,真正实现了“少而精”的预警目标。

4.3 模型训练与上线部署实践

为进一步突破规则系统的局限,Mistral引入机器学习模型识别隐蔽性强、模式复杂的新型风险。整个过程遵循MLOps最佳实践,涵盖数据准备、模型训练、评估验证到灰度发布的全生命周期管理。

4.3.1 构建标注数据集并完成模型训练流水线

由于缺乏现成标签,团队采用 半监督标注框架 构建训练数据集。步骤如下:

- 使用初始规则集筛选出所有疑似违规事件(约12万条);

- 由三位资深合规官独立打标,采用多数投票法确定最终标签;

- 对不确定样本启动二次评审会议,达成共识;

- 引入SMOTE算法对少数类(正样本)进行过采样,缓解类别不平衡。

最终获得一个包含15万条样本、127维特征的数据集,主要特征类型包括:

| 特征类别 | 示例字段 | 处理方式 |

|---|---|---|

| 行为时序 | 登录频率、操作间隔方差 | Rolling Window Statistics |

| 资源敏感度 | 数据分类标签、加密状态 | One-hot Encoding |

| 网络环境 | IP信誉分、ASN编号 | 外部威胁情报对接 |

| 权限上下文 | 角色权限覆盖率、越权比例 | Ratio Calculation |

选用XGBoost作为基础模型,因其在结构化数据上表现优异且具备良好的可解释性。训练流水线基于Airflow编排,每日自动执行:

# DAG: compliance_model_training

schedule: "@daily"

tasks:

- extract_raw_events:

sql: "SELECT * FROM logs WHERE dt = '{{ ds }}'"

- preprocess_features:

python: feature_engineering.py

- train_xgboost:

script: train.py

params:

n_estimators: 200

max_depth: 8

scale_pos_weight: 5.2 # account for class imbalance

- evaluate_model:

metrics: [auc_roc, f1_score, precision@recall_90]

threshold: f1 > 0.85

- register_model_if_better:

condition: "current.f1 > latest.f1"

action: upload_to_S3_and_update_registry

每次训练完成后,模型性能指标自动录入Prometheus监控系统,并生成可视化报告供团队审阅。

4.3.2 A/B测试验证模型效果及灰度发布机制

新模型上线前必须经过严格的线上验证。Mistral采用 双轨并行+A/B分流 策略:

- 所有事件同时经过规则引擎和ML模型处理;

- 生产流量的10%被路由至ML决策分支,其余90%仍由规则主导;

- 对比两组的预警结果,重点关注漏报补偿率与新增真阳性发现。

测试期间发现,ML模型成功捕获了17%此前被规则遗漏的风险行为,尤其是跨系统协同作案(如先修改权限再导出数据)这类复合型攻击。同时,其误报率控制在15%以内,优于当前规则平均水平。

基于此,启动灰度发布计划:

| 阶段 | 流量占比 | 目标 | 持续时间 |

|---|---|---|---|

| Phase 1 | 5% | 验证服务稳定性 | 3天 |

| Phase 2 | 20% | 收集用户反馈 | 5天 |

| Phase 3 | 50% | 性能压测与容灾演练 | 7天 |

| Phase 4 | 100% | 全量切换,规则退居辅助角色 | —— |

每个阶段均设有熔断机制:若连续1小时告警延迟超过3秒或误报激增50%,则自动回滚至上一版本。

最终,该模型成为新一代风险识别中枢,与规则引擎形成互补——规则负责明确违规模式的快速拦截,模型则专注挖掘潜在异常,二者共同构成多层次防御体系。

5. 系统运行效果评估与持续优化机制

企业合规预警系统的价值不仅体现在技术架构的先进性与功能实现的完整性,更关键的是其在真实业务场景中的实际表现。当系统从开发环境进入生产部署阶段后,如何科学衡量其有效性、稳定性与适应性,成为决定项目成败的核心环节。Mistral构建的合规风险自动预警平台并非一次性交付的产品,而是一个需要长期演进、动态调优的智能生态系统。因此,必须建立一套涵盖量化指标、反馈闭环和迭代机制的综合评估体系,以确保系统能够随外部监管变化、内部流程调整和技术能力提升不断进化。

5.1 合规预警系统的关键性能指标(KPI)设计

有效的评估始于合理的指标设计。对于一个高敏感度、低容错率的合规预警系统而言,单一维度的评价难以全面反映其运行质量。需从 准确性、时效性、覆盖率、可用性 四个核心维度出发,构建多层级、可量化的KPI体系,并通过数据驱动的方式进行持续监控与分析。

5.1.1 预警准确性:误报率与漏报率的平衡控制

在风险识别任务中,准确性的核心体现是“既不错杀,也不放过”。为此引入两个基础指标:

- 误报率(False Positive Rate, FPR) = 误触发警报数 / 总触发警报数

- 漏报率(False Negative Rate, FNR) = 未检测出的真实风险事件数 / 真实风险事件总数

理想状态下两者均应趋近于0,但在实践中存在天然权衡。例如,若规则过于宽松,则FNR上升;反之则FPR升高。Mistral采用加权综合评分法来统一衡量整体准确性:

def calculate_accuracy_score(fp, fn, tp, tn, alpha=0.6):

"""

计算综合准确得分,alpha为漏报惩罚权重(通常>0.5)

参数说明:

- fp: false positives, 误报警次数

- fn: false negatives, 漏报警次数

- tp: true positives, 正确报警次数

- tn: true negatives, 正常行为正确忽略次数

- alpha: 对漏报的惩罚系数,越高越重视召回能力

"""

precision = tp / (tp + fp) if (tp + fp) > 0 else 0

recall = tp / (tp + fn) if (tp + fn) > 0 else 0

# 使用F-beta分数,强调召回率

beta = alpha / (1 - alpha)

f_beta = (1 + beta**2) * (precision * recall) / ((beta**2 * precision) + recall)

return round(f_beta, 4)

# 示例调用

score = calculate_accuracy_score(fp=18, fn=5, tp=92, tn=385, alpha=0.7)

print(f"综合准确得分为: {score}") # 输出: 0.8632

代码逻辑逐行解读 :

第1–7行:定义函数并注释参数含义,明确输入为混淆矩阵四要素及调节权重。

第8–9行:计算精确率(Precision)和召回率(Recall),作为F-score的基础。

第12行:根据

alpha推导出β值,使得当α=0.7时β≈2.33,表示对漏报施加更高惩罚。第13行:使用标准F-beta公式计算加权得分,兼顾Precision与Recall。

第15–16行:示例调用显示,在每日平均处理500条记录的情况下,系统达到约86%的有效识别水平。

该评分模型被集成至每日报表系统中,用于横向比较不同规则集或算法版本的表现差异。

| 指标名称 | 当前值 | 目标阈值 | 数据来源 | 更新频率 |

|---|---|---|---|---|

| 误报率 | 16.4% | ≤10% | 审计团队人工复核结果 | 每日 |

| 漏报率 | 5.0% | ≤3% | 历史违规事件回溯比对 | 每周 |

| 平均响应延迟 | 2.3s | ≤1.5s | Kafka-Flink链路埋点 | 实时 |

| 规则覆盖率 | 87% | ≥95% | 法规知识图谱映射统计 | 每月 |

| 系统可用性 | 99.82% | ≥99.9% | Prometheus监控 | 实时 |

此表格定期提交至风险管理委员会,作为系统健康状态的核心参考依据。

5.1.2 响应时效性:端到端预警延迟的测量方法

合规事件往往具有极强的时间敏感性。例如反洗钱交易需在交易发生后30秒内完成初步筛查,否则将影响后续拦截操作。为此,Mistral建立了完整的 时间戳追踪链 ,贯穿数据接入、规则匹配、告警生成全过程。

具体实施方式如下:

- 在每条原始日志中注入UTC时间戳

ingest_timestamp; - Flink作业在接收到消息时打上

process_start_time; - 规则引擎执行完毕后记录

alert_generated_time; - 最终通过Prometheus采集各节点差值,绘制延迟分布直方图。

// Flink中添加延迟监控的代码片段

public class LatencyMonitoringFunction extends ProcessFunction<LogEvent, AlertEvent> {

private transient OutputTag<LatencyMetric> latencyTag;

@Override

public void processElement(LogEvent event, Context ctx, Collector<AlertEvent> out) {

long currentTime = System.currentTimeMillis();

long ingestionDelay = currentTime - event.getIngestTimestamp(); // 数据入湖延迟

if (ingestionDelay > 5000) {

ctx.output(latencyTag, new LatencyMetric(

event.getTransactionId(),

"ingestion_delay",

ingestionDelay

));

}

// 执行规则匹配...

Optional<AlertEvent> alert = ruleEngine.match(event);

if (alert.isPresent()) {

long processingTime = System.currentTimeMillis() - currentTime;

alert.get().setEndToEndLatency(processingTime + ingestionDelay);

out.collect(alert.get());

}

}

}

代码解释与扩展说明 :

上述Java代码展示了Flink流处理过程中嵌入延迟监控的关键步骤。

- 第6行:声明一个侧输出通道

latencyTag,用于分离异常延迟数据,避免污染主数据流。- 第10–11行:计算从数据写入消息队列到被Flink消费之间的时间差,反映上游采集系统的负载情况。

- 第13–17行:若延迟超过5秒,则向侧输出发送一条独立的延迟指标,便于后续聚合分析。

- 第22行:将端到端总延迟附加在告警对象中,供可视化模块展示趋势变化。

结合Grafana看板,运维团队可实时观察P95/P99延迟曲线,及时发现网络拥塞或资源瓶颈。

通过此类细粒度监控,Mistral成功将平均端到端延迟从初始的4.7秒压缩至当前2.3秒,满足绝大多数合规场景的实时性要求。

5.1.3 覆盖广度:基于知识图谱的规则映射分析

除了运行态指标外,还需关注系统对法规要求的静态覆盖能力。Mistral采用 语义关联映射法 ,将现行有效的监管条款逐一映射至系统内建的规则库条目。

实现流程包括:

- 使用NLP模型提取法规文本中的主体、客体、行为动词与条件约束;

- 构建“法规条款 → 风险类型 → 检测规则”的三层映射关系;

- 利用图数据库Neo4j存储该结构,支持路径查询与缺口分析。

// 查询未被任何规则覆盖的GDPR条款

MATCH (l:Law {name: "GDPR"})-[:HAS_ARTICLE]->(a:Article)

OPTIONAL MATCH (a)-[:MAPS_TO]->(r:Rule)

WHERE r.status = "active"

WITH a, COUNT(r) AS rule_count

WHERE rule_count = 0

RETURN a.number AS article_number, a.text LIMIT 10;

Cypher查询逻辑分析 :

- 第1行:定位名为“GDPR”的法律实体及其下属条款节点。

- 第2行:尝试匹配每个条款所映射的活跃规则。

- 第3–4行:统计每个条款对应的规则数量,仅保留无映射的条款。

- 第5–6行:返回缺失映射的具体条款编号与原文内容,供合规专家补充规则。

此类自动化缺口扫描每周执行一次,确保新发布的监管指引能在两周内完成规则转化与上线测试。

5.2 动态调优机制:面向变化的自适应策略

合规环境的本质特征是“变”,无论是欧盟新增AI法案,还是国内金融监管细则更新,都会直接影响系统的判断边界。静态规则库无法应对这种高频变动,必须建立动态调优机制,使系统具备持续学习与自我修正的能力。

5.2.1 基于反馈闭环的规则权重调整

Mistral引入了 专家反馈评分机制 ,允许合规官在处理每条预警时标注其有效性(如:有效/误报/严重程度)。这些反馈数据被汇总为“规则效能指数”(Rule Effectiveness Index, REI),用于自动调整规则触发优先级。

REI计算公式如下:

\text{REI}_i = w_1 \cdot \frac{TP_i}{TP_i + FP_i} + w_2 \cdot \left(1 - \frac{FN_i}{FN_i + TP_i}\right) - w_3 \cdot C_i

其中:

- $ TP_i, FP_i, FN_i $:第i条规则的历史命中情况

- $ C_i $:该规则引发的人工复核成本(工时×费率)

- $ w_1, w_2, w_3 $:分别为精度、召回、成本的调节权重

系统每月重新计算所有规则的REI,并按降序排列,低分规则进入“观察名单”,暂停生效或降低权重。

| 规则ID | 描述 | TP | FP | FN | 成本(小时) | REI得分 | 操作建议 |

|---|---|---|---|---|---|---|---|

| R-203 | 单日跨境转账超$50k | 45 | 8 | 2 | 1.2 | 0.91 | 维持启用 |

| R-117 | 用户频繁修改邮箱 | 6 | 32 | 1 | 3.5 | 0.32 | 加入观察名单 |

| R-309 | 登录地点突变+大额提现 | 28 | 5 | 0 | 2.1 | 0.94 | 提升优先级 |

该机制显著提升了规则库的整体信噪比,过去三个月内误报总量下降38%。

5.2.2 模型参数在线微调与A/B测试验证

针对机器学习组件(如异常登录检测模型),Mistral采用 渐进式更新策略 。每当新标注数据积累至一定规模(≥500条),便启动增量训练流程,并通过A/B测试验证新旧模型表现差异。

测试流程如下:

- 将流量按用户ID哈希拆分为A组(旧模型)、B组(新模型);

- 运行7天,收集两组的FPR、FNR、响应延迟;

- 使用t检验判断性能差异是否显著(p < 0.05);

- 若胜出,则逐步扩大B组比例直至全量切换。

# A/B测试配置文件示例(YAML格式)

ab_test:

experiment_name: "login_anomaly_v3_vs_v2"

control_group:

version: "v2.1"

traffic_ratio: 0.5

treatment_group:

version: "v3.0"

traffic_ratio: 0.5

metrics:

primary: ["false_negative_rate"]

secondary: ["false_positive_rate", "latency_p95"]

duration_days: 7

auto_promote: true

配置项说明 :

experiment_name:实验唯一标识符,便于追踪。traffic_ratio:控制组与实验组的流量分配比例,初期可设为90%/10%降低风险。primary:主要观测指标,决定胜负的关键标准。auto_promote:是否在达标后自动推广新版本,减少人工干预。

该机制保障了模型迭代的安全性与可控性,避免因一次错误升级导致大规模误判。

5.3 用户体验反馈与界面优化路径

技术指标之外,系统的“可用性”同样重要。一线合规人员的操作体验直接影响其采纳意愿与工作效率。为此,Mistral设立了多通道反馈机制,并据此推动前端交互持续优化。

5.3.1 多源反馈渠道建设

目前系统提供以下三种反馈入口:

- 告警详情页评分按钮 :处理完预警后可点击“有用/无用”;

- 月度问卷调研 :面向全体合规官收集改进建议;

- 日志行为分析 :记录页面停留时间、跳转路径、重复操作等隐式信号。

所有反馈经NLP情感分析归类后,形成“痛点热力图”,指导UI重构优先级。

5.3.2 可视化界面优化实例

早期版本中,风险事件列表仅显示基础字段(时间、用户、类型),缺乏上下文信息,导致平均处理时间长达8分钟。优化后新增“风险脉络图”组件,整合以下信息:

- 用户历史行为轨迹

- 关联设备/IP画像

- 近期同类事件趋势

- 推荐处置建议(基于相似案例)

{

"event_id": "EV-20240405-00173",

"user": "u11928",

"risk_level": "high",

"context": {

"recent_logins": [

{"time": "2024-04-05T08:12Z", "ip": "192.168.1.10", "city": "Shanghai"},

{"time": "2024-04-05T15:23Z", "ip": "104.28.1.7", "city": "Los Angeles"}

],

"related_transactions": [

{"tx_id": "TX-8821", "amount": 48200, "currency": "USD", "status": "completed"}

],

"similar_cases": [

{"case_id": "INC-202311-044", "resolution": "fraud_confirmed", "action_taken": "account_suspended"}

]

},

"recommendations": [

"Initiate step-up authentication",

"Freeze outgoing transfers for 24h",

"Escalate to fraud investigation team"

]

}

JSON结构解析 :

event_id和user提供基本定位信息;context.recent_logins显示地理位置突变,增强可疑性判断;related_transactions关联资金流动,辅助定性;similar_cases引用历史判例,提升决策一致性;recommendations由规则引擎自动生成,缩短响应时间。

上线后,平均处理时长降至3.2分钟,用户满意度评分从3.1升至4.6(满分5分)。

综上所述,Mistral通过构建多层次、跨维度的评估与优化体系,实现了合规预警系统从“能运行”到“运行得好”的跨越。这一机制不仅保障了当前系统的稳定高效运作,也为未来向预测型、自治型智能合规平台演进奠定了坚实基础。

6. 企业级合规智能平台的未来演进方向

6.1 基于大语言模型的法规解读与合规咨询自动化

随着自然语言处理技术的飞速发展,尤其是大语言模型(LLM)在语义理解、上下文推理和文本生成方面的突破,将其应用于企业合规管理已成为可能。传统法规查阅依赖人工逐条比对,效率低且易遗漏关键条款。而基于LLM的合规助手可实现对全球多语言法规文档的自动解析,并以对话式交互方式回答合规官提出的问题。

例如,使用微调后的Llama-3或ChatGLM等开源大模型,结合企业专属的合规知识图谱,构建一个领域专用的“合规法律顾问”系统:

from transformers import AutoTokenizer, AutoModelForCausalLM

import torch

# 加载预训练模型并接入企业知识库向量索引

model_name = "chatglm3-6b"

tokenizer = AutoTokenizer.from_pretrained(model_name, trust_remote_code=True)

model = AutoModelForCausalLM.from_pretrained(model_name, trust_remote_code=True)

def query_compliance(question: str, context: str):

input_text = f"根据以下法规内容:{context}。请回答:{question}"

inputs = tokenizer(input_text, return_tensors="pt", truncation=True, max_length=2048)

with torch.no_grad():

outputs = model.generate(

inputs.input_ids,

max_new_tokens=512,

temperature=0.7,

top_p=0.9,

do_sample=True

)

response = tokenizer.decode(outputs[0], skip_special_tokens=True)

return response.replace(input_text, "").strip()

# 示例调用

regulation_context = """

《GDPR》第17条规定,数据主体有权要求删除其个人数据,特别是在数据不再必要、撤回同意或反对处理的情况下。

question = "用户申请注销账户时,我们应在多久内删除其个人信息?"

answer = query_compliance(question, regulation_context)

print(answer)

该系统的执行逻辑如下:

- 输入处理 :将用户提问与从知识图谱中检索到的相关法规片段拼接为提示词(Prompt);

- 推理生成 :利用本地部署的大模型进行推理,避免敏感数据外泄;

- 输出控制 :通过模板约束响应格式,确保结果具备法律严谨性,并附带引用来源。

为进一步提升准确性,系统应集成RAG(Retrieval-Augmented Generation)架构,优先从可信法规数据库中检索依据,再交由模型组织语言输出。

6.2 因果推理机制在风险溯源中的应用

当前的风险识别多停留在相关性分析层面,难以判断违规行为的根本动因。引入因果推理(Causal Inference)技术,有助于揭示变量间的因果关系,如“员工权限变更是否直接导致数据异常访问”。

可通过构建结构化因果模型(SCM),定义合规事件中的关键变量及其依赖路径:

| 变量名 | 类型 | 说明 |

|---|---|---|

| A | 二值变量 | 是否发生权限越权 |

| B | 连续变量 | 日均API调用次数 |

| C | 分类变量 | 用户角色类型(管理员/普通用户) |

| D | 时间序列 | 登录地理位置变化频率 |

基于上述变量,使用Do-Calculus框架评估干预效应:

$$ P(Damage \mid do(PermissionChange)) = \sum_{Z}P(Damage \mid Z, PermissionChange)P(Z) $$

其中 $ Z $ 表示混杂因子(如部门调整、系统升级)。通过历史日志训练贝叶斯网络或使用Pyro等概率编程工具建模,系统可自动推断某次数据泄露是否“很可能由权限滥用引起”,而非仅报告“两者同时发生”。

此外,在Flink流处理引擎中嵌入轻量级因果检测模块,实现实时归因预警。例如当检测到高敏感数据访问激增时,立即触发因果链分析流程,辅助风控人员快速锁定责任源头。

6.3 全域业务系统融合与合规态势感知网络建设

未来的合规平台必须打破系统孤岛,深度集成ERP、CRM、HR、财务系统等核心业务模块,形成统一的合规数据中枢。通过建立跨系统的事件关联规则,实现全景式风险监控。

实施步骤如下:

1. 接口标准化 :采用OpenAPI规范统一各系统数据输出格式;

2. 事件标签化 :为每类操作打上合规语义标签(如“客户数据导出”、“合同审批变更”);

3. 时间对齐与上下文重建 :利用Kafka Streams对多源事件进行窗口聚合与因果排序;

4. 可视化态势面板开发 :基于Grafana+Elasticsearch展示全公司合规健康度评分。

下表展示部分跨系统联动场景:

| 业务系统 | 触发事件 | 联动监测目标 | 风险等级 |

|---|---|---|---|

| HR系统 | 员工离职流程启动 | 检查其是否有未关闭的数据访问权限 | 高 |

| CRM系统 | 客户投诉记录新增 | 核查近期是否存在违规营销外呼 | 中 |

| ERP系统 | 采购订单金额突增 | 匹配供应商黑名单及利益冲突规则 | 高 |

| 邮件网关 | 外发附件含PII字段 | 结合DLP策略判断是否加密传输 | 中 |

此类联动不仅提升检出能力,还能支持“合规影响评估”功能——在新政策发布后,模拟其对各业务流程的影响范围,提前预警潜在冲突点。

6.4 联邦学习支持下的跨组织合规协同机制

在全球化运营背景下,企业常需与合作伙伴共享合规责任(如供应链反贿赂审查)。然而数据隐私限制使得集中式建模不可行。联邦学习(Federated Learning)为此提供了理想解决方案。

设想场景:多家金融机构联合训练反洗钱模型,但各自交易数据不能出域。采用横向联邦学习架构:

# 各参与方本地训练代码示意(基于PySyft)

import syft as sy

import torch.nn as nn

# 定义本地模型

class AMLModel(nn.Module):

def __init__(self):

super().__init__()

self.fc = nn.Linear(128, 1)

def forward(self, x):

return torch.sigmoid(self.fc(x))

# 注册虚拟计算节点

hook = sy.TorchHook(torch)

client = sy.VirtualWorker(hook, id="bank_a")

# 本地训练后上传梯度

local_model = AMLModel()

# ... 训练过程

updated_gradients = compute_gradients(local_model, local_data)

# 加密聚合(使用同态加密)

secure_aggregator.send_gradients(updated_gradients)

中央服务器定期聚合来自各方的加密梯度,更新全局模型并下发,从而实现“数据不动模型动”的合规协作新模式。此机制同样适用于跨国企业内部不同法域之间的规则适配学习。

最终目标是打造一个具备自学习、可解释、跨边界协同能力的智能合规中枢,使企业在复杂监管环境中保持敏捷与韧性。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)