Python深度学习:从入门到精通

亲爱的读者,欢迎您翻开这本书。我们即将探索的,是深度学习的宇宙——一个由数据、算法与算力构筑的奇妙世界。它既是严谨的科学,也是创造的艺术,更是一条通往未来智慧的修行之路。本书将带您从最基础的数学原理出发,亲手搭建神经网络,驾驭Transformer等前沿模型,最终将智慧转化为现实世界的价值。请放下畏惧,保持好奇。这不仅是一次知识的学习,更是一场思维的远行。来,随我一起,开启这趟非凡的旅程吧。

目录

第一部分:基础篇 —— 奠定智慧的基石

第1章:开启深度学习之旅

- 1.1 人工智能、机器学习与深度学习:正本清源,理解三者关系。

- 1.2 深度学习的“前世今生”:从赫布理论到神经网络的复兴。

- 1.3 为何选择Python?—— 生态、社区与哲学的统一。

- 1.4 本书的结构与学习路径图:如何高效地利用这本书。

- 1.5 心法总纲:保持好奇、勤于实践、拥抱开源。

第2章:数学与编程基础 —— 内功心法

- 2.1 线性代数:向量、矩阵、张量及其运算(不仅是计算,更是空间的变换)。

- 2.2 微积分:导数、偏导数、链式法则与梯度(理解变化与优化的语言)。

- 2.3 概率论与信息论:概率分布、期望、熵与交叉熵(衡量不确定性与信息)。

- 2.4 NumPy:精通多维数组操作,为数据处理提速。

- 2.5 Pandas:结构化数据的探查、清洗与预处理。

- 2.6 Matplotlib & Seaborn:数据的可视化,让洞察直观呈现。

第3章:机器学习经典回顾 —— 温故而知新

- 3.1 机器学习的三大范式:问道于天地。

- 3.2 经典模型剖析:一花一世界,一叶一菩提。

- 3.3 模型的评估与优化:知其然,更要知其所以然。

第二部分:核心篇 —— 深入神经网络的殿堂

第4章:神经网络基础

- 4.1 从生物神经元到人工神经元:模型的灵感来源。

- 4.2 感知机模型:最简单的神经网络及其局限性。

- 4.3 多层感知机(MLP):构建深度网络的第一步。

- 4.4 激活函数大全:Sigmoid、Tanh、ReLU、Leaky ReLU、ELU等(为何需要非线性)。

- 4.5 损失函数:MSE、交叉熵等(衡量“理想”与“现实”的差距)。

- 4.6 反向传播算法:梯度下降与链式法则的完美结合(网络如何学习)。

第5章:深度学习框架入门与实战

- 5.1 TensorFlow 2.x 与 Keras:Google的工业级解决方案。

- 5.2 PyTorch:Facebook的动态图与研究者首选。

- 5.3 环境搭建:Conda、Jupyter Notebook与GPU配置指南。

第6章:深度学习的“炼丹术” —— 训练与优化

- 6.1 优化器详解:SGD、Momentum、Adagrad、RMSprop、Adam。

- 6.2 正则化技术:L1/L2正则化、Dropout、早停(防止模型“走火入魔”)。

- 6.3 批归一化(Batch Normalization):加速收敛的利器。

- 6.4 超参数调优:网格搜索、随机搜索与贝叶斯优化。

- 6.5 权重初始化策略:Xavier、He初始化等。

第三部分:进阶篇 —— 掌握核心网络架构

第7章:卷积神经网络(CNN) —— 洞悉图像的奥秘

- 7.1 CNN的核心思想:局部连接、权值共享与池化。

- 7.2 卷积层、池化层与全连接层详解。

- 7.3 经典CNN架构演进:LeNet-5, AlexNet, VGG, GoogLeNet , ResNet。

- 7.4 迁移学习与微调(Fine-tuning):站在巨人的肩膀上。

- 7.5 CNN应用:图像分类、目标检测(YOLO, Faster R-CNN)、图像分割。

第8章:循环神经网络(RNN) —— 理解序列的智慧

- 8.1 RNN的结构与挑战:短期记忆与梯度消失/爆炸问题。

- 8.2 长短期记忆网络(LSTM):记忆门的设计哲学。

- 8.3 门控循环单元(GRU):LSTM的简化与变体。

- 8.4 双向RNN与深度RNN。

- 8.5 RNN应用:自然语言处理(文本分类、情感分析)、时间序列预测。

第9章:注意力机制与Transformer —— 现代NLP的基石

- 9.1 注意力(Attention)机制的原理与魅力。

- 9.2 Transformer架构详解:自注意力、多头注意力、位置编码。

- 9.3 BERT、GPT及其他预训练语言模型:新范式的崛起。

- 9.4 Transformer在计算机视觉中的应用(Vision Transformer, ViT)。

第10章:生成式模型 —— 创造与想象

- 10.1 生成对抗网络(GAN):生成器与判别器的博弈。

- 10.2 变分自编码器(VAE):概率生成的美学。

- 10.3 扩散模型(Diffusion Models):从噪声中生成高清图像的艺术。

- 10.4 应用:图像生成、风格迁移、数据增强。

第四部分:实战篇 —— 从理论到价值的转化

第11章:项目实战:计算机视觉

- 11.1 图像分类:构建一个垃圾分类系统。

- 11.2 目标检测:实现一个实时人脸或车辆检测器。

- 11.3 图像风格迁移:将照片变成梵高风格的油画。

第12章:项目实战:自然语言处理

- 12.1 文本情感分析:分析电影评论的情感倾向。

- 12.2 机器翻译:构建一个简单的中英翻译模型。

- 12.3 智能问答机器人:基于知识库的问答系统。

第13章:项目实战:其他领域

- 13.1 时间序列预测:预测股票价格或天气变化。

- 13.2 推荐系统:使用深度学习构建电影或商品推荐引擎。

- 13.3 强化学习入门:使用深度Q网络(DQN)玩转简单游戏。

第14章:模型部署与工程化

- 14.1 模型轻量化:剪枝、量化与知识蒸馏。

- 14.2 模型部署:ONNX、TensorFlow Serving、TorchServe。

- 14.3 将模型封装为API服务(使用Flask或FastAPI)。

- 14.4 MLOps简介:数据、模型与代码的版本控制。

第五部分:展望篇 —— 探索未来的边界

第15章:前沿专题与未来趋势

- 15.1 图神经网络(GNN):处理非欧几里得数据。

- 15.2 联邦学习:隐私保护下的分布式学习。

- 15.3 可解释性AI(XAI):打开神经网络的“黑箱”。

- 15.4 多模态学习:融合文本、图像与声音。

- 15.5 AI伦理与社会责任:作为技术创造者的思考。

附录:行者的“宝库”与“路书”

- A:常用数据集与资源链接。

- B:数学符号表。

- C:常见问题与排错指南。

- D:进一步阅读建议。

第一部分:基础篇 —— 奠定智慧的基石

第一章:开启深度学习之旅

- 1.1 人工智能、机器学习与深度学习:正本清源,理解三者关系。

- 1.2 深度学习的“前世今生”:从赫布理论到神经网络的复兴。

- 1.3 为何选择Python?—— 生态、社区与哲学的统一。

- 1.4 本书的结构与学习路径图:如何高效地利用这本书。

- 1.5 心法总纲:保持好奇、勤于实践、拥抱开源。

亲爱的读者,当您翻开这一页,您正站在一个时代的入口。这个时代由数据驱动,由算法赋能,它的核心引擎,便是我们即将深入探索的“深度学习”。它不仅是工程师和科学家的工具,更是一种全新的思维方式,正在以磅礴之势重塑我们所知的世界。本章将作为您的向导,为您描绘一幅宏大的地图,让您明白我们从何而来,身在何处,又将去向何方。

1.1 人工智能、机器学习与深度学习:正本清源,理解三者关系

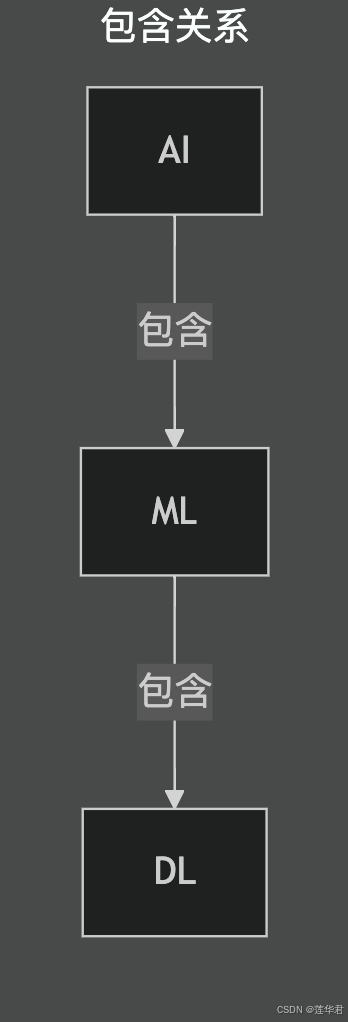

在踏上深度学习的奇妙旅程之前,我们必须先校准罗盘,明确几个最基本却也最容易混淆的概念:人工智能(Artificial Intelligence, AI)、机器学习(Machine Learning, ML)和深度学习(Deep Learning, DL)。它们并非同义词,而是一个层层递进、相互包含的有机整体。理解它们之间的精妙关系,是您构建清晰认知框架的第一步。

1.1.1 人工智能(AI):最初的梦想与宏大愿景

人工智能,是这场伟大探索的终极梦想。它的核心目标,是创造出能够像人类一样思考、学习、感知和行动的智能机器。这个梦想,如同一颗古老的星辰,在人类文明的夜空中闪耀了数千年,从古希腊神话中的自动机械,到中世纪炼金术士的“人造人”传说,无不寄托着人类对创造智慧生命的无限遐想。

什么是人工智能?

在现代科学语境下,人工智能的正式诞生,通常被追溯到1956年的达特茅斯会议。一群富有远见的科学家齐聚一堂,首次提出了“人工智能”这一术语,并对其进行了初步定义:让机器能够执行通常需要人类智能才能完成的任务。其中,英国数学家、逻辑学家艾伦·图灵在1950年提出的著名“图灵测试”,至今仍是衡量机器是否具备智能的经典标准:如果一台机器能够与人类进行对话,而人类无法分辨出对方是机器还是人,那么我们就可以认为这台机器具备了智能。

人工智能的宏大愿景,又可细分为两个层次:

- 强人工智能(Strong AI): 指的是能够真正拥有自我意识、具备与人类同等甚至超越人类智慧的通用智能体。它能够像人类一样进行抽象思维、解决通用问题、甚至拥有情感和创造力。这是科幻电影中常见的题材,也是我们追求的星辰大海,但目前仍处于理论探索和遥远未来的阶段。

- 弱人工智能(Weak AI)或称应用型人工智能: 指的是专注于在特定任务上模拟甚至超越人类表现的智能系统。例如,您的手机语音助手、为您精准推荐电影的算法、以及在围棋盘上战胜世界冠军的AlphaGo。本书所讨论的一切,都属于弱人工智能的范畴,它们在特定领域展现出令人惊叹的智能,但并不具备通用智能和自我意识。

AI的发展简史:

AI的发展并非一帆风顺,它如同一条蜿蜒曲折的河流,经历了数个“黄金时代”与“AI寒冬”的交替。早期,研究者们对基于逻辑推理和符号操作的“专家系统”寄予厚望,取得了一些初步成功。然而,当这些系统面对现实世界中海量、模糊、不确定的数据时,其局限性便暴露无遗。当期望无法兑现,资金和热情便会退潮,AI研究便进入“寒冬”。然而,正是这些起伏,促使研究者们不断反思,最终找到了一条更具潜力的道路——让机器自己去学习,从数据中发现规律,而非依赖人类预设的僵硬规则。这为机器学习的兴起埋下了伏笔。

1.1.2 机器学习(ML):实现人工智能的核心途径

如果说人工智能是“造出聪明的机器”这个宏伟目标,那么机器学习就是实现这个目标最主流、最有效的一条路径。它的核心思想,正如其名,是让机器拥有学习的能力,从经验中自动改进其性能。

什么是机器学习?

计算机科学家亚瑟·萨缪尔(Arthur Samuel)在1959年给出了一个经典且精辟的定义:“机器学习是在没有被明确编程的情况下,给予计算机学习能力的研究领域。”

这意味着,我们不再像传统编程那样,为机器编写详尽的指令(例如:“如果输入是猫的图片,那么判断为猫”)。取而代之的是,我们给机器提供大量的数据(例如,成千上万张猫的图片),并设计一个算法,让它从这些数据中自动发现规律、模式,甚至生成知识。这就像教一个孩子认识猫:您不是告诉他“猫有两只耳朵、四条腿、一条尾巴……”,而是不断地指着各种各样的猫告诉他“这是猫”,久而久之,他自然就学会了识别猫,即使遇到前所未见的品种,也能举一反三。

机器学习的范畴:

根据学习方式和数据特性的不同,机器学习主要分为三大范式,它们构成了机器学习领域的核心骨架:

- 监督学习(Supervised Learning): 这是最常见的一种学习范式。我们提供给机器的数据是“带标签”的,就像有标准答案的练习册。模型通过学习输入数据(特征)与对应输出(标签)之间的映射关系来做出预测。例如,给模型成千上万封邮件,并明确标明哪些是“垃圾邮件”,哪些是“正常邮件”,让它学会分类;或者根据房屋面积、卧室数量等特征,预测房屋价格。

- 无监督学习(Unsupervised Learning): 与监督学习不同,无监督学习提供给机器的数据是没有标签的,就像一本没有答案的习题集。机器需要自己去发现数据中隐藏的结构、模式或关联性。例如,将海量用户数据进行聚类,找出具有相似兴趣的群体;或者通过降维技术,发现数据中最重要的潜在特征。

- 强化学习(Reinforcement Learning): 这是一种通过“试错”来学习的范式。我们不给机器明确的输入-输出对,而是给它一个目标和一个奖惩系统。机器(代理)通过不断地与环境进行交互,根据环境的反馈(奖励或惩罚)来学习如何采取行动以获得最大的累积奖励。AlphaGo下围棋、机器人学习行走,都是强化学习最典型的应用。它让机器学会了如何在复杂动态的环境中做出最优决策。

1.1.3 深度学习(DL):机器学习的强大分支

现在,我们来到了这场探索的核心——深度学习。如果说机器学习是让人工智能得以实现的康庄大道,那么深度学习就是这条大道上目前最快、最强大的超级跑车。它以其卓越的性能和广泛的应用,将人工智能推向了前所未有的高度。

什么是深度学习?

从技术上讲,深度学习的本质是使用“深层”人工神经网络(Deep Neural Networks, DNN)的机器学习技术。这里的“深”(Deep),是其最关键的特征,指的是神经网络的层数非常多,有时可达数十甚至上千层。这些层级并非简单堆叠,而是通过复杂的连接和非线性变换,共同协作,从原始数据中逐层提取和抽象出越来越高级的特征。

这个思想的灵感,精妙地源自于我们人类自己的大脑视觉皮层。当我们看到一只猫时,您的大脑并非“一步到位”就完成了识别。真实的过程是一个高度层次化的信息处理流程:

- 底层神经元可能只对视野中非常简单的模式做出反应,比如光点、边缘、特定的颜色或角度。

- 这些底层信息被汇集到中层神经元,它们将简单的模式组合成稍微复杂的局部特征,比如眼睛的轮廓、胡须的线条、耳朵的三角形状。

- 信息继续向上传递,更高层的神经元再将这些局部特征进行组合,最终形成“猫”这个完整的、抽象的概念。

深度学习正是模拟了这种层次化的特征学习(Hierarchical Feature Learning)机制。通过构建一个多层的网络结构,深度学习模型能够自动地从最原始的输入数据中(例如,图像的像素点),逐层学习到从简单到复杂的特征,最终完成识别、分类或生成等高级任务。这种端到端(End-to-End)的自动学习特征的能力,是它相较于传统机器学习算法最强大、最具颠覆性的优势之一,极大地简化了特征工程的复杂性。

三者关系的可视化:

为了让您对这三者的关系有一个直观且牢固的印象,我们可以用一个关系图来描绘它们:

- 人工智能(AI) 是最上层的生态,代表着我们创造智能机器的宏大愿景和整个研究领域。

- 机器学习(ML) 是中间层的架构,它是实现人工智能的一种核心方法论,其核心是让机器从数据中学习。

- 深度学习(DL) 是最内层的核心,它是机器学习技术中的一个极其强大且成果斐然的分支,它以深层神经网络为主要工具,实现了高效的层次化特征学习。

现在,您可以自信地向他人解释:深度学习是实现机器学习的一种流行且强大的技术,而机器学习是通往人工智能的一条核心路径。 我们学习深度学习,正是为了掌握当前实现人工智能最强大的那把钥匙,开启通往未来智能世界的大门。

1.2 深度学习的“前世今生”:从赫布理论到神经网络的复兴

任何一门伟大的技术,都不是凭空出现的。深度学习的发展史,如同一部波澜壮阔的史诗,充满了天才的洞见、长久的沉寂、不懈的坚守与最终的辉煌。了解这段历史,能让我们更深刻地理解其核心思想的演进,从而更好地把握其未来走向。

1.2.1 思想的萌芽:理论奠基时代(1940s-1960s)

深度学习的根源,可以追溯到上世纪中叶对人脑神经元工作机制的初步探索。

赫布理论与感知机: 1949年,加拿大心理学家唐纳德·赫布(Donald Hebb)提出了著名的赫布理论(Hebb's Rule),其核心思想是“一起激发的神经元会连接在一起”(Cells that fire together, wire together)。这为神经网络的学习机制提供了生物学上的启发和理论基础。基于此,1958年,美国心理学家弗兰克·罗森布拉特(Frank Rosenblatt)发明了感知机(Perceptron),这是第一个能够通过学习来解决问题的神经网络模型。它能够对输入进行二元分类,在当时引起了巨大的轰动,被视为人工智能的曙光。

“异或”问题与第一次寒冬: 然而,初生的喜悦是短暂的。1969年,人工智能领域的先驱马文·明斯基(Marvin Minsky)和西摩尔·佩普特(Seymour Papert)在其著作《感知机》(Perceptrons)中,从数学上严格证明了单层感知机无法解决线性不可分问题,其中最著名的例子就是“异或”(XOR)问题。这个结论给当时过于乐观的神经网络研究泼了一盆冷水,导致了该领域的资金和研究兴趣急剧下降,神经网络研究进入了长达近20年的第一次“AI寒冬”。许多研究者转向了基于逻辑和符号推理的AI方向。

1.2.2 沉寂中的坚守:连接主义的复兴(1980s-1990s)

尽管处于寒冬,但仍有一批坚定的研究者(被称为“连接主义者”)在默默坚守,他们相信神经网络的潜力。转机出现在20世纪80年代。

反向传播算法的普及: 1986年,由戴维·鲁姆哈特(David Rumelhart)、杰弗里·辛顿(Geoffrey Hinton)和罗纳德·威廉姆斯(Ronald Williams)等人推广的反向传播(Backpropagation)算法,有效地解决了多层神经网络的训练难题。它利用微积分中的链式法则,能够高效地计算出损失函数对网络中每一层参数的梯度,从而对网络进行迭代更新。反向传播算法的成熟,是神经网络能够处理复杂任务的关键一步,至今仍是深度学习的核心算法。

经典模型的诞生: 有了训练方法,多层网络的威力开始显现。1998年,杨立昆(Yann LeCun)等人提出的LeNet-5模型,一个经典的卷积神经网络(Convolutional Neural Network, CNN),在手写数字识别任务上取得了巨大成功,并被广泛应用于银行的支票识别系统中。这证明了深层网络在真实世界问题中的应用潜力,尤其是在图像处理领域。

1.2.3 爆发的前夜:瓶颈与突破(2000s-2010s)

进入21世纪初,尽管有了反向传播和LeNet-5的成功,但深度学习的发展再次陷入瓶颈,被称为第二次“AI寒冬”。这主要源于三大挑战,它们如同三座大山,阻碍着深度学习的进一步发展:

- 梯度消失/爆炸问题: 在深层网络中,梯度在反向传播时会逐层衰减(消失)或急剧增大(爆炸),导致靠近输入层的网络无法得到有效训练,模型难以收敛。

- 算力不足: 训练深度网络需要巨大的计算量,当时的CPU性能远不能满足需求,使得训练时间过长,难以进行大规模实验。

- 数据匮乏: 深度学习是数据驱动的,需要海量标注数据才能发挥其优势。而当时缺乏大规模、高质量、带标签的公开数据集,限制了模型的训练规模和泛化能力。

然而,正是为了解决这些问题,三大关键的催化剂应运而生,它们如同三把火炬,共同点燃了深度学习复兴的火焰:

- 算法突破: 研究者们提出了新的激活函数(如ReLU,修正线性单元)来有效缓解梯度消失问题,以及新的正则化技术(如Dropout)来防止过拟合,提高模型的泛化能力。此外,预训练(Pre-training)和微调(Fine-tuning)等技术也开始崭露头角。

- 算力飞跃: 人们发现,用于图形渲染的GPU(图形处理器)其大规模并行计算的架构,天然适合神经网络的矩阵运算。NVIDIA等公司开始提供用于通用计算的GPU(GPGPU),使得训练速度提升了数十甚至上百倍,为深度学习的大规模实验提供了硬件基础。

- 数据爆炸: 互联网的普及带来了海量数据。更重要的是,像由李飞飞教授团队创建的ImageNet这样包含数百万张带标签图像的大型公开数据集的出现,为训练和评测深度模型提供了前所未有的“燃料”,使得模型能够从海量真实数据中学习到更丰富、更鲁棒的特征。

1.2.4 黄金时代:AlexNet至今(2012-至今)

三大催化剂的汇聚,最终在2012年引爆了深度学习的黄金时代。

AlexNet的里程碑意义: 2012年,在ImageNet图像识别挑战赛上,由杰弗里·辛顿(Geoffrey Hinton)的学生亚历克斯·克里热夫斯基(Alex Krizhevsky)所设计的AlexNet模型,以远超第二名(超过10个百分点)的惊人准确率夺得冠军。它成功地将ReLU、Dropout、GPU加速等技术融于一个深层卷积神经网络中,其压倒性的胜利,无可辩驳地向全世界宣告:深度学习的时代,正式到来。 这也标志着人工智能领域从“符号主义”向“连接主义”的范式转移。

百花齐放: AlexNet之后,深度学习进入了爆炸式发展的黄金时代。VGG、GoogLeNet、ResNet等更深、更精巧的CNN架构不断刷新着图像识别的记录,推动了计算机视觉领域的飞速发展;循环神经网络(RNN)及其变体长短期记忆网络(LSTM)在处理序列数据(如文本和语音)上大放异彩,为自然语言处理和语音识别带来了革命;生成对抗网络(GAN)让我们看到了机器创造的可能,生成逼真的图像和艺术作品;而近年来,Transformer架构更是颠覆了自然语言处理领域,催生了BERT、GPT等一系列预训练大模型,并开始在计算机视觉等多个领域展现其统治力。

深度学习,已然成为人工智能领域最耀眼的主旋律,其应用已渗透到我们生活的方方面面,从智能手机到自动驾驶,从医疗诊断到科学研究,无不闪耀着其智慧的光芒。

1.3 为何选择Python?—— 深度学习的“应许之地”

在深度学习的宏大叙事中,编程语言是我们赖以将思想蓝图构筑为现实奇观的基石。而在众多优秀的编程语言中,Python以一种近乎“天选”的姿态,成为了深度学习乃至整个数据科学领域的通用语(Lingua Franca)。

这种压倒性的优势并非偶然,而是源于其内在哲学、外在生态与社区文化三者的完美共鸣,共同将Python塑造成了深度学习的“应许之地”。对于有志于此的探索者而言,理解Python为何胜出,就如同剑客懂得自己手中之剑的特性,是踏上征途前的重要一课。

1.3.1 “开发效率优先”的内在哲学

Python的核心设计哲学,可以用“The Zen of Python”(Python之禅)中的几句话来概括:“优美胜于丑陋,明了胜于晦涩,简洁胜于复杂”。这种对可读性和简洁性的极致追求,直接转化为无与伦比的开发效率。

低认知负荷: Python的语法结构清晰,接近自然语言,让开发者可以将宝贵的脑力资源集中于解决问题本身——即模型的设计、算法的优化和实验的迭代——而不是耗费在处理繁琐的语法细节、指针管理或内存分配上。在需要快速迭代和实验的深度学习研究中,这种“所思即所得”的表达能力至关重要。

快速原型验证: 从一个算法构思到可运行的原型代码,Python的开发周期极短。这使得研究者和工程师能够迅速检验新想法的有效性,大大加速了整个领域的创新步伐。

1.3.2 “胶水特性”与“巨人肩膀”的外在生态

如果说简洁的哲学是Python的灵魂,那么其强大的科学计算生态就是它坚实的躯体。Python本身并非以极致的运行速度见长,但它拥有强大的“胶水特性”,能够高效地粘合由C、C++或Fortran等高性能语言编写的底层计算库。这让Python得以“站在巨人的肩膀上”,兼具开发效率与运行性能。

科学计算的“三驾马车”:

- NumPy: 提供了高性能的多维数组对象ndarray和丰富的数学函数,是几乎所有数据科学工具的底层依赖,为Python注入了强大的数值计算能力。

- Pandas: 提供了DataFrame这一灵活、强大的数据结构,让结构化数据的清洗、处理、分析变得异常轻松。

- Matplotlib/Seaborn: 提供了从基础到高级的数据可视化能力,是探索数据、呈现结果不可或缺的工具。

深度学习框架的“一致选择”: 当今深度学习领域的两大巨头——Google支持的TensorFlow和Facebook(Meta)支持的PyTorch——都将Python作为其最主要、最优先支持的前端开发接口。它们通过Python封装了底层的CUDA核心,让开发者可以用简洁的Python代码,驱动GPU进行大规模并行计算。这种业界巨头的一致选择,反过来也极大地巩固了Python在深度学习领域的统治地位。

1.3.3 “共建共享”的社区文化

技术的发展,归根结底是人的发展。Python拥有一个全球范围内规模最大、最活跃、最具协作精神的开源社区。这种社区文化是Python生态能够持续繁荣的活水源头。

- 知识的民主化: 无论是初学者遇到的一个简单报错,还是前沿研究所需的复杂算法实现,在Python社区中(如Stack Overflow、GitHub、各类论坛),几乎总能找到答案、教程或现成的开源代码。这极大地降低了学习和进入该领域的门槛。

- 创新的加速器: 一篇重要的深度学习论文发表后,往往在几天甚至几小时内,社区中就会出现其PyTorch或TensorFlow的开源复现代码。这种“思想-代码-应用”的快速转化链条,得益于开源社区的“共建共享”文化,它以前所未有的速度推动着整个领域的边界向前拓展。

- 人才的蓄水池: 庞大的社区也意味着庞大的人才库。对于企业而言,选择Python技术栈意味着更容易招聘到合适的开发人才;对于个人而言,掌握Python则意味着拥有了通往数据科学和人工智能领域最重要的一张“通行证”。

综上所述,选择Python作为学习深度学习的语言,并非仅仅是选择一个工具,更是选择融入一个高效的开发范式、一个成熟强大的技术生态,以及一个充满活力与智慧的全球性社区。它将是您在这趟探索之旅中最值得信赖的伙伴。

1.4 本书的结构与学习路径图:如何高效地利用这本书

为了引导您系统地、由浅入深地掌握深度学习,本书精心设计了五个循序渐进的篇章,它们共同构成了一张从“知”到“行”再到“思”的完整智慧地图。

1.4.1 全书五大篇章概览

1.基础篇(奠定智慧的基石): 本篇章将为您打下坚实的理论与实践基础。您将厘清人工智能、机器学习与深度学习的内在逻辑,回顾其波澜壮阔的发展历程,并掌握深度学习所必需的数学语言和Python编程工具。同时,通过对传统机器学习的温故知新,您将更好地理解深度学习的突破与创新。

2.核心篇(深入神经网络的殿堂): 在本篇章中,您将正式踏入神经网络的核心领域。从最基本的神经元到多层感知机,从反向传播算法到主流深度学习框架(TensorFlow/PyTorch)的实战运用,您将系统学习神经网络的构建、训练与优化技巧,掌握深度学习的“炼丹术”。

3.进阶篇(掌握核心网络架构): 本篇章将带您深入探索深度学习领域最重要、最具影响力的几类网络架构。您将学习用于图像处理的卷积神经网络(CNN)、用于序列数据分析的循环神经网络(RNN),以及在自然语言处理领域掀起革命的Transformer架构。此外,还将介绍生成式模型,开启您的创造之旅。

4.实战篇(从理论到价值的转化): 理论的价值在于指导实践,而实践的意义在于创造价值。本篇章将带您走出象牙塔,用所学知识解决真实世界的问题。通过多个完整的项目实战,涵盖计算机视觉、自然语言处理等热门领域,您将体验从数据处理、模型训练、评估到最终部署的完整流程,具备将AI技术产业化的能力。

5.展望篇(探索未来的边界): 技术的发展永无止境,智慧的探索也永不停歇。本篇章将带您站在时代的前沿,眺望深度学习的未来发展方向。您将了解图神经网络、联邦学习、可解释AI、多模态学习等前沿技术,并深入探讨AI伦理与社会责任等重要议题,成为一个有远见、有责任感的AI从业者。

1.4.2 建议的学习路径

学习深度学习,如同攀登一座高峰,需要循序渐进,步步为营。我们为您提供以下两种建议的学习路径:

- 对于初学者(零基础或基础薄弱): 强烈建议您按部就班地阅读本书。请务必投入足够的时间和精力,认真消化基础篇的内容,尤其是数学与编程基础。在学习过程中,请务必亲手敲入并运行书中的每一个代码示例,完成每一个练习。不要急于求成,打牢基础是您未来能够走得更远、攀得更高的关键。

- 对于有经验者(有一定编程或机器学习基础): 如果您已经具备一定的Python编程经验或机器学习基础知识,可以将基础篇作为快速回顾和查漏补缺的工具。您可以重点投入到核心篇和进阶篇的学习中,深入理解各种模型架构和训练技巧。同时,请直接挑战实战篇的项目,通过实际操作来检验和提升自己的能力,并将本书作为一本实用的参考手册。

无论您选择哪种路径,请记住:实践是检验真理的唯一标准。 理论知识的掌握固然重要,但只有通过大量的动手实践,才能真正将知识内化为您的能力。

1.4.3 本书特色:理论、代码与心法的结合

为了确保您能够高效、深入地学习,本书在内容编排和呈现方式上,力求做到以下几点:

- 理论深度与实践广度并重: 我们不仅会深入剖析算法的数学原理和设计思想,更会提供丰富的代码示例和实战项目,确保您既能“知其然”,更能“知其所以然”,并最终“行其道”。

- 图文并茂,深入浅出: 复杂的概念和抽象的原理,我们将通过大量精心设计的图表、流程图和可视化案例来辅助解释,力求化繁为简,让晦涩难懂的知识变得直观易懂。

- 代码即修行,注重实操: 书中所有代码均提供完整注释,并鼓励您亲手敲入、运行、修改和实验。我们相信,只有经您之手的代码,才能真正内化为您的能力。所有代码都将是可运行、可复现的,并与真实项目接轨。

- “智慧锦囊”,点拨迷津: 在关键章节或易错点处,我们会以“智慧锦囊”的形式,分享一些书本之外的实践经验、常见误区、调试技巧和思维洞见,希望能助您在探索之路上少走弯路,直抵核心。

1.5 心法总纲:保持好奇、勤于实践、拥抱开源

在结束本章之前,请允许我分享三条贯穿整个学习旅程的“心法总纲”。它们比任何具体的知识点都更为重要,是您在深度学习乃至任何复杂领域取得成功的基石。

1.5.1 好奇心是第一驱动力

请永远保持一颗孩童般的好奇心。当您面对一个新的算法、一个复杂的模型时,不要仅仅满足于知道它“如何工作”,更要追问“为什么这样设计?”、“它解决了什么问题?”、“有没有其他可能性?”。这种对原理的不断追问,是您从知识的消费者蜕变为创造者的不二法门。好奇心将驱动您不断探索,发现知识的边界,并最终超越它。

1.5.2 实践是检验真理的唯一标准

计算机科学领域流传着一句名言:“Talk is cheap, show me the code.”(空谈无益,代码为证)。深度学习是一门高度实践性的学科。学习游泳最好的方式就是跳下水。请不要只停留在阅读和思考,一定要动手编程、复现论文中的模型、参加Kaggle等数据科学竞赛、用学到的知识去解决一个您自己感兴趣的真实问题。在实践中遇到的问题和获得的成功,将是您最宝贵的财富,也是您能力提升最快的途径。

1.5.3 拥抱开源,站在巨人的肩膀上

现代科技的飞速发展,离不开开源精神。请积极地学习、使用和贡献于开源社区。去GitHub上阅读优秀项目的源码,学习他人的代码风格和架构思想;当您从社区获益后,也请尝试通过提交问题、改进文档甚至贡献代码的方式回馈社区。这种开放、协作的文化,极大地缩短了前沿算法从论文到工业应用的周期,推动了整个领域的快速发展。融入开源,您将不再是孤军奋战,而是与全球顶尖的开发者共同成长。

第二章:数学与编程基础 —— 内功心法

- 2.1 线性代数:向量、矩阵、张量及其运算(不仅是计算,更是空间的变换)。

- 2.2 微积分:导数、偏导数、链式法则与梯度(理解变化与优化的语言)。

- 2.3 概率论与信息论:概率分布、期望、熵与交叉熵(衡量不确定性与信息)。

- 2.4 NumPy:精通多维数组操作,为数据处理提速。

- 2.5 Pandas:结构化数据的探查、清洗与预处理。

- 2.6 Matplotlib & Seaborn:数据的可视化,让洞察直观呈现。

格物致知 —— 深度学习背后的数学与代码之道

欢迎来到本书最具奠基意义的章节。在读者们即将启程,探索深度学习这个由算法、模型与数据构成的奇妙新世界之前,我们必须首先修炼一套“内功心法”。这套心法,由两部分组成:一部分是洞察万物规律的数学之道,另一部分则是将思想化为现实的编程之术。

或许,部分读者会对标题中的“数学”二字心生畏惧,联想到枯燥的公式推导与繁复的计算。请放心,这恰恰是本章致力于破除的迷思。我们不会将重点放在“如何计算”上,而是聚焦于“为何如此”——我们将一同建立起对关键数学概念直观的几何想象,理解其在现实世界中的物理意义,甚至品味其背后蕴含的哲学思辨。您会发现,线性代数是描述结构与变换的语言,微积分是谱写变化与优化的乐章,而概率论则是衡量不确定性的标尺。它们是理解算法本质的“世界观”。

与此相辅相成的,是编程的“方法论”。如果说数学思想是设计师的蓝图,那么Python及其强大的科学计算库,就是我们手中巧夺天工的工具。本章将引导读者精通NumPy、Pandas、Matplotlib这三柄“神兵利器”,它们是数据处理、分析与可视化的基石,是驱动深度学习这驾豪华马车的双轮中,坚实有力的那一环。

本章的修行路径清晰而坚定:先通“理”,再利“器”。我们将首先漫步于数学的殿堂,而后在编程的工坊里挥洒实践。唯有内外兼修,理术合一,方能在后续的深度学习实战中,做到知其然,更知其所以然,从而游刃有余,直抵精通。

现在,请抛开疑虑,保持一颗好奇与开放的心,与我们一同开始这场“格物致知”的旅程。

2.1 线性代数:描绘世界的结构与变换

线性代数,是现代数学的支柱之一,更是深度学习不可或缺的语言。它为我们提供了一套强大的工具和视角,来理解和操作高维数据。本质上,线性代数研究的是向量、向量空间以及线性变换。在本节中,我们将摒弃繁杂的证明,专注于建立这些概念的直观理解,看它们如何描绘出世界的结构,并执行优雅的变换。

2.1.1 向量(Vector):定义空间中的“存在”

向量的几何与物理意义

-

何为向量 在最浅的层面,一个向量可以看作是列表中的一串数字,例如

v = [3, 4]。然而,它的内涵远比这丰富。在深度学习的语境中,一个向量是对现实世界某个对象关键特征的数字化抽象。更重要的是,它在几何上代表了多维空间中的一个点,或一个从原点出发、带有方向和长度的箭头。一个直观的例子: 假设我们想描述一个人的健康状况,我们选择了两个特征:身高(厘米)和体重(公斤)。如果某人的身高是175cm,体重是70kg,我们就可以用一个二维向量

p = [175, 70]来表示他。这个向量,就是“健康特征空间”这个二维平面上的一个确定的点。从文本、图像到声音,深度学习的第一步,往往就是将这些复杂的、非结构化的信息,转化为一个个高维空间中的向量(这个过程称为“嵌入”或“特征提取”)。因此,理解向量,就是理解深度学习如何“看待”世界万物。

-

向量的模与方向 每一个向量都包含两个核心信息:

- 模(Magnitude/Norm):代表向量的“长度”。在几何上,它是从原点到向量所指向的点的距离。在物理上,它通常代表了特征的强度或事物的大小。例如,在推荐系统中,一个用户向量的模可能代表其兴趣的广泛程度。向量

v = [3, 4]的模(L2范数)为√(3² + 4²) = 5。 - 方向(Direction):代表向量在空间中所指的朝向。它通常代表了特征的性质或事物的类别归属。两个方向相近的向量,通常意味着它们所代表的对象在本质上是相似的。

- 模(Magnitude/Norm):代表向量的“长度”。在几何上,它是从原点到向量所指向的点的距离。在物理上,它通常代表了特征的强度或事物的大小。例如,在推荐系统中,一个用户向量的模可能代表其兴趣的广泛程度。向量

向量的运算与应用

-

点积(Dot Product) 向量点积是线性代数中一个极其有用的运算。对于两个向量

a = [a₁, a₂]和b = [b₁, b₂],它们的点积是a · b = a₁b₁ + a₂b₂。这个简单的计算背后,蕴含着深刻的几何意义:a · b = |a| * |b| * cos(θ)其中|a|和|b|是两个向量的模,θ是它们的夹角。这个公式告诉我们,点积的结果融合了两个向量的长度和它们方向上的一致性。 -

实战应用:余弦相似度 在很多应用中,我们只关心两个向量的方向是否一致,而不想受到它们长度的影响。例如,在判断两篇文章的主题是否相似时,一篇长文章和一篇短文章只要主题相同,它们的向量方向就应该接近,我们不希望因为文章长度(向量的模)不同而影响判断。

为此,我们从点积公式中推导出余弦相似度(Cosine Similarity):

Similarity = cos(θ) = (a · b) / (|a| * |b|)余弦相似度的值域在[-1, 1]之间:这个简单的指标,是现代推荐系统、搜索引擎和自然语言处理中衡量“相似性”的基石。

- 当值为

1时,表示两个向量方向完全相同,代表的对象最相似。 - 当值为

0时,表示两个向量方向正交(垂直),代表的对象不相关。 - 当值为

-1时,表示两个向量方向完全相反。

- 当值为

2.1.2 矩阵(Matrix):组织“关系”与执行“变换”

如果说向量是单个“存在”,那么矩阵就是这些“存在”的有序集合,是描绘群体关系与执行系统性变化的宏大画卷。

矩阵的本质

- 何为矩阵 一个矩阵,就是一个二维的数字阵列。它可以被看作是一组行向量或一组列向量的有序集合。矩阵是二维关系的天然载体。

- 一张灰度图片,其每个像素的灰度值可以构成一个矩阵。

- 一个包含多个学生、多门课程成绩的数据集,本身就是一个“学生-课程”矩阵。

- 在深度学习中,一个神经网络层的权重,通常就存储在一个矩阵中。

矩阵乘法的核心——空间变换

-

矩阵与向量相乘 这是线性代数中最核心、最神奇的操作。当一个矩阵

M与一个向量v相乘得到一个新的向量v'时(v' = Mv),这绝不仅仅是一次算术计算。从几何的角度看,这是一次由矩阵M所定义的对整个空间的线性变换。一个生动的想象: 想象一张画着许多点的、无限大的橡胶膜(代表我们的二维空间)。一个

2x2的矩阵,就是一套对这张膜进行操作的指令集。当这个矩阵作用于空间中的每一个点(向量)时,整张橡胶膜可能会被旋转一个角度,或者在某个方向上被拉伸/压缩(缩放),也可能被扭曲(剪切)。原始空间中所有平行且等距的网格线,在变换后依然保持平行且等距,这就是“线性”变换的含义。

实战哲思:神经网络的“魔法” 现在,我们可以揭示神经网络“魔法”的第一层奥秘了。一个神经网络由许多层堆叠而成,而每一层的核心计算,本质上就是一次由该层的权重矩阵(W)所主导的空间变换,再叠加上一个偏置向量(b)的平移,最后通过一个非线性激活函数(下一章详述)进行“弯曲”。

output = activation(W * input + b)

网络的“学习”或“训练”过程,正是在不断地、精巧地调整这些权重矩阵 W,试图找到一系列最佳的空间变换组合。其最终目的,是希望将原始特征空间中那些混杂在一起、难以区分的数据点(例如,代表“猫”的图片向量和代表“狗”的图片向量),通过层层变换,扭转到一个新的、高维的空间中去。在这个新的空间里,原本纠缠的数据被“解开”,不同类别的数据被清晰地推向了不同的区域,从而可以被一个简单的平面轻易地分开。

因此,理解了矩阵是空间变换的执行者,也就理解了神经网络进行特征学习与分类的核心机制。

2.1.3 张量(Tensor):高维数据的标准“容器”

在掌握了向量和矩阵之后,我们自然地迈向一个更广义、更强大的概念——张量。

从向量、矩阵到张量

- 维度的扩展 张量是多维数组的统称,是向量和矩阵在更高维度上的推广。我们可以这样理解它们的关系:

- 0阶张量:一个标量(Scalar),即一个单独的数字(如

5)。它没有方向,只有一个大小。 - 1阶张量:一个向量(Vector),即一维数组(如

[1, 2, 3])。 - 2阶张量:一个矩阵(Matrix),即二维数组(如

[[1, 2], [3, 4]])。 - 3阶及以上张量:我们通常直接称之为张量(Tensor)。

- 0阶张量:一个标量(Scalar),即一个单独的数字(如

张量在深度学习中的角色

张量,正是承载这些复杂高维数据的标准数据结构。所有主流的深度学习框架,如TensorFlow和PyTorch,其核心数据单元都是张量。因此,熟练地理解和操作张量,是进行深度学习编程的必备技能。

为何需要张量 因为深度学习所处理的现实世界数据,其结构天然就是高维的。

- 一张彩色图片:它有高度、宽度和颜色通道(如RGB三通道)三个维度,因此它是一个3阶张量,形状(Shape)可以表示为

(高度, 宽度, 3)。 - 一段视频:它是由连续的图片帧组成的,所以在图片的基础上增加了一个时间(或帧数)的维度,构成一个4阶张量,形状为

(帧数, 高度, 宽度, 3)。 - 一个批次(Batch)的数据:在训练神经网络时,我们通常不会一次只处理一张图片,而是将多张图片组成一个“批次”来并行处理,以提高效率。这就又增加了一个“批量大小”的维度。例如,一个包含64张彩色图片的批次,就是一个4阶张量,形状为

(64, 高度, 宽度, 3)。

至此,我们完成了对线性代数核心概念的直观解读。读者应建立起这样的认知:向量定义了空间中的存在,矩阵执行了对空间的变换,而张量则是容纳这一切高维数据的标准容器。这套语言,为我们后续理解和构建复杂的深度学习模型,打下了坚实的结构性基础。接下来,我们将引入“变化”的维度,探索微积分的奥秘。

2.2 微积分:理解变化的语言与优化的艺术

如果说线性代数给了我们描述世界状态的“名词”和“形容词”(向量、矩阵),那么微积分则为我们提供了描述世界运动与变化的“动词”和“副词”。它是关于“变化率”的数学,是理解机器学习模型如何“学习”和“优化”的关键所在。

2.2.1 导数与偏导数:捕捉“瞬时变化”的慧眼

导数的本质

-

从斜率到变化率 读者可能还记得,导数在几何上被定义为函数曲线上某一点的切线斜率。但这只是其表象,导数更深刻的本质是函数在该点的“瞬时变化率”。它精准地回答了这样一个核心问题:“当函数的输入

x发生一个极其微小的扰动时,其输出y会如何随之响应?”这个“响应”的剧烈程度,就是导数的值。导数为正,表示函数在此处呈上升趋势;导数为负,则呈下降趋势;导数的绝对值越大,表示变化的趋势越“陡峭”。

偏导数的智慧 现实世界的问题,其结果往往由多个因素共同决定。例如,一个商品的销量 S,可能同时受到价格 P、广告投入 A 和季节 T 的影响,即 S = f(P, A, T)。如果我们想知道“在保持广告和季节不变的情况下,价格每上涨一元,销量会如何变化?”,这时就需要偏导数。

偏导数的智慧在于,它允许我们在多变量的复杂系统中,暂时“冻结”其他所有变量,单独考察某一个变量对函数结果的影响力。这是一种强大的“归因”工具,让我们能够逐一分析每个因素的贡献。在数学上,函数 f 对变量 P 的偏导数记作 ∂f/∂P。

2.2.2 链式法则:层层解构“因果链条”

链式法则的核心思想 许多系统中的因果关系是层层嵌套的。比如,施肥量 x 影响土壤肥力 u,土壤肥力 u 又影响作物产量 y。如果我们想知道“施肥量 x 的微小变化,最终会对产量 y 产生多大影响?”,就需要用到链式法则。

链式法则揭示了在一个由 y = f(u) 和 u = g(x) 构成的复合函数 y = f(g(x)) 中,最终结果的变化率是如何由各个环节的变化率相乘传递而来的: dy/dx = dy/du * du/dx 最终影响等于中间环节影响与初始环节影响的乘积。这是一个极其深刻的规律,它让我们能够解构一个复杂的因果链条。

反向传播的灵魂 深度神经网络,就是一个极深、极复杂的复合函数。网络的输入 X 经过第一层变换得到 H₁,H₁ 经过第二层变换得到 H₂,……,最终经过输出层得到预测结果 Ŷ,而预测结果 Ŷ 与真实标签 Y 之间会产生一个误差(或损失)L。

我们训练网络的目标,是调整网络中成千上万的参数(权重 W 和偏置 b),以最小化这个最终的误差 L。但问题是,身处网络深处的某个参数 Wᵢⱼ,它一个小小的变动,是如何通过层层传递,最终影响到 L 的呢?

反向传播(Backpropagation)算法,正是链式法则在神经网络中的一次宏大而辉煌的应用。它从最终的误差 L 出发,“反向”地、逐层地运用链式法则,计算出误差 L 对网络中每一个参数的偏导数(∂L/∂Wᵢⱼ)。这个偏导数,就精确地衡量了该参数对最终误差的“贡献度”,并指明了它应该调整的方向。可以说,没有链式法则,就没有反向传播,也就没有现代深度学习的根基。

2.2.3 梯度:指向“最优”的罗盘

梯度的几何意义

对于一个多变量函数,我们将它对所有自变量的偏导数,打包成一个向量,这个向量就叫做梯度(Gradient)。例如,对于函数 f(x, y),其梯度为 ∇f = [∂f/∂x, ∂f/∂y]。

梯度这个向量,具有一个非凡的几何意义:它指向函数值增长最快的方向。

负梯度:相应地,梯度的反方向(-∇f),就指向了函数值下降最快的方向。

梯度下降的修行

梯度为我们指明了方向,而梯度下降算法,就是沿着这个方向去寻找函数最小值的具体方法。它是深度学习中最核心、最常用的优化算法。我们可以用一个生动的比喻来理解它的修行过程:

黑夜下山的比喻: 想象一位读者深夜被困在一座连绵的山脉中(山脉的表面就是我们想要最小化的损失函数)。目标是尽快走到山脉的最低点(损失函数的最小值)。

由于天黑,无法看清全局地貌。但这位读者可以做一件事:用脚在原地试探一圈,感受哪个方向是下坡最陡峭的。这个“最陡峭的下坡方向”,正是负梯度方向。

于是,他朝着这个方向迈出一步。这一步的“大小”,我们称之为学习率。

如果步子迈得太大(学习率过高),可能会直接跨过谷底,甚至跑到对面的山坡上,导致“振荡”或“发散”。

到达新位置后,他再次重复这个过程:环顾四周,找到当前位置最陡的下坡方向,再迈出一步……周而复始,通过无数次的迭代,他将一步步地逼近山谷的最低点。

神经网络的训练过程,就是一场在亿万维度参数空间中的“梯度下降”之旅。通过不断地计算损失函数关于所有参数的梯度,并沿着负梯度方向去更新这些参数,模型最终能找到一组使损失最小化的最优参数。

如果步子迈得太小(学习率过低),下山的速度会非常缓慢。

2.3 概率论与信息论:衡量不确定性与知识

世界充满了随机与未知。概率论为我们提供了拥抱和描述不确定性的数学语言,而信息论则为我们提供了一把度量“信息”与“知识”的尺子。

2.3.1 概率分布与期望:拥抱不确定性

概率分布(Probability Distribution) 它是一张描绘随机变量所有可能取值及其对应概率的蓝图。例如,一个公平骰子的概率分布是 {1:1/6, 2:1/6, ..., 6:1/6}。在机器学习中,分类模型的输出,往往就是一个概率分布,如 {猫: 0.8, 狗: 0.15, 其他: 0.05}。

期望(Expectation) 它是概率分布的加权平均值,是在不确定性中我们能做出的最“合理”的长期平均猜测。掷骰子的期望点数是3.5。虽然单次掷不出3.5,但大量重复实验的平均结果会趋近于它。

2.3.2 熵:度量“混乱”与“信息”

信息熵(Information Entropy) 信息熵是信息论的奠基概念,用于量化一个系统的不确定性或混乱程度。一个系统越混乱、结果越不可预测,其熵值就越高。

- 一个作弊的、总出“6”的骰子,其结果完全确定,熵为0。

- 一个公平的骰子,其结果最不确定,熵最大。 熵还有另一层深刻含义:它等于彻底搞清楚该系统状态所需要的最少信息量。

2.3.3 交叉熵:衡量“认知”与“真相”的距离

从KL散度到交叉熵 如果我们有两个概率分布,一个代表“真相”的分布 P,另一个代表我们模型的“认知”(预测)的分布 Q,我们如何衡量它们之间的差距?**KL散度(Kullback-Leibler Divergence)**正是为此而生。 在机器学习的分类任务中,我们更常用一个与KL散度紧密相关的量——交叉熵(Cross-Entropy)来作为损失函数。

损失函数的哲学 交叉熵损失函数衡量的是:用我们的“认知”Q 去编码来自“真相”P 的事件,平均需要多少信息量。如果 Q 与 P 完全一致,交叉熵就达到最小值。 因此,模型训练的过程,就是不断调整参数,以最小化预测分布与真实标签分布之间的交叉熵。这在哲学上,可以看作是一个模型不断放下自己的“我执”(错误的认知),努力去趋近“真相”的修行过程。

2.4 NumPy:科学计算的基石与加速器

理论学习完毕,现在我们开始铸造“神兵”。NumPy(Numerical Python)是Python科学计算生态的核心,它为我们提供了高性能的多维数组对象及相关工具。

2.4.1 ndarray:NumPy的灵魂

高性能的多维数组对象 NumPy的核心是ndarray对象。它的高性能源于两个关键设计:

- 内存布局:

ndarray在内存中是一块连续的、未分装的存储区域,所有元素类型相同。这使得它可以利用现代CPU的向量化指令(SIMD),进行并行计算。 - C语言后端:其底层运算由高度优化的C语言代码执行,避免了Python原生解释器的性能开销。

数组的创建与变形

import numpy as np

# 从列表创建

a = np.array([1, 2, 3])

# 创建特定数组

zeros = np.zeros((2, 3)) # 2x3的全0矩阵

ones = np.ones(5) # 长度为5的全1向量

arange = np.arange(0, 10, 2) # [0, 2, 4, 6, 8]

# 改变形状

b = np.arange(6).reshape((2, 3)) # 创建一个1x6向量并重塑为2x3矩阵

# 转置

c = b.T

2.4.2 向量化运算与广播机制

向量化(Vectorization):告别低效循环 向量化是指直接对整个数组或数组间进行运算,而无需编写显式的for循环。

# 非向量化 (慢)

a = list(range(1000000))

b = list(range(1000000))

c = []

for i in range(len(a)):

c.append(a[i] + b[i])

# 向量化 (快)

a_np = np.arange(1000000)

b_np = np.arange(1000000)

c_np = a_np + b_np

在性能上,向量化版本通常比循环版本快几个数量级。

广播(Broadcasting):智能的维度对齐 广播是NumPy最强大的特性之一,它允许不同形状的数组在一定规则下进行算术运算。

规则核心:从两个数组的尾部维度开始逐一比较,如果维度相等,或其中一个为1,则可以广播;否则报错。缺失的维度会被视为1。

matrix = np.array([[1, 2, 3], [4, 5, 6]]) # shape (2, 3)

vector = np.array([10, 20, 30]) # shape (3,)

# 广播机制会自动将vector“扩展”为[[10,20,30], [10,20,30]]

result = matrix + vector

# result is [[11, 22, 33], [14, 25, 36]]

2.5 Pandas:驾驭结构化数据的瑞士军刀

Pandas是建立在NumPy之上的数据分析库,提供了Series和DataFrame两种强大的数据结构,是处理和分析表格类(结构化)数据的首选工具。

2.5.1 Series与DataFrame:带标签的数据容器

Series:一个带标签的一维数组,可以看作是NumPy数组和Python字典的结合体。DataFrame:一个二维的、带标签的表格型数据结构,拥有行索引和列索引。它是Pandas中使用最广泛的核心。

2.5.2 数据的探查、清洗与预处理

import pandas as pd

# 假设我们有一个CSV文件 'titanic.csv'

df = pd.read_csv('titanic.csv')

# 2.5.2.1 数据探查

print(df.head()) # 查看前5行

print(df.info()) # 查看列信息、数据类型、非空值数量

print(df.describe()) # 查看数值列的统计摘要

# 2.5.2.2 数据清洗

# 处理缺失值:将Age列的缺失值用年龄中位数填充

median_age = df['Age'].median()

df['Age'].fillna(median_age, inplace=True)

# 2.5.2.3 数据转换与操作

# 选择与过滤:选择所有年龄大于60岁的乘客

seniors = df.loc[df['Age'] > 60]

# 分组与聚合:按性别计算平均票价

avg_fare_by_sex = df.groupby('Sex')['Fare'].mean()

print(avg_fare_by_sex)

2.6 Matplotlib & Seaborn:让数据开口说话的艺术

数据可视化是理解数据、展示洞见的强大手段。Matplotlib是Python可视化的基础库,而Seaborn则是在其之上构建的、更侧重统计美学的高级库。

2.6.1 Matplotlib:Python可视化的基石

快速绘图:Pyplot接口

import matplotlib.pyplot as plt

x = np.linspace(0, 10, 100)

y = np.sin(x)

plt.plot(x, y, label='sin(x)')

plt.xlabel('x axis')

plt.ylabel('y axis')

plt.title('A Simple Plot')

plt.legend()

plt.show()

精细控制:面向对象接口

fig, ax = plt.subplots() # 创建一个Figure对象和一个Axes对象

ax.plot(x, y, label='sin(x)')

ax.set_xlabel('x axis')

ax.set_ylabel('y axis')

ax.set_title('A Simple Plot (OO Style)')

ax.legend()

plt.show()

面向对象的方式在绘制复杂图表时更具优势。

2.6.2 Seaborn:基于Matplotlib的统计美学

Seaborn的优势 Seaborn的优势在于其美观的默认样式和内置的、面向统计分析的高级绘图函数。

常用高级图表

import seaborn as sns

# 使用pandas加载的titanic数据集 df

# 绘制一个箱形图,观察不同船舱等级乘客的年龄分布

sns.boxplot(x='Pclass', y='Age', data=df)

plt.title('Age Distribution by Passenger Class')

plt.show()

# 绘制一个热力图,可视化数值特征间的相关性

numeric_cols = df.select_dtypes(include=np.number)

correlation_matrix = numeric_cols.corr()

sns.heatmap(correlation_matrix, annot=True, cmap='coolwarm')

plt.title('Correlation Matrix of Numeric Features')

plt.show()

小结

至此,我们完成了第二章“内功心法”的全部修行。从线性代数的空间变换,到微积分的优化艺术,再到概率论的量化不确定性,我们为理解深度学习算法铺设了坚实的理论基石。紧接着,我们亲手掌握了NumPy、Pandas、Matplotlib/Seaborn这三大编程利器,它们是将理论付诸实践、与数据对话的强大工具。

读者现在应深刻理解,数学并非算法的障碍,而是洞察其本质的钥匙;代码亦非冰冷的指令,而是实现创想的画笔。当“理”与“器”在您手中融会贯通,深度学习的大门已然为您敞开。带着这份内功,我们将在后续的章节中,充满信心地构建、训练并剖析各种复杂的神经网络模型。

第三章:机器学习经典回顾 —— 温故而知新

- 3.1 机器学习的三大范式:问道于天地。

- 3.2 经典模型剖析:一花一世界,一叶一菩提。

- 3.3 模型的评估与优化:知其然,更要知其所以然。

为何要回顾经典?

亲爱的读者朋友,在您即将踏入深度学习那片广袤而深邃的森林之前,我们要先带您走过一片风景秀丽、基石坚固的丘陵。这片丘陵,便是由那些经典的机器学习算法构成的。或许您会问,我们不是要学最前沿的深度学习吗?为何要在此“逗留”?

答案很简单:思想,总有其传承。

您可知道,深度学习的基石——神经网络中的单个神经元,其思想源头便是本章将要介绍的线性模型吗?您可知道,那些动辄拥有亿万参数的庞大网络模型,其背后蕴含的“群体智慧”,早已在“随机森林”这样的集成方法中初现端倪?经典模型,正是深度学习的“思想源头”和“活水”。不溯其源,则难以知其流。

其次,我们要有性价比的智慧。深度学习固然强大,但它也像一柄需要巨大能量催动的“屠龙刀”。在许多现实场景中,问题可能只是一只“鸡”,用一把精致的“水果刀”——比如逻辑回归或决策树——便能以极低的计算成本、极快的时间和完美的解释性来解决。学会“杀鸡用牛刀”之前,必先要懂得何时该用、如何用好那把“水果刀”。这是一种工程师的务实,也是一种实践家的智慧。

最后,也是最重要的,学习这些相对简单的模型,是为了帮助您建立一种宝贵的“算法直觉”。通过亲手实现一个线性回归,您会直观地感受到什么是“拟合”;通过调试一棵决策树,您会深刻地理解什么是“过拟合”;通过比较不同的评估指标,您会明白“泛化能力”的真正含义。这些核心概念,在经典模型上显得清晰而具体。有了这份直觉,当您未来面对深度学习这个复杂的“黑箱”时,才能不畏惧、不迷茫,拥有洞察其本质的眼光。

所以,请先静下心来。让我们一起,站上这些巨人的肩膀,不是为了停留,而是为了看得更远、更清。这趟“温故知新”的旅程,将为您未来的深度学习之路,打下最坚实的思想地基。

3.1 机器学习的三大范式:问道于天地

在正式接触具体的算法之前,读者需要先建立一个宏观的认知框架。机器学习根据其学习方式和数据特点,主要可以分为三大范式:监督学习、无监督学习和强化学习。这三种范式,可以看作是机器向世界“问道”的三种不同途径,每一种都对应着一类独特的现实问题。

3.1.1 监督学习:有师之学,依标而行

核心思想 监督学习是目前应用最广泛、最成熟的机器学习范式。它的核心思想,是从带有明确“标签”(Label)或“答案”(Answer)的数据中进行学习。这里的“标签”就是我们预先知道的、正确的输出。整个学习过程,就如同有一位无所不知的老师(即标签数据)在旁边进行指导,每当模型做出一次预测,老师就会告诉它正确答案是什么,模型则根据这次反馈来修正自己,力求下次做得更好。

因此,“监督”二字的精髓在于,学习的每一步都有来自“正确答案”的直接反馈。

两大任务 根据标签类型的不同,监督学习主要解决两类问题:

回归(Regression):当我们的目标是预测一个连续的数值时,这类问题就被称为回归。预测值的范围是连续的,可以取任意实数。

- 譬如:根据房屋的面积、位置、房龄等特征,预测其市场价格(一个连续的金额);根据历史气象数据,预测明天最高气温(一个连续的温度值)。

分类(Classification):当我们的目标是预测一个离散的类别时,这类问题就是分类。预测的结果是有限个类别中的一个。

- 譬如:根据邮件的内容和发件人信息,判断该邮件是**“垃圾邮件”还是“非垃圾邮件”(二分类问题);根据一张动物图片,识别出它是“猫”、“狗”还是“鸟”**(多分类问题)。

学习的本质 从数学的角度看,监督学习的本质,就是寻找一个最优的映射函数 f。这个函数能够建立起从输入特征 X 到输出标签 Y 之间的稳定关系,即 Y ≈ f(X)。模型的训练过程,就是通过海量的已知 (X, Y) 数据对,来不断调整函数 f 的内部参数,使其尽可能地逼近这个真实存在的、但我们未知的潜在映射规律。

3.1.2 无监督学习:无师之学,观物自省

核心思想 与监督学习截然相反,无监督学习所面对的数据是**完全没有“标签”**的。这意味着没有现成的“正确答案”可供参考。学习的目标,是在没有外部指导的情况下,仅仅依靠数据自身,去发现其中隐藏的结构、模式或内在规律。

这个过程,好比一位古代的天文学家,他所拥有的只是满天繁星的位置数据(没有标签的输入 X),通过日复一日的观察与思考,他自己发现了某些星星组合起来,形态上很相似,于是将它们命名为“猎户座”、“北斗七星”等(即聚类)。他是在数据中自我发现了规律。

典型任务 无监督学习的应用场景同样广泛,主要包括:

聚类(Clustering):将数据集中的样本,根据它们内在的相似性,自动地划分为若干个簇(Cluster)。目标是让同一簇内的数据点尽可能相似,不同簇之间的数据点尽可能相异。

- 譬如:电商平台根据用户的购买历史、浏览行为等数据,将庞大的客户群体自动划分为**“高价值客户”、“潜力客户”、“待激活客户”**等不同的群体,以便实施精准营销。

降维(Dimensionality Reduction):在尽可能保留原始数据主要信息的前提下,用更少的特征来表示数据。这有助于数据可视化、去除噪声、以及提升后续其他学习算法的效率。

- 譬如:衡量一个地区宏观经济状况的指标可能有上百个(GDP、CPI、PMI、进出口额等),这些指标间可能存在高度相关性。降维技术可以将这上百个指标压缩为几个核心的“经济景气指数”,抓住主要矛盾。

学习的本质 无监督学习的本质,不是去拟合一个输入到输出的映射,而是深入探索数据 X 自身内在的分布、关联与结构。它试图回答的问题是:“这堆数据本身,可以被如何组织和理解?”

3.1.3 强化学习:行万里路,动中觉悟

核心思想 强化学习是三大范式中最具“行动智慧”的一种。它关注的是一个智能体(Agent)如何在一个复杂的、动态的环境(Environment)中,通过与环境的互动来学习如何做出最优决策,以达成一个长远的目标。

它的学习方式既非依赖标签,也非纯粹观察,而是**“试错”(Trial and Error)。智能体做出一个动作(Action),环境会因此发生改变并反馈给智能体一个奖励(Reward)或惩罚(Punishment)信号。智能体的目标,就是学习一个最优的策略(Policy)——即在何种状态(State)下应该采取何种动作——来最大化它在未来能够获得的累积奖励**。

核心要素 一个强化学习问题,通常由以下几个核心要素构成:

- 智能体(Agent):学习者和决策者。

- 环境(Environment):智能体外部的世界,与智能体进行交互。

- 状态(State):对当前环境的一个描述。

- 动作(Action):智能体可以采取的行为。

- 奖励(Reward):环境对智能体上一步动作的即时反馈信号。

学习的隐喻 强化学习的过程,与生物学习新技能的过程极为相似。

譬如,婴儿学走路。婴儿(智能体)在客厅(环境)中,他当前的姿势和位置是(状态)。他尝试迈出一步(动作)。如果成功前进了,父母的鼓励就是(正奖励);如果不幸摔倒了,疼痛感就是(负奖励/惩罚)。通过无数次的尝试,婴儿的大脑逐渐学会了在各种状态下,如何协调肌肉做出正确的动作,以实现“持续行走不摔倒”这个长期目标。

在技术领域,强化学习被广泛应用于训练AI下棋(AlphaGo)、玩电子游戏、控制机器人行走、优化交通信号灯调度等动态决策问题。

好了,读者朋友们,通过以上介绍,相信大家对机器学习的三大范式已经有了一个清晰的认识。它们分别从“有师之学”、“无师之学”和“动中觉悟”三个维度,为机器赋予了学习的能力。接下来,我们将深入到监督学习的阵营中,从最经典、最基础的模型开始,剖析它们的内在机理。

3.2 经典模型剖析:一花一世界,一叶一菩提

本节将要介绍的几个经典模型,各自都代表了一种核心的建模思想。它们就像几扇不同的窗户,让我们从不同的角度窥见机器学习解决问题的智慧。每一个模型,都是一个自成体系的小世界。

3.2.1 线性回归与逻辑回归:从线性到非线性的桥梁

线性模型是机器学习世界中最基础、最重要的模型家族。它们以其简洁、高效和高度的可解释性,成为了许多复杂算法的基石。

线性回归(Linear Regression):大道至简,直来直往

模型哲学 线性回归的背后,是一种朴素而强大的世界观:它相信世间万物的许多联系是简单的、线性的。它试图用一条笔直的线(在一维空间中)或一个平整的面(在多维空间中),来描述输入特征与输出值之间的关系。这种“直来直往”的假设,虽然简单,却惊人地有效,能够抓住许多现实问题的核心趋势。

数学形式 对于一个拥有 n 个特征的样本 x = (x₁, x₂, ..., xₙ),线性回归模型预测其输出 ŷ (读作 y-hat) 的公式为: ŷ = w₁x₁ + w₂x₂ + ... + wₙxₙ + b 这个公式可以用更简洁的向量形式表示:ŷ = wᵀx + b

- 权重(weights)

w:向量w = (w₁, w₂, ..., wₙ)中的每一个元素wᵢ,代表了第i个特征xᵢ对最终预测结果的影响力。wᵢ的绝对值越大,说明该特征越重要。 - 偏置(bias)

b:它是一个截距项,代表了在不考虑任何输入特征的情况下,预测值的基准水平。

损失函数:最小二乘法 模型如何知道哪条直线才是“最佳”的呢?我们需要一个标准来衡量“好”与“坏”。在线性回归中,这个标准就是均方误差(Mean Squared Error, MSE),也称为最小二乘法。 它的思想直观而优美:对于每一个训练样本,模型都有一个预测值 ŷ 和一个真实值 y。它们之间的差距 (y - ŷ) 就是预测误差。我们将所有样本的这个误差进行平方(以消除正负号并放大较大误差的影响),然后求其平均值。 几何意义:最小化均方误差,等价于寻找一条直线,使得所有数据点到这条直线的竖直距离的平方和最小。这条直线,就是对数据拟合得最好的直线。

代码实战 在Python中,Scikit-Learn库为我们实现线性回归提供了极大的便利。下面是一个简单的示例,我们将使用它来预测一个基于“学习小时数”的“考试分数”。

# 导入所需库

import numpy as np

from sklearn.linear_model import LinearRegression

import matplotlib.pyplot as plt

# 1. 准备数据 (X: 学习小时数, y: 考试分数)

X = np.array([[2], [4], [5], [6], [8], [10]])

y = np.array([55, 60, 68, 75, 85, 95])

# 2. 创建并训练模型

model = LinearRegression()

model.fit(X, y)

# 3. 查看模型参数

w = model.coef_[0] # 权重 w

b = model.intercept_ # 偏置 b

print(f"学习到的模型: 分数 = {w:.2f} * 小时数 + {b:.2f}")

# 4. 进行预测并可视化

plt.scatter(X, y, color='blue', label='真实数据') # 绘制原始数据点

plt.plot(X, model.predict(X), color='red', label='回归直线') # 绘制拟合的直线

plt.xlabel('学习小时数')

plt.ylabel('考试分数')

plt.legend()

plt.show()

通过这段代码,读者可以亲眼看到一条红色的直线,它以“最小二乘”的准则,优雅地穿过了蓝色的数据点,揭示了学习时间与分数之间的线性关系。

逻辑回归(Logistic Regression):在边界处优雅转身

为何需要 如果我们想预测的不是连续的分数,而是“及格”与“不及格”这两个类别呢?线性回归的输出是 (-∞, +∞) 的连续值,无法直接用于分类。我们需要一个模型,它能输出一个表示“概率”的值。逻辑回归应运而生,它虽然名字里有“回归”,但其本质是一个经典的二分类算法。

核心机关:Sigmoid函数 逻辑回归的巧妙之处,在于它在线性回归的基础上,套上了一个“马甲”——Sigmoid函数(也称Logistic函数)。 Sigmoid函数的数学形式为:σ(z) = 1 / (1 + e⁻ᶻ) 它的神奇之处在于,无论输入 z 是多大或多小的实数,它的输出值 σ(z) 永远被压缩在 (0, 1) 这个区间内。这正好符合概率的定义! 逻辑回归的做法是:

- 先像线性回归一样,计算一个线性输出

z = wᵀx + b。 - 然后,将这个

z值送入Sigmoid函数,得到p = σ(z)。 这个输出p就可以被解释为样本属于“正类”(通常用1表示)的概率。如果p > 0.5,我们就预测为正类;反之,则预测为负类。

决策边界(Decision Boundary) p = 0.5 是分类的临界点,它发生在 z = 0 的时候。也就是说,wᵀx + b = 0 这条线(或高维平面)成为了两个类别的分界线,我们称之为决策边界。在决策边界一侧的点被划分为一类,另一侧的点被划分为另一类。逻辑回归的“学习”,就是在寻找这条最佳的决策边界。

代码实战 我们使用Scikit-Learn来完成一个简单的二分类任务,比如根据肿瘤大小预测其为良性还是恶性。

# 导入所需库

from sklearn.linear_model import LogisticRegression

from sklearn.datasets import make_classification

# 1. 生成模拟分类数据

X, y = make_classification(n_samples=100, n_features=1, n_informative=1,

n_redundant=0, n_clusters_per_class=1, random_state=42)

# 2. 创建并训练模型

model = LogisticRegression()

model.fit(X, y)

# 3. 可视化决策边界 (此处仅为示意,真实可视化较复杂)

# 决策边界在 z=0 处,即 w*x + b = 0, x = -b/w

boundary_x = -model.intercept_ / model.coef_[0]

print(f"决策边界位于 x = {boundary_x[0]:.2f}")

# 绘制数据点

plt.scatter(X, y, c=y, cmap='bwr', edgecolor='k')

# 绘制决策边界

plt.axvline(x=boundary_x, color='green', linestyle='--', label='决策边界')

plt.xlabel('肿瘤大小')

plt.ylabel('类别 (0: 良性, 1: 恶性)')

plt.legend()

plt.show()

这段代码展示了逻辑回归如何找到一个分界点(绿色的虚线),将代表良性与恶性的两类数据点清晰地分开。

3.2.2 决策树与随机森林:集成思想的初步体现

如果说线性模型是用一个全局的、统一的函数来划分世界,那么决策树则是一种完全不同的、分而治之的哲学。

决策树:格物致知的典范

模型哲学 决策树的思考方式,与人类的决策过程如出一辙。它通过提出一系列“是/否”的问题,对数据进行层层划分,最终导向一个结论。

例如,判断一个瓜是不是好瓜,我们可能会问:“它的颜色是青绿吗?” -> “是的。” -> “它的根蒂是蜷缩的吗?” -> “是的。” -> “它的敲声是沉闷的吗?” -> “不是。” -> “结论:这是个坏瓜。” 这个过程,就是一棵决策树。

它的最大优点是模型具有极强的可解释性,我们可以清晰地看到每一个决策的依据。

构建过程:如何选择最佳问题 决策树构建的关键,是在每一步,如何选择一个“最佳”的问题(即特征)来划分当前的数据集,使得划分后的数据“纯度”最高。这里的“纯度”指的是数据的类别一致性。 我们使用**信息增益(Information Gain)或基尼不纯度(Gini Impurity)**来衡量一个问题的好坏。一个好的问题,应该能让划分后的子集,其不确定性(信息熵)或不纯度(基尼指数)大幅下降。决策树会贪心地选择那个能带来最大信息增益的特征进行分裂。

剪枝(Pruning) 如果任由决策树生长,它会为每一个训练样本都找到一条完美的路径,最终导致树变得异常“茂盛”和复杂。这样的树对训练数据拟合得很好,但对新数据的泛化能力会很差,这就是过拟合。 为了防止这种情况,我们需要对树进行剪枝。可以在树生长时就限制其深度或叶子节点数量(预剪枝),也可以等树完全长成后再砍掉一些不必要的枝叶(后剪枝)。

代码实战 使用Scikit-Learn构建决策树,并利用graphviz工具将其决策过程可视化。

from sklearn.tree import DecisionTreeClassifier, export_graphviz

from sklearn.datasets import load_iris

import graphviz

# 1. 加载鸢尾花数据集

iris = load_iris()

X, y = iris.data, iris.target

# 2. 创建并训练决策树模型

model = DecisionTreeClassifier(max_depth=3) # 限制最大深度以防过拟合

model.fit(X, y)

# 3. 将决策树可视化

dot_data = export_graphviz(model, out_file=None,

feature_names=iris.feature_names,

class_names=iris.target_names,

filled=True, rounded=True,

special_characters=True)

graph = graphviz.Source(dot_data)

# graph.render("iris_decision_tree") # 可以保存为文件

# 在Jupyter Notebook中,可以直接显示graph对象

# graph

运行上述代码(需安装graphviz库),读者将能得到一张清晰的决策树图,直观地看到模型是如何根据花瓣、花萼的长宽来判断鸢尾花品种的。

随机森林(Random Forest):三个臭皮匠,赛过诸葛亮

集成学习(Ensemble Learning)思想 单棵决策树,尤其是深度较大的决策树,容易过拟合,对数据的微小扰动很敏感。一个自然的想法是:我们能不能综合多棵不同决策树的意见来做决定?这就是集成学习的核心思想,俗称“群体智慧”。随机森林正是这种思想最杰出的代表。

“随机”体现在何处 为了让森林中的每一棵树都有所不同,从而形成互补,随机森林引入了两个“随机”机制:

- 数据随机(行抽样):森林中的每一棵树,都不是用全部的训练数据来训练的。而是通过自助采样法(Bootstrap Aggregating,简称Bagging),从原始数据集中有放回地抽取一个与原始数据集同样大小的子集。这样,每棵树看到的“世界”(训练数据)都是不完全一样的。

- 特征随机(列抽样):在构建每一棵树的每一个节点时,不再是从全部特征中选择最优分裂特征,而是随机抽取一部分特征,再从这部分特征中选择最优的。这进一步增加了树之间的差异性。

为何有效 这两个“随机”机制,极大地保证了森林中树的多样性(Diversity)。有些树可能在这个问题上犯错,但另一些树可能恰好是正确的。当森林进行预测时,它会采用“投票”的方式(分类问题)或“取平均”的方式(回归问题),综合所有树的意见。这种机制可以有效地降低整体模型的方差,使得随机森林具有非常好的抗过拟合能力和稳定性。

代码实战 我们使用Scikit-Learn的RandomForestClassifier,在同样的数据上比较它与单棵决策树的性能。

from sklearn.ensemble import RandomForestClassifier

from sklearn.model_selection import cross_val_score

# 仍然使用鸢尾花数据集

X, y = iris.data, iris.target

# 创建单棵决策树模型

tree_clf = DecisionTreeClassifier(random_state=42)

# 创建随机森林模型

forest_clf = RandomForestClassifier(n_estimators=100, random_state=42) # n_estimators是树的数量

# 使用交叉验证比较性能

tree_scores = cross_val_score(tree_clf, X, y, cv=5)

forest_scores = cross_val_score(forest_clf, X, y, cv=5)

print(f"单棵决策树的平均准确率: {tree_scores.mean():.4f}")

print(f"随机森林的平均准确率: {forest_scores.mean():.4f}")

通常情况下,读者会观察到随机森林的平均准确率会更稳定,也可能更高。

3.2.3 支持向量机(SVM):最大化间隔的艺术

支持向量机是一个功能强大且理论优美的分类算法。它的核心思想,不是简单地将数据分开,而是要以最“稳健”的方式分开。

核心思想:寻找最“宽”的街道

-

模型哲学 想象一下,在两种不同颜色的数据点之间,可以画出无数条线将它们分开。SVM认为,最好的那条分界线,应该是这样一条线:它位于两类数据点的正中间,并且离两边最近的数据点(我们称之为支持向量)的距离是最远的。 这条分界线就像一条街道,而街道两侧到最近的建筑(支持向量)之间的距离,就是街道的宽度,这个宽度在SVM中被称为间隔(Margin)。SVM的目标,就是最大化这个间隔。一条更宽的“街道”意味着模型对未知数据的容忍度更高,泛化能力更强。

-

线性SVM 在线性可分的情况下,SVM就是要找到由决策边界(街道中心线)、间隔和支持向量(街道两旁的建筑)构成的这个最优“街道系统”。一个有趣的特点是,最终的决策边界仅仅由这些少数的支持向量决定,与其他数据点无关。

核技巧(The Kernel Trick):乾坤大挪移

-

处理非线性问题 现实世界的数据往往不是线性可分的。比如,一类数据点被另一类数据点包围,无法用一条直线将它们分开。此时,SVM如何应对?

-

升维打击 SVM的精髓——核技巧登场了。它的思想,堪称“乾坤大挪移”。它通过一个称为核函数(Kernel Function)的数学变换,将数据从当前的低维特征空间,巧妙地映射到一个更高维的空间。神奇的是,在低维空间中线性不可分的数据,在映射到高维空间后,往往就变得线性可分了。

一个比喻:想象桌面上有一堆红色和蓝色的珠子混在一起,无法在桌面上画一条直线分开它们。现在您猛地一拍桌子,所有珠子都飞到了空中(升维)。在它们飞到最高点的那一瞬间,您用一个水平面(高维空间的“直线”)就能轻易地将红色和蓝色的珠子分开。

-

“核”的巧妙 更令人惊叹的是,SVM的核技巧无需真正地计算数据点在高维空间中的坐标,这在维度极高时(甚至是无限维)是无法做到的。它只需要通过核函数计算出数据点在低维空间中的内积,其结果就等价于它们在高维空间中的内积。这极大地降低了计算的复杂度,使得“升维打击”成为可能。常用的核函数有高斯核(RBF)、多项式核等。

代码实战 我们使用Scikit-Learn的SVC(Support Vector Classifier)来处理一个非线性可分的数据集。

from sklearn.svm import SVC

from sklearn.datasets import make_circles

# 1. 生成一个环形(非线性)数据集

X, y = make_circles(n_samples=100, noise=0.1, factor=0.5, random_state=42)

# 2. 创建并训练一个带RBF核的SVM模型

model = SVC(kernel='rbf', C=1.0, gamma='auto') # rbf是高斯核

model.fit(X, y)

# 3. 可视化决策边界 (此处代码较复杂,仅为示意,需要辅助函数)

# 核心是绘制出 model.predict() 结果的等高线图

# 在图中,读者会看到一条平滑的圆形边界,完美地分开了内外两圈数据点

# 并且可以看到,只有边界附近的点(支持向量)对决策边界有影响

通过这个例子,读者可以直观地感受到核技巧的威力,它如何毫不费力地解决了线性模型无法解决的问题。

3.3 模型的评估与优化:知其然,更要知其所以然

建立模型只是第一步。我们如何知道一个模型是好是坏?又如何诊断它存在的问题并加以改进?本节将介绍一套科学的评估与优化方法论。

3.3.1 模型的评估:明辨是非的标尺

选择合适的评估指标至关重要,它决定了我们优化模型的方向。

分类模型评估指标

-

混淆矩阵(Confusion Matrix) 它是所有分类指标的基石。对于一个二分类问题,混淆矩阵是一个2x2的表格,清晰地展示了模型预测的四种情况:

- 真正例 (TP): 真实为正,预测也为正。

- 假正例 (FP): 真实为负,预测却为正。(误报)

- 真负例 (TN): 真实为负,预测也为负。

- 假负例 (FN): 真实为正,预测却为负。(漏报)

-

准确率(Accuracy)

Accuracy = (TP + TN) / (TP + FP + TN + FN)这是最直观的指标,即“预测正确的样本数 / 总样本数”。但在样本不均衡(例如99%的邮件都是正常邮件)的情况下,它具有极大的误导性。一个无脑预测所有邮件都正常的模型,准确率也能达到99%。 -

精确率(Precision)与召回率(Recall)

- 精确率

Precision = TP / (TP + FP):在所有被模型预测为“正”的样本中,有多少是真正的正样本。它衡量的是模型的**“查准率”**,关心的是“别把坏人当好人”。 - 召回率

Recall = TP / (TP + FN):在所有真实为“正”的样本中,有多少被模型成功地找了出来。它衡量的是模型的**“查全率”**,关心的是“别放过任何一个坏人”。 精确率和召回率往往是一对矛盾的指标。在疾病诊断中,我们更关心高召回率(宁可误诊,不能漏诊);在垃圾邮件过滤中,我们更关心高精确率(宁可放过一些垃圾邮件,不能把重要邮件错判为垃圾)。

- 精确率

-

F1分数(F1-Score)

F1 = 2 * (Precision * Recall) / (Precision + Recall)它是精确率和召回率的调和平均数,是一个兼顾两者的综合性指标。

回归模型评估指标

-

均方误差(MSE)与均方根误差(RMSE)

MSE = (1/n) * Σ(y - ŷ)²RMSE = sqrt(MSE)它们衡量的是预测值与真实值之差的平方的均值。RMSE因为开了根号,其量纲与原始数据相同,更易于解释。它们对较大的误差(异常值)惩罚更重。 -

平均绝对误差(MAE)

MAE = (1/n) * Σ|y - ŷ|它衡量的是预测值与真实值之差的绝对值的均值。它对所有误差一视同仁,对异常值的鲁棒性比MSE/RMSE更好。

3.3.2 偏差与方差:执着于一与游移不定

这是理解模型行为、诊断问题的核心理论。

概念辨析 一个模型的泛化误差,可以分解为偏差、方差和噪声三部分。我们主要关注前两者。

- 偏差(Bias):描述的是模型的预测值的期望与真实值之间的差距。高偏差源于模型本身的“偏见”或“固执”,它无法捕捉到数据的真实规律。高偏差通常表现为欠拟合(Underfitting)。

- 方差(Variance):描述的是模型在不同训练集上进行训练时,其预测结果的波动性或不稳定性。高方差源于模型对训练数据中的噪声和细节过度“敏感”,把偶然当必然。高方差通常表现为过拟合(Overfitting)。

偏差-方差的权衡(Bias-Variance Tradeoff) 这是机器学习中一个永恒的核心矛盾。

- 一个简单的模型(如线性回归),对数据规律的假设很强,偏差较高,但对不同训练数据不敏感,方差较低。

- 一个复杂的模型(如高阶多项式回归或深度决策树),能拟合各种复杂规律,偏差较低,但极易学习到训练数据的噪声,导致在不同数据集上结果差异巨大,方差较高。 我们的目标,不是追求零偏差或零方差,而是在两者之间找到一个最佳的平衡点,使得总的泛化误差最小。

3.3.3 过拟合与欠拟合:学“废”了与没学会

这是偏差与方差在模型训练中的具体表现。

现象与诊断:

欠拟合(Underfitting):模型在训练集和测试集上表现都很差。

- 病因:模型太简单了(高偏差),连训练数据的基本规律都没学会。

- 诊断:观察到训练误差和测试误差都很高。

过拟合(Overfitting):模型在训练集上表现极好,但在未见过的测试集上表现很差。

- 病因:模型太复杂了(高方差),把训练数据中的噪声和偶然性也当成了普适规律来学习,失去了“泛化”到新数据的能力。

- 诊断:观察到训练误差很低,但测试误差远高于训练误差。

“诊断”方法:学习曲线 绘制学习曲线(Learning Curves)是一种有效的诊断方法。该曲线的横轴是训练样本的数量,纵轴是误差(或准确率)。通过观察训练误差曲线和验证误差曲线的走势和差距,可以清晰地判断出模型正处于欠拟合、过拟合还是理想状态。

3.3.4 交叉验证:更公平的“模拟考试”

为何需要 在模型开发中,我们通常会将数据划分为训练集和测试集。但这种一次性的划分具有很大的偶然性。可能我们碰巧分到了一份“简单”的测试集,导致模型得分虚高;也可能碰巧分到了一份“困难”的测试集,导致好模型被冤枉。

K折交叉验证(K-Fold Cross-Validation) 为了得到一个更稳健、更公平的模型评估结果,我们采用交叉验证。K折交叉验证是其中最常用的方法。

这种方法让所有数据都有机会成为验证集,大大降低了单次划分带来的偶然性,得出的评估结果更具说服力。

- 将全部训练数据随机分成 K 个大小相等的、互不相交的子集(称为“折”)。

- 进行 K 轮“模拟考试”:

- 在每一轮中,选择其中 1 个“折”作为验证集(测试模型),其余 K-1 个“折”合并起来作为训练集(训练模型)。

- 最终,我们得到 K 个验证集上的得分,将它们取平均值,作为模型的最终评估分数。

代码实战 Scikit-Learn中的cross_val_score函数让执行交叉验证变得异常简单,我们在之前的随机森林代码实战中已经演示了它的用法。它封装了整个K折划分和循环训练评估的过程,一行代码就能返回K次“模考”的成绩列表。

小结

至此,我们完成了对机器学习经典算法的回顾。从三大范式的高屋建瓴,到线性模型、决策树、随机森林、支持向量机等核心算法的深入剖析,再到一套科学的模型评估与优化方法论,读者应当已经建立起了坚实的机器学习基础。

这些经典模型,不仅是解决现实问题的有力工具,更是通往深度学习殿堂的必经之路。它们所蕴含的关于拟合、泛化、偏差、方差、集成等核心思想,将在后续的章节中反复出现并不断升华。带着这些宝贵的知识和直觉,现在,我们终于准备好,去迎接下一章——真正踏入神经网络的世界。

第二部分:核心篇 —— 深入神经网络的殿堂

第四章:神经网络基础

从仿生学到数学模型 —— 智能的计算之路

欢迎来到深度学习的核心腹地。在前面的章节中,我们回顾了经典的机器学习算法,它们如同能工巧匠,使用着设计精巧的工具。从本章开始,我们将学习如何构建一个能够自我学习、自我演化的“有机体”——神经网络。

这个宏大构想的最初火花,源于人类对自己智慧源泉——大脑——的探寻。科学家们渴望在冰冷的硅基芯片上,模拟出由亿万神经元构成的生物神经网络的惊人能力。这,便是神经网络仿生学的浪漫起点。然而,浪漫的灵感必须经过严谨的数学抽象和工程实践的淬炼,才能化为真正强大的计算模型。现代神经网络,早已超越了简单的模仿,发展成为一门博大精深的、以数学和计算机科学为基础的独立学科。

在本章的旅程中,我们将追随先驱的脚步,完成这次从仿生到建模的伟大跨越。我们将从构成智能的最基本单元“神经元”出发,观察它是如何从生物概念被抽象为数学函数。接着,我们将用它搭建出最简单的“感知机”网络,并直面其历史性的局限。然后,我们将见证“深度”的诞生——通过引入隐藏层构建多层感知机,看它如何突破瓶颈。我们还将巡礼赋予网络非线性力量的“激活函数”,并为网络装上评判是非的“损失函数”。最后,我们将揭开网络学习的终极奥秘——反向传播算法,看梯度下降与链式法则如何完美结合,驱动整个网络进行自我优化。

准备好了吗?让我们深入源头,探寻神经网络思想的最初灵感,揭开神经网络的神秘面纱,并最终亲手构建起通往人工智能的阶梯。

4.1 从生物神经元到人工神经元:模型的灵感来源

在计算机科学的殿堂里,很少有哪个领域像神经网络一样,其最初的构想与生命科学的联系如此紧密。为了创造智能,先驱们首先将目光投向了已知的、最高效的智能系统——人类大脑。

4.1.1 生物神经元(Biological Neuron):生命智能的基石

我们的大脑是由大约860亿个称为神经元的特殊细胞组成的复杂网络。这些神经元是信息处理的基本单位,它们协同工作,构成了我们的思想、记忆和感知。一个典型的生物神经元,其结构和工作方式可以被简化为以下几个关键部分:

核心结构

- 树突(Dendrites):它们像天线一样,是神经元的“输入端”。树突从成千上万个其他的上游神经元那里接收电化学信号。

- 细胞体(Soma):这是神经元的“处理中心”。它将所有从树突接收到的信号进行整合、累加。

- 轴突(Axon):这是一条长长的“输出线”。当细胞体整合后的信号强度达到某个临界点时,轴突会将一个标准的电信号传递给下游的其他神经元。

工作原理: “全或无”的激活模式 生物神经元的工作方式,遵循一种**“全或无”(All-or-None)的原则。细胞体持续地累加来自树突的输入信号。只有当这些信号的总和,在短时间内超过一个特定的激活阈值(Activation Threshold)**时,这个神经元才会被“激活”(或称“兴奋”、“放电”)。

一旦被激活,它就会通过轴突,向下游的神经元发送一个强度和波形都完全相同的标准电化学脉冲。如果信号总和没有达到阈值,神经元则保持静默,不产生任何输出。这种非0即1的开关特性,是生物智能进行信息编码和传递的基础。

4.1.2 人工神经元(Artificial Neuron):一次优雅的数学抽象

早期的人工智能研究者们,被生物神经元这种简洁而强大的工作模式所启发,试图用数学的语言来对其进行建模。这个模型,就是人工神经元,它构成了所有神经网络的最基本单元。

模型的建立

让我们看看,生物过程是如何被一步步翻译为数学语言的:

-

输入与权重 生物神经元通过树突接收来自多个上游神经元的信号。在人工神经元模型中,这被抽象为一组输入

x₁, x₂, ..., xₙ。每个输入,都与一个权重w₁, w₂, ..., wₙ相关联。这个权重wᵢ,模拟了生物神经元中突触连接的“强度”。一个大的正权重,意味着这个输入信号对神经元的激活有很强的“兴奋”作用;一个大的负权重,则代表有很强的“抑制”作用。 -

整合与偏置 生物神经元的细胞体负责整合所有输入信号。在数学模型中,这个过程被简化为对所有输入的加权求和:

z = (w₁x₁ + w₂x₂ + ... + wₙxₙ)。 此外,模型还引入了一个额外的参数,称为偏置(Bias)b。加权和会与这个偏置项相加:z = (Σwᵢxᵢ) + b。偏置项可以被看作是神经元固有的激活倾向。一个大的正偏置,意味着这个神经元本身就更容易被激活,即使输入信号不强。它在数学上确保了即使所有输入都为0,神经元也能产生输出,增加了模型的灵活性。 -

激活函数 生物神经元“全或无”的激活机制,被一个称为激活函数(Activation Function)

f()的数学函数所取代。这个函数接收整合后的信号z作为输入,并产生神经元的最终输出y。激活函数决定了神经元在接收到特定强度的信号后,应该做出何种程度的响应。

数学形式

综上所述,一个人工神经元的完整数学表达形式为:

y = f( (w₁x₁ + w₂x₂ + ... + wₙxₙ) + b )

使用我们在第二章学过的线性代数知识,这个公式可以被更简洁地写成向量形式:

y = f(wᵀx + b)

其中:

x是输入的特征向量。w是权重的参数向量。b是偏置标量。wᵀx是权重与输入的点积。f是激活函数。

这个简洁而优雅的数学模型,就是人工神经元的核心。它虽然是对复杂生物过程的极大简化,却抓住了“加权输入、整合、非线性激活”这一核心思想。它将作为我们构建所有复杂神经网络的“乐高积木”。

4.2 感知机(Perceptron):最简单的神经网络

有了人工神经元这个基本构建块,我们就可以搭建出史上第一个、也是最简单的神经网络模型——感知机。它由科学家弗兰克·罗森布拉特于1957年提出,是神经网络研究的开山之作。

4.2.1 单层感知机:线性分类的先行者

模型结构 一个单层感知机,其结构极其简单:它仅包含一个输入层和一个输出层。输出层通常只有一个我们刚刚定义的人工神经元。数据从输入层进入,经过这个神经元的处理后,直接得到最终的输出结果。

激活函数:阶跃函数 在最初的感知机模型中,为了最直接地模拟生物神经元“全或无”的特性,它使用的激活函数是一个简单的阶跃函数(Step Function),也称为Heaviside函数: f(z) = 1 如果 z ≥ 0 f(z) = 0 如果 z < 0 这意味着,如果加权和 wᵀx + b 大于或等于0,神经元就输出1(被激活);否则,就输出0(不激活)。这使得感知机非常适合执行二分类任务。

学习规则 感知机的学习算法同样非常直观。对于一个训练样本,在做出预测后:

通过在训练数据上反复迭代这个简单的更新规则,感知机能够自动地学习到一组可以正确划分数据的权重和偏置。

- 如果预测正确,权重

w和偏置b保持不变。 - 如果预测错误:

- 真实为1,预测为0:说明加权和太小了,需要增大。因此,将输入向量

x按一定比例(学习率η)加到权重向量w上(w = w + ηx),同时增大偏置b。 - 真实为0,预测为1:说明加权和太大了,需要减小。因此,从权重向量

w中减去输入向量x(w = w - ηx),同时减小偏置b。

- 真实为1,预测为0:说明加权和太小了,需要增大。因此,将输入向量

4.2.2 感知机的局限性:XOR问题的困境

感知机在当时引起了巨大的轰动,人们一度认为通往机器智能的道路已经敞开。然而,它的一个致命缺陷很快被揭示出来,这个发现直接导致了神经网络研究的第一次“寒冬”。

线性可分性 让我们回顾一下感知机的决策过程。它将数据分为两类的边界是 wᵀx + b = 0。在二维空间中,这是一个方程 w₁x₁ + w₂x₂ + b = 0,这正是一条直线的方程。在三维空间中,它是一个平面;在更高维的空间中,它是一个超平面。

这意味着,单层感知机本质上是一个线性分类器。它只能解决那些可以用一条直线(或一个超平面)就能将两类样本完美分开的问题。这类问题,我们称之为线性可分(Linearly Separable)问题。

XOR困境 问题在于,现实世界中许多问题都不是线性可分的。其中最著名、最简单的例子,就是异或(XOR)问题。 XOR逻辑关系如下:

当我们将这四个点绘制在二维平面上时,会发现:我们永远无法用一条直线,将代表输出0的两个点 (0,0), (1,1) 和代表输出1的两个点 (0,1), (1,0) 分开。

这个看似简单的XOR问题,成为了单层感知机无法逾越的鸿沟。1969年,马文·明斯基和西摩尔·派普特在他们的著作《感知机》中,系统地论证了这一局限性,并悲观地预测了神经网络研究的前景。这给当时热情高涨的AI社区泼了一盆冷水,导致该领域的研究经费被大量削减,进入了长达近二十年的停滞期。

- 输入

(0, 0)-> 输出0 - 输入

(0, 1)-> 输出1 - 输入

(1, 0)-> 输出1 - 输入

(1, 1)-> 输出0

然而,正如历史上的许多危机一样,XOR困境也孕育着突破的种子。如何打破线性分类的枷锁?答案,就在于增加网络的“深度”。

4.3 多层感知机(MLP):构建深度网络的第一步

让我们从那片曾经让神经网络研究陷入沉寂的“XOR困境”出发,见证它是如何被克服,并由此开启通往“深度”学习的康庄大道的。

单层感知机的失败,并非宣告了神经网络思想的终结,而是激发了研究者们更深层次的思考。既然单层网络的能力有限,我们能否通过堆叠更多的层次来构建一个更强大的模型呢?答案是肯定的,这便引出了多层感知机(Multi-Layer Perceptron, MLP)。

4.3.1 突破局限:引入隐藏层

MLP的结构 多层感知机的结构,相较于单层感知机,其关键的、革命性的变化在于:在输入层(Input Layer)和输出层(Output Layer)之间,加入了一个或多个隐藏层(Hidden Layers)。

- 输入层:负责接收原始数据,其节点数等于特征的数量。它不进行计算,仅作为数据入口。

- 隐藏层:位于输入层和输出层之间,是MLP的核心。每个隐藏层都由若干个人工神经元组成。它们不直接与外界交互(既不接收原始输入,也不产生最终输出),其存在对用户来说是“隐藏”的,故得此名。

- 输出层:负责产生模型的最终预测结果。其节点数取决于任务类型(回归任务通常为1个,多分类任务通常为类别数)。

“深度”的诞生 一个网络中隐藏层的数量,决定了它的“深度”。拥有一个或多个隐藏层的神经网络,才开始具备了“深度”的含义,是**深度学习(Deep Learning)**这个术语的由来。虽然一个仅含单个隐藏层的MLP通常被称为“浅层”网络,但它已经播下了通往“深度”的种子。

4.3.2 隐藏层的作用:特征的组合与变换

隐藏层究竟施展了怎样的“魔法”,从而克服了单层感知机的局限呢?其核心在于特征的非线性组合与层次化学习。

解决XOR问题 让我们回到XOR困境。一个单层感知机只能画出一条直线,无法解决这个问题。但一个带有一个隐藏层(例如,包含两个神经元)的MLP却可以轻松应对。

一个直观的图解思路:

- 隐藏层的第一个神经元:它可以学习到一条决策边界(比如一条斜线),将点

(1,1)与其他三个点分开。- 隐藏层的第二个神经元:它可以学习到另一条决策边界(比如另一条斜线),将点

(0,0)与其他三个点分开。- 输出层的神经元:它不再直接处理原始的输入

(x₁, x₂),而是处理来自两个隐藏层神经元的输出。它可以学习到一个简单的逻辑:当且仅当第一个隐藏神经元和第二个隐藏神经元都不被激活时,才最终输出1。通过这种方式,MLP不再是画一条直线,而是通过隐藏层学习到了两个不同的线性边界,再由输出层对这两个边界的结果进行组合,从而构造出了一个能够完美包围住

(0,1)和(1,0)的非线性决策区域。单层感知机的线性枷锁,就此被打破。

特征的层次化学习 解决XOR问题只是牛刀小试。隐藏层更深刻的意义在于,它开启了特征的层次化学习(Hierarchical Feature Learning)。

- 第一层隐藏层:直接与原始输入数据相连。它可以学习到一些初级的、简单的特征。例如,在图像识别任务中,第一层可能学会识别边缘、角点、颜色块等基本模式。

- 更深的隐藏层:它们不再看原始数据,而是以上一层隐藏层的输出(即初级特征)作为输入。因此,它们可以在这些初级特征的基础上,学习到更复杂、更抽象的组合特征。例如,第二层可能学会将边缘和角点组合成眼睛、鼻子、耳朵等部件。

- 更深……:第三层可能将眼睛、鼻子等部件组合成一张人脸的轮廓。

这正呼应了我们在第二章中提到的“空间变换”的概念。MLP的每一层,都在对前一层所处的特征空间进行一次复杂的非线性变换,目的是将数据逐步映射到一个新的空间,在这个空间里,不同类别的数据能够被更容易地区分开来。这种自动学习有效特征表示的能力,是深度学习相比传统机器学习最核心的优势之一。

4.4 激活函数:赋予网络非线性

在MLP的讨论中,我们提到了“非线性”这个关键词。赋予网络这种至关重要的非线性能力的组件,正是激活函数。

4.4.1 为何需要非线性?

线性叠加的瓶颈 假设我们构建一个多层网络,但不使用任何激活函数(或者说,使用一个线性的激活函数 f(x)=x)。那么,第一层的输出是 W₁x + b₁。第二层的输出将是 W₂(W₁x + b₁) + b₂ = (W₂W₁)x + (W₂b₁ + b₂)。 无论我们堆叠多少层,最终的结果 (W_n...W₂W₁)x + ... 始终可以被化简为一个等效的单层线性变换 W'x + b'。这意味着,如果没有非线性激活函数,一个深度神经网络的表达能力将被退化为一个单层的线性网络,从而完全失去了“深度”的意义,也无法解决像XOR这样的非线性问题。

表达能力的源泉 非线性激活函数是网络能够拟合任意复杂函数的关键。它在每一层线性变换(wᵀx + b)之后,对特征空间进行一次“弯曲”或“折叠”。正是这些连续的、非线性的扭曲操作,使得神经网络有能力去逼近(fit)数据中任何复杂的、非线性的潜在规律。根据通用近似定理(Universal Approximation Theorem),一个带有一个隐藏层和非线性激活函数的MLP,只要隐藏层神经元数量足够多,理论上就可以以任意精度近似任何连续函数。

4.4.2 常用激活函数巡礼

选择合适的激活函数,对网络的训练速度和性能至关重要。以下是几位在神经网络发展史中扮演了重要角色的激活函数。

Sigmoid函数:经典的S形曲线

- 函数:

σ(x) = 1 / (1 + e⁻ˣ) - 特性:将任意实数输入平滑地压缩到

(0, 1)区间。这使得它的输出可以被解释为概率,在早期被广泛应用于二分类问题的输出层。 - 缺点:

- 梯度消失(Vanishing Gradients):当输入值非常大或非常小时,Sigmoid函数的曲线变得非常平坦,其导数(梯度)接近于0。在深层网络中,这些接近0的梯度在反向传播时会层层相乘,导致传到浅层网络的梯度信号变得极其微弱,使得浅层网络的参数几乎无法更新。

- 输出非零中心:其输出恒为正,这会导致后续层的输入都是非零中心的,可能降低梯度下降的收敛效率。

Tanh函数(双曲正切):零中心化的S形曲线

- 函数:

tanh(x) = (eˣ - e⁻ˣ) / (eˣ + e⁻ˣ) - 特性:将输入压缩到

(-1, 1)区间。其输出是零中心的,这在实践中通常比Sigmoid函数有更好的性能,收敛速度更快。 - 缺点:它同样是一条S形曲线,因此也无法避免在饱和区的梯度消失问题。

ReLU (Rectified Linear Unit):现代网络的默认选择

- 函数:

ReLU(x) = max(0, x) - 特性:这是一个极其简单的分段线性函数。当输入为正时,输出等于输入;当输入为负时,输出为0。

- 优点:

- 缓解梯度消失:在正数区间,其导数恒为1,这极大地缓解了梯度消失问题,使得深层网络可以得到有效的训练。

- 计算高效:相比Sigmoid和Tanh涉及的指数运算,ReLU的计算成本极低。

- 稀疏性:它会使一部分神经元的输出为0,这造成了网络的稀疏性,可能有助于提取更有意义的特征。

- 缺点:

- Dying ReLU(死亡ReLU)问题:如果一个神经元的输入在训练过程中始终为负,那么它的输出将永远是0,梯度也永远是0。这个神经元将不再对任何数据有响应,也无法再进行学习,如同“死亡”了一般。

ReLU的变体:应对“死亡”问题 为了解决Dying ReLU问题,研究者们提出了一些改进版本:

- Leaky ReLU:

f(x) = x如果x > 0,f(x) = αx如果x ≤ 0。它为负区间引入一个微小的、固定的正斜率α(如0.01),确保神经元在负输入时也能有非零梯度。 - ELU (Exponential Linear Unit):在负区间,它是一条平滑的指数曲线,而不是直线。理论上它结合了ReLU和Leaky ReLU的优点,对噪声更具鲁棒性,但计算成本稍高。

4.5 损失函数:衡量“理想”与“现实”的差距

我们已经构建了网络的结构,并为其注入了非线性的活力。但我们如何告诉网络它的表现是好是坏呢?这就需要损失函数(Loss Function)。

4.5.1 损失函数(Loss Function)的角色

优化的“导航员” 损失函数(有时也称成本函数或目标函数)是一个用于量化模型预测值 Ŷ 与真实标签 Y 之间差距的函数。这个差距值,我们称之为损失(Loss)。 损失值就是一个标量,它代表了模型在当前训练样本上“犯错”的程度。损失越大,说明模型错得越离谱。

目标 整个神经网络的训练过程,其唯一的目标,就是通过不断调整网络内部的权重和偏置参数,来使得在整个训练数据集上的总损失函数的值尽可能小。损失函数为我们的优化过程(如梯度下降)提供了明确的、可量化的目标和方向。

4.5.2 常见的损失函数

损失函数的选择,取决于我们所面对的任务类型。

均方误差(MSE, Mean Squared Error)

适用场景:主要用于回归任务,即预测一个连续值(如房价、温度)。

数学形式:L(Y, Ŷ) = (1/n) * Σ(Yᵢ - Ŷᵢ)² 它计算的是预测值与真实值之差的平方的平均值。

交叉熵损失(Cross-Entropy Loss)

适用场景:是分类任务的标准损失函数。

二元交叉熵(Binary Cross-Entropy):用于二分类问题(如判断邮件是否为垃圾邮件)。它通常与输出层的单个Sigmoid激活函数配合使用。

分类交叉熵(Categorical Cross-Entropy):用于多分类问题(如识别图片是猫、狗还是鸟)。它通常与输出层的Softmax激活函数配合使用。Softmax函数能将一组任意实数转换为一个概率分布(所有输出值在(0,1)之间且总和为1)。

为何优于MSE:在分类任务中,如果使用MSE,当模型的预测概率远离真实标签(如真实为1,预测为0.001)时,其梯度可能会变得很小,导致学习非常缓慢。而交叉熵损失在这种情况下能提供一个非常大的梯度信号,从而促使模型更快地修正错误。

4.6 反向传播算法:网络学习的引擎

我们有了网络结构、激活函数和损失函数。现在,最关键的问题来了:我们究竟该如何系统性地调整那成千上万个参数,来最小化损失呢?答案就是大名鼎鼎的反向传播(Backpropagation)算法。

4.6.1 算法的宏观理解

目标 反向传播算法的唯一目标,就是高效地计算出损失函数 L 关于网络中所有参数(每一个权重 w 和偏置 b)的梯度(偏导数)。

两个阶段 一次完整的训练迭代,包含两个阶段:

- 前向传播(Forward Pass):将一个或一批训练数据输入网络。数据从输入层开始,逐层流过网络,经过每一层的线性变换和非线性激活,直到输出层产生最终的预测值

Ŷ。然后,用损失函数计算出Ŷ和真实标签Y之间的损失值L。 - 反向传播(Backward Pass):这是算法的精髓。它从最终的损失

L出发,“反向”地、逐层地穿越网络。在每一层,它都利用我们在第二章学过的链式法则,来计算损失L对当前层参数的梯度,并将误差信号继续向后传递。

4.6.2 梯度下降与链式法则的完美结合

梯度下降的应用 一旦反向传播完成了它的使命,为我们提供了所有参数的梯度,梯度下降(或其更高级的变体,如Adam、RMSprop,我们将在后续章节详述)就会接管工作。它根据以下公式来更新每一个参数: 新参数 = 旧参数 - 学习率 * 梯度 这个简单的更新步骤,会使参数向着能减小损失的方向移动一小步。

算法的直观感受 我们可以将一次完整的前向+反向传播过程,比作一次高效的“责任分配”大会:

- 前向传播是“业绩汇报”:模型根据现有能力(参数),对输入数据做出预测,并计算出与目标(真实标签)之间的“业绩差额”(Loss)。

- 反向传播是“责任追溯”:从这个“总差额”开始,算法像一位明察秋毫的审计官,利用链式法则,将总责任精准地、按贡献度地层层分解,最终落实到每一个基层员工(参数)头上,明确地告诉它:“您对这次的错误负有xx程度的责任,您应该朝着xx方向改正。”

通过在整个数据集上成千上万次地重复这个“汇报-追责-改正”的循环,神经网络这个庞大的组织,就能够从一个随机的、无序的状态,逐步演化为一个分工明确、配合默契、能够高效完成特定任务的智能系统。

小结

在本章中,我们完成了从零到一的构建。从生物神经元的灵感闪现,到人工神经元的数学抽象;从单层感知机的线性局限,到多层感知机通过引入隐藏层和非线性激活函数所实现的突破;我们还为网络装配了衡量对错的“损失函数”,并最终揭示了驱动其学习的引擎——反向传播算法。

读者现在应该对一个基本的神经网络是如何构成、如何工作、以及如何学习的,有了一个清晰而完整的认识。这些基础概念,是理解后续所有更高级、更复杂的网络结构(如卷积神经网络CNN、循环神经网络RNN)的绝对基石。带着这份坚实的基础,我们即将在下一章,真正踏入使用现代深度学习框架进行实战的激动人心的旅程。

第五章:深度学习框架入门与实战

从理论到代码 —— 巨人的力量

在前面的章节中,我们已经深入探索了神经网络的理论基石。我们理解了神经元的数学模型,见证了“深度”如何赋予网络强大的表达能力,也揭示了反向传播算法驱动模型学习的奥秘。然而,如果将这些理论从零开始,用纯粹的Python和NumPy来实现一个复杂的现代神经网络,那将是一项极其繁琐、易错且效率低下的工程。我们将不得不手动管理成千上万的参数,亲手编写复杂的梯度计算链条,并费尽心力去调用底层硬件进行加速。

幸运的是,我们不必重复造轮。我们站在巨人的肩膀上,这些巨人,就是深度学习框架。

一个现代的深度学习框架,如同一个专为神经网络打造的强大“操作系统”。它为我们封装了所有繁杂的底层细节:从高效的张量运算,到神奇的自动求导机制,再到对GPU/TPU等专用硬件的无缝利用。它将我们从纷繁的工程细节中解放出来,让我们能够将宝贵的精力专注于模型架构本身的设计、实验与创新。

在当今的深度学习世界,群雄并起,但真正的舞台主角,无疑是两大巨头:由Google支持的TensorFlow和由Facebook(Meta)主导的PyTorch。它们如同武林中的少林与武当,各自代表了一种独特的气质与哲学:TensorFlow以其无与伦比的生态系统、工业级的部署能力和稳健性著称,是业界应用的首选;而PyTorch则以其灵动、优雅、与Python深度融合的设计,赢得了广大学术研究者和算法工程师的青睐。

精通其中之一,足以让您在深度学习领域游刃有余;而两者皆通,则能让您洞察不同设计哲学下的利弊权衡,根据不同场景选择最合适的工具。

本章的目标,正是要带领读者跨越从理论到代码的鸿沟。我们将并肩探索TensorFlow 2.x与PyTorch的核心设计与使用方法,通过亲手编写代码,完成从数据准备、模型搭建、训练到评估的完整流程。最后,我们还将提供一份详尽的环境搭建指南,帮助您打造一个属于自己的、高效稳定的深度学习“炼丹炉”。

准备好将理论化为指尖的力量了吗?让我们即刻启程。

5.1 TensorFlow 2.x 与 Keras:Google的工业级解决方案

TensorFlow是深度学习领域无可争议的重量级选手。它不仅仅是一个库,更是一个庞大的生态系统,涵盖了从研究原型到生产部署,再到移动端和物联网设备的全链路解决方案。

5.1.1 框架的演进与哲学

从TensorFlow 1.x到2.x:一场深刻的变革 早期的TensorFlow 1.x采用的是一种称为**“静态图”(Define-and-Run)**的模式。开发者需要先像绘制电路图一样,完整地定义出整个计算图的结构,然后再向这个固定的图中“注入”数据来执行计算。这种模式虽然有利于进行全局优化和跨平台部署,但其编写和调试过程却相当繁琐和反直觉,令许多初学者望而却步。

认识到这一点后,Google在TensorFlow 2.x中进行了一场深刻的自我革命,其核心是拥抱了“动态图”(Define-by-Run)作为默认执行模式。这意味着代码会像普通的Python程序一样,按顺序立即执行,计算图在运行时动态构建。这使得调试变得异常简单,代码也更加直观。更重要的是,TF 2.x做出了一个明智的决定:将Keras提升为官方唯一指定的高级API。

Keras:为人类而非机器设计的API Keras是由François Chollet创建的一个深度学习库,其核心设计哲学是**“易用性优先”**。它追求以最少的代码、最清晰的逻辑来构建神经网络,让开发者能够快速地将想法转化为实验结果。Keras的API简洁、高度模块化且易于扩展,如同深度学习领域的“乐高积木”。在TF 2.x中,Keras不再是一个独立的库,而是深度整合为tf.keras,成为了与TensorFlow交互的首选方式。

5.1.2 TensorFlow核心概念:深入引擎室

尽管Keras为我们隐藏了许多底层细节,但理解其背后的核心组件,能让我们在使用时更加得心应手。

张量(tf.Tensor):不可变的基石 正如我们在第二章所学,张量是深度学习的基本数据单元。在TensorFlow中,tf.Tensor对象是承载数据的核心。它与NumPy的ndarray非常相似,可以存储标量、向量、矩阵等。一个关键特性是,tf.Tensor是不可变的(immutable)。一旦创建,您无法改变它的值,只能通过运算创建新的张量。

import tensorflow as tf

# 创建一个常量张量

a = tf.constant([[1.0, 2.0], [3.0, 4.0]])

print(a)

# 张量运算会创建新的张量

b = a + 10

print(b)

# 与NumPy的无缝转换

numpy_array = b.numpy()

print(type(numpy_array))

变量(tf.Variable):可变的模型参数 既然张量是不可变的,那我们如何存储和更新需要在训练中不断变化的**模型参数(权重和偏置)**呢?答案是使用tf.Variable。它是一个特殊的、可变的张量,专门用于存储模型状态。

# 创建一个变量

v = tf.Variable([[1.0, 2.0], [3.0, 4.0]])

print(f"Is Variable: {tf.is_tensor(v)}") # Variable也是一种Tensor

# 可以使用 .assign() 方法就地修改值

v.assign(v + 10)

print(v)

自动求导(tf.GradientTape):反向传播的魔术师 tf.GradientTape是TensorFlow 2.x实现自动求导的核心工具。它的工作原理可以用一个生动的比喻来理解:

磁带录音机比喻: 当您创建一个

tf.GradientTape的上下文环境时,就好比按下了一台老式磁带录音机的“录制”按钮。在此环境中发生的所有涉及tf.Variable或被监视的tf.Tensor的运算,都会被这台“录音机”记录在一条虚拟的“磁带”上。当您完成了前向传播的计算(比如算出了损失),就可以调用磁带的

.gradient()方法。这好比按下了“倒带”并“播放”,TensorFlow会沿着记录的路径反向追溯,并利用链式法则自动计算出您指定的目标(如损失)关于所有被记录的变量的梯度。

# 演示计算 y = x² 在 x=3 时的梯度

x = tf.Variable(3.0)

with tf.GradientTape() as tape:

y = x ** 2

# 计算梯度 dy/dx

grad = tape.gradient(y, x)

print(grad) # 输出 tf.Tensor(6.0, shape=(), dtype=float32)

5.1.3 Keras实战:三步完成模型搭建

掌握了Keras,构建一个神经网络就像搭积木一样简单,通常遵循“定义-编译-训练”三部曲。

序贯模型(Sequential API):快速搭建线性堆叠 Sequential模型是最简单、最常用的模型类型,适用于绝大多数层与层之间呈线性顺序堆叠的网络。

代码实战:构建一个简单的MLP用于分类

import tensorflow as tf

from tensorflow import keras

from tensorflow.keras import layers

# 1. 定义模型:像搭积木一样添加层

model = keras.Sequential([

# 输入层:将28x28的图片展平为784维的向量

layers.Flatten(input_shape=(28, 28)),

# 第一个隐藏层:128个神经元,使用ReLU激活函数

layers.Dense(128, activation='relu'),

# 第二个隐藏层:64个神经元,使用ReLU激活函数

layers.Dense(64, activation='relu'),

# 输出层:10个神经元(对应10个类别),使用Softmax输出概率

layers.Dense(10, activation='softmax')

])

# 打印模型结构

model.summary()

# 2. 编译模型:配置优化器、损失函数和评估指标

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# 假设我们有准备好的训练数据 (x_train, y_train) 和测试数据 (x_test, y_test)

# (x_train, y_train), (x_test, y_test) = keras.datasets.mnist.load_data()

# x_train, x_test = x_train / 255.0, x_test / 255.0 # 归一化

# 3. 训练模型:将数据“喂”给模型

# history = model.fit(x_train, y_train, epochs=5, batch_size=32, validation_split=0.2)

# 评估模型

# test_loss, test_acc = model.evaluate(x_test, y_test)

# print(f'\nTest accuracy: {test_acc}')

函数式API(Functional API):构建复杂的非线性网络 当模型结构变得复杂,例如需要处理多输入、多输出,或者网络中存在共享层、残差连接等非线性拓扑结构时,Sequential模型便无能为力。这时,更灵活的函数式API就派上了用场。它将网络层视为可以调用的函数,允许您构建任意的有向无环图。

代码实战:构建一个简单的多输入模型 假设我们有一个模型,同时接收一个主输入和一个辅助输入。

# 定义输入层

main_input = keras.Input(shape=(100,), name='main_input')

aux_input = keras.Input(shape=(10,), name='aux_input')

# 主流程

x = layers.Dense(64, activation='relu')(main_input)

x = layers.Dense(32, activation='relu')(x)

# 辅助输入与主流程合并

merged = layers.concatenate([x, aux_input])

# 定义输出层

main_output = layers.Dense(1, name='main_output')(merged)

aux_output = layers.Dense(1, name='aux_output')(x) # 辅助输出

# 使用输入和输出张量列表来实例化模型

complex_model = keras.Model(inputs=[main_input, aux_input],

outputs=[main_output, aux_output])

complex_model.summary()

5.2 PyTorch:Facebook的动态图与研究者首选

如果说TensorFlow是严谨的工程师,那么PyTorch就是一位灵动的艺术家。它以其优雅和对Python语言的深度融合,成为了学术界和快速原型开发领域的宠儿。

5.2.1 框架的哲学与气质

-

Pythonic的设计 PyTorch的设计哲学是“尽可能地像Python”。它的API和用法非常符合Python程序员的直觉。在PyTorch中,您可以像调试普通Python代码一样,使用

print()或任何调试工具来检查任意中间变量,这得益于其动态图的本质。 -

动态图的灵活性 PyTorch从诞生之初就采用动态计算图(Define-by-Run)。计算图是在代码运行时,随着运算的发生而动态建立的。这意味着您可以使用Python所有原生的控制流语句(如

if-else、for循环)来自由地改变网络的行为。这种灵活性对于处理变长输入的自然语言处理(NLP)任务,或进行复杂的算法研究至关重要。

5.2.2 PyTorch核心概念:三大支柱

-

张量(

torch.Tensor):数据与梯度的载体torch.Tensor是PyTorch的核心数据结构,与NumPy的ndarray极为相似,并且两者可以高效、无缝地共享底层内存进行转换(在CPU上),避免了数据拷贝的开销。 -

自动求导(

torch.autograd):动态图的引擎autograd是PyTorch的自动求导引擎。它的工作方式与GradientTape类似,但集成得更加无缝:requires_grad属性:当您创建一个张量时,可以设置requires_grad=True。这会告诉PyTorch,需要追踪所有发生在该张量上的操作。.backward()方法:在一个标量(通常是计算出的loss)上调用.backward()方法,PyTorch会自动计算所有requires_grad=True的张量相对于该标量的梯度。.grad属性:计算出的梯度会累积到对应张量的.grad属性中。

-

神经网络模块(

torch.nn):模型组件的蓝图torch.nn是PyTorch中用于构建神经网络的核心模块。nn.Module:所有神经网络层(如nn.Linear,nn.Conv2d)和模型容器的基类。构建自定义模型时,您需要创建一个继承自nn.Module的类。在__init__方法中定义好所有需要的层,然后在forward方法中,明确地定义数据是如何从输入流向输出的(即前向传播的逻辑)。

5.2.3 PyTorch实战:标准的五步训练流程

PyTorch不像Keras那样提供一个高度封装的.fit()方法。它鼓励(或者说,要求)用户自己编写训练循环。这虽然代码量稍多,但赋予了用户对训练过程每一个细节的完全控制力。

代码实战:从零构建MLP训练流程

import torch

import torch.nn as nn

import torch.optim as optim

from torch.utils.data import DataLoader, TensorDataset

# 1. 准备数据 (假设我们有Numpy数组 x_train_np, y_train_np)

# x_train_tensor = torch.from_numpy(x_train_np).float()

# y_train_tensor = torch.from_numpy(y_train_np).long()

# train_dataset = TensorDataset(x_train_tensor, y_train_tensor)

# train_loader = DataLoader(dataset=train_dataset, batch_size=32, shuffle=True)

# 2. 定义模型:创建一个继承自 nn.Module 的类

class MLP(nn.Module):

def __init__(self):

super(MLP, self).__init__()

self.flatten = nn.Flatten()

self.layers = nn.Sequential(

nn.Linear(28*28, 128),

nn.ReLU(),

nn.Linear(128, 64),

nn.ReLU(),

nn.Linear(64, 10)

)

def forward(self, x):

x = self.flatten(x)

logits = self.layers(x)

return logits

device = "cuda" if torch.cuda.is_available() else "cpu"

model = MLP().to(device)

print(model)

# 3. 定义损失函数和优化器

criterion = nn.CrossEntropyLoss() # CrossEntropyLoss内部已包含Softmax

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 4. 编写训练循环

num_epochs = 5

# for epoch in range(num_epochs):

# model.train() # 设置为训练模式

# for inputs, labels in train_loader:

# inputs, labels = inputs.to(device), labels.to(device)

#

# # a. 清空梯度

# optimizer.zero_grad()

#

# # b. 前向传播

# outputs = model(inputs)

#

# # c. 计算损失

# loss = criterion(outputs, labels)

#

# # d. 反向传播

# loss.backward()

#

# # e. 更新权重

# optimizer.step()

#

# print(f'Epoch [{epoch+1}/{num_epochs}], Loss: {loss.item():.4f}')

# 5. 编写评估逻辑

# model.eval() # 设置为评估模式

# with torch.no_grad(): # 在此上下文中,不计算梯度,节省内存和计算

# correct = 0

# total = 0

# for inputs, labels in test_loader:

# inputs, labels = inputs.to(device), labels.to(device)

# outputs = model(inputs)

# _, predicted = torch.max(outputs.data, 1)

# total += labels.size(0)

# correct += (predicted == labels).sum().item()

# print(f'Accuracy on test set: {100 * correct / total} %')

5.3 环境搭建:打造自己的“炼丹炉”

工欲善其事,必先利其器。一个稳定、隔离、可复现的开发环境,是高效进行深度学习研究与实践的基石。

5.3.1 包与环境管理:Conda的艺术

为何需要环境管理 在软件开发中,我们经常会遇到“依赖地狱”:项目A需要库X的1.0版本,而项目B需要库X的2.0版本。如果在全局环境中安装,这两个项目将无法同时工作。虚拟环境就是解决这个问题的良方。它为每个项目创建一个独立的、隔离的Python环境,您可以在其中安装任意版本的库,而不会影响到其他项目。

Conda核心命令 Conda是目前最流行、最强大的Python环境和包管理器之一。

- 创建新环境:

conda create --name my_dl_env python=3.9 - 激活环境:

conda activate my_dl_env - 安装包:

conda install numpy pandas matplotlib或pip install tensorflow - 查看已安装的包:

conda list - 退出环境:

conda deactivate

5.3.2 交互式编程环境:Jupyter Notebook/Lab

-

Jupyter的优势 Jupyter Notebook/Lab是一个基于Web的交互式计算环境。它允许您创建和共享包含实时代码、公式、可视化和叙述性文本的文档。这种“文学式编程”的风格,使其成为数据科学探索、快速原型验证和教学演示的理想工具。

-

安装与启动 在激活了您的Conda环境后,通过以下命令安装:

conda install -c conda-forge jupyterlab然后,在您的项目文件夹下,通过命令行启动:jupyter lab

5.3.3 GPU加速配置指南:为模型插上翅膀

CPU vs. GPU CPU(中央处理器)和GPU(图形处理器)的设计目标不同。

- CPU:像一位博学的教授,拥有少数几个强大而复杂的计算核心,擅长处理逻辑复杂、需要按顺序执行的任务。

- GPU:像一个小学生军团,拥有成百上千个简单但高效的计算核心。它不擅长复杂逻辑,但极其擅长执行大规模、可并行的简单计算任务。 神经网络中的核心运算——大规模的矩阵乘法和加法——正是GPU的用武之地。使用GPU进行训练,通常能比使用CPU带来数十倍甚至上百倍的速度提升。

NVIDIA驱动与CUDA 要使用GPU进行深度学习,需要一块NVIDIA显卡,并正确安装两样东西:

- NVIDIA驱动:确保显卡驱动程序更新到最新版本,可以从NVIDIA官网下载。

- CUDA Toolkit:CUDA是NVIDIA推出的并行计算平台和编程模型。深度学习框架通过CUDA来调用GPU的计算能力。需要根据所使用的TensorFlow或PyTorch版本的要求,从NVIDIA官网下载并安装对应版本的CUDA Toolkit。

验证安装 安装完框架后,可以用以下代码片段来验证GPU是否被成功识别:

- TensorFlow:

import tensorflow as tf print("Num GPUs Available: ", len(tf.config.list_physical_devices('GPU'))) - PyTorch:

import torch print(f"Is CUDA available: {torch.cuda.is_available()}") if torch.cuda.is_available(): print(f"Device name: {torch.cuda.get_device_name(0)}")

小结

在本章中,我们完成了从理论到实践的关键一跃。我们深入探索了当今最主流的两大深度学习框架——TensorFlow与PyTorch。我们不仅学习了它们高级API的便捷用法,更理解了其背后关于张量、自动求导和模型封装的核心设计哲学。通过并排比较Keras的“三部曲”和PyTorch的“五步法”,读者应能体会到两种框架在易用性与灵活性之间的不同取舍。

最后,我们详细介绍了如何使用Conda、Jupyter和NVIDIA工具链,来搭建一个专业、高效的深度学习开发环境。这套“炼丹炉”将是您未来探索更广阔深度学习世界的坚实基础。

手握神兵,炉火已旺。现在,您已经具备了将任何神经网络模型付诸实践的能力。从下一章开始,我们将运用这些工具,去探索深度学习领域中那些更专门、更强大的模型架构。

第六章:深度学习的“炼丹术” —— 训练与优化

从“能跑”到“跑得好”的艺术

在上一章中,我们已经掌握了使用现代框架构建神经网络并使其运行起来的“神兵利器”。然而,让模型“能跑”仅仅是万里长征的第一步。一个未经精心调校的神经网络,往往表现平平,甚至无法收敛。从“能跑”到“跑得好”,这中间的鸿沟,需要一门精深的技艺来跨越——我们称之为深度学习的“炼丹术”。

将模型训练比作一场古代方士的炼丹,并非故弄玄虚。因为这个过程充满了科学的严谨与艺术的直觉。我们需要面对两大核心挑战:

- 优化(Optimization):我们的损失函数,是一个坐落在亿万维度参数空间中的、极其崎岖复杂的“山脉”。如何找到一条最高效、最稳健的路径,从随机的起点出发,顺利抵达山脉的最低谷(全局最优解或一个足够好的局部最优解)?这便是优化的艺术。

- 泛化(Generalization):即便我们在训练这座“山脉”上找到了最低点,又如何保证我们找到的不是一个只适用于这座山的“投机取巧”的捷径,而是一条能够适用于世界上所有类似山脉的“普适法则”?换言之,如何让模型在未曾见过的“测试数据”上依然表现出色?这便是泛化的智慧。

本章的使命,就是为读者系统地传授应对这两大挑战的一系列关键技术与策略。我们将一同探索各种先进的优化器,它们如同性能各异的“交通工具”,帮助我们在损失函数的复杂地形中高效穿行。我们将学习多种正则化技术,它们是防止模型“走火入魔”、陷入“过拟合”的强大“戒律”。我们还会揭示批归一化、超参数调优和权重初始化等一系列“秘法”,它们能极大地加速训练进程,并提升模型的最终性能。

掌握了这些“炼丹术”,读者将不再是一个只会按部就班的“学徒”,而将成长为一位能够洞悉训练动态、诊断模型问题、并对症下药的“炼丹大师”。现在,让我们从选择下山的交通工具开始,踏上这段充满挑战与智慧的旅程。

6.1 优化器详解:寻找最优解的“交通工具”

优化器是深度学习训练过程的心脏。它的职责,是根据反向传播计算出的梯度信息,来指导模型参数如何更新,以期最小化损失函数。选择不同的优化器,就如同在探索损失函数这片广袤而崎岖的“山脉”时,选择了不同的交通工具。

6.1.1 梯度下降的挑战:在崎岖山路中前行

损失函数的“地形” 我们需要在脑海中建立一幅画面:一个深度神经网络的损失函数,其“地形”远比我们想象的要复杂。它不是一个平滑的碗,而是一个坐落在极高维度空间中的、崎岖无比的山脉。这片山脉中,遍布着狭长而陡峭的峡谷,梯度在峡谷两侧方向剧烈变化,但在峡谷延伸方向上却很平缓;还存在着鞍点(Saddle Points),它在某个维度上是最小值,但在另一维度上却是最大值,梯度在此处为零,极易困住优化器;此外,还有无数的局部最小值(Local Minima)。

朴素梯度下降(SGD)的困境 我们最基础的优化算法——随机梯度下降(SGD),其策略非常朴素:只看脚下,哪边最陡就往哪边走一步。这种策略在复杂地形中会遇到诸多麻烦:

- 振荡:在狭长的峡谷中,SGD会在峡谷两侧的峭壁间来回振荡,导致收敛速度极慢。

- 被困:在鞍点或平缓的局部最小值区域,梯度变得非常小甚至为零,SGD会认为已经到达了谷底,从而过早地停止更新。

为了克服这些困境,一系列更智能、更强大的优化器被提了出来。

6.1.2 动量(Momentum):冲过鞍点的“惯性”

物理类比 Momentum优化器的灵感,源于一个简单的物理类比。想象一个有质量的铁球从山上滚下,它的运动轨迹不仅取决于当前位置的坡度(梯度),更受到其自身**惯性(动量)**的影响。即使它滚到一个平坦的区域(梯度为零),由于惯性的存在,它依然会继续前行,从而有可能冲过鞍点或浅的局部最小值。

工作原理 Momentum在SGD的基础上,引入了一个“动量”项 v,它是过去所有梯度的一个指数加权移动平均。参数的更新方向,不再仅仅是当前的梯度 g,而是动量 v: v = β * v + (1-β) * g (更新动量,β通常取0.9) w = w - learning_rate * v (用动量来更新权重)

这种机制带来了两个好处:

- 加速收敛:在梯度方向基本一致的区域(如峡谷的延伸方向),动量会持续累积,使得更新步伐越来越大,从而加速前进。

- 抑制振荡:在梯度方向来回变化的区域(如峡谷的两侧),动量项中的正负梯度会相互抵消,从而抑制了振荡,使优化路径更平滑。

6.1.3 自适应学习率:为每个参数定制“步长”

另一大类优化思想,是让学习率能够自适应(Adaptive)。其核心洞见是:对于模型中不同的参数,我们或许应该使用不同的学习率。

Adagrad (Adaptive Gradient Algorithm) 核心思想:Adagrad认为,那些在训练中更新不频繁的参数(通常对应稀疏特征,其梯度累积较小),可能蕴含着重要的信息,我们应该给它们一个较大的学习率以鼓励其更新;而那些更新频繁的参数(梯度累积较大),则应该给它们一个较小的学习率以求稳定。它通过累积每个参数梯度的平方和来实现这一点。

优点与缺点:Adagrad在处理稀疏数据(如NLP中的词嵌入)时表现出色。但它有一个致命缺陷:由于分母中的梯度平方和是单调递增的,学习率会随着训练的进行而持续、不可逆地下降,最终可能变得过小,导致训练在还未充分收敛时就提前停止了。

RMSprop (Root Mean Square Propagation) 对Adagrad的改进:RMSprop是Geoff Hinton提出的一种对Adagrad的改进算法,旨在解决其学习率过早衰减的问题。它不再是简单地累积所有历史梯度,而是使用梯度的指数加权移动平均。这样,只有近期梯度的信息会被重点考虑,使得学习率可以根据最近的梯度情况动态调整,而不会单调递减。

6.1.4 Adam (Adaptive Moment Estimation):动量与自适应的集大成者

巅峰之作 Adam优化器,是目前深度学习领域最流行、最成功的优化器之一。它的名字已经揭示了其本质:自适应矩估计。Adam巧妙地将我们前面讨论的两大主流思想——Momentum的惯性思想和RMSprop的自适应学习率思想——完美地结合在了一起。

它同时维护了两个指数加权移动平均:

- 一阶矩估计(梯度的平均值):这部分与Momentum非常相似,负责控制更新的方向和惯性。

- 二阶矩估计(梯度平方的平均值):这部分与RMSprop非常相似,负责控制每个参数自适应的学习率。

为何成为“默认选项” 通过这种双重机制,Adam几乎在所有类型的深度学习任务和模型架构中,都表现出了极其出色和稳健的性能。它通常能够快速收敛,并且对超参数的选择(如学习率)相对不那么敏感。因此,在不确定使用哪种优化器时,Adam通常是那个最安全、最高效的默认选项。

6.2 正则化:防止模型“走火入魔”的“戒律”

如果我们只专注于优化,可能会训练出一个在训练集上得分近乎完美的模型。但这往往是一种“假象”,是模型“走火入魔”的开始。这个魔,就是过拟合(Overfitting)。正则化,就是我们为模型设定的一系列“戒律”,防止它误入歧途。

6.2.1 过拟合(Overfitting):智慧的“诅咒”

现象与本质 过拟合的典型现象是:模型在训练集(Training Set)上表现极佳(损失很低,精度很高),但在从未见过的测试集(Test Set)或验证集(Validation Set)上却表现糟糕。 其本质是,一个过于强大的模型(参数过多),在有限的训练数据上,不仅学到了数据中普适的、潜在的规律,更学到了数据中独有的噪声和偶然的巧合。它完美地“记忆”了训练样本,却失去了**泛化(Generalize)**到新样本的能力。

奥卡姆剃刀原则 所有正则化技术,其背后的哲学思想都可以追溯到著名的奥卡姆剃刀原则:“如无必要,勿增实体”(Entities should not be multiplied without necessity)。在机器学习中,这意味着:如果有多个模型都能很好地解释数据,我们应该选择那个最简单的模型。因为简单的模型更可能抓住问题的本质,而非表面的噪声。正则化,就是通过各种手段对模型的复杂度施加“惩罚”或“限制”,引导它去寻找那个更简单的解。

6.2.2 L1/L2正则化:为参数戴上“紧箍咒”

L1和L2正则化是最古老、最经典的正则化方法。它们通过在原始的损失函数上,增加一个关于模型权重的“惩罚项”来实现。

L2正则化(权重衰减) 原理:在损失函数后,加上一个与所有权重参数平方和成正比的惩罚项:Loss_new = Loss_original + λ * Σ(w²) 。其中 λ 是正则化强度的超参数。 效果:这个惩罚项会促使优化器在减小原始损失的同时,也尽量减小权重的大小。它倾向于让模型的权重值变得更小、更分散,使得模型的决策边界更平滑,从而降低了对训练数据中个别噪声点的敏感度。在很多框架中,它也被称为权重衰减(Weight Decay)。

L1正则化 原理:在损失函数后,加上一个与所有权重参数绝对值之和成正比的惩罚项:Loss_new = Loss_original + λ * Σ|w|。 效果:L1正则化有一个非常独特的特性。由于绝对值函数在原点处的尖点,它会强烈地驱使那些对模型贡献不大的参数权重,精确地变为零。这相当于自动地进行了一次特征选择,剔除了无效特征,使得最终的模型变得稀疏(Sparse)。

6.2.3 Dropout:随机“失忆”的智慧

Dropout是深度学习时代提出的一种极其强大且简单有效的正则化技术。

工作原理 在训练过程中,对于神经网络的某一层,Dropout会以一个预设的概率 p(例如 p=0.5),随机地将其中的一部分神经元的输出暂时置为零。这意味着,在每一次前向传播中,网络都好像被“阉割”成了一个不同的、更小的“子网络”。而在测试过程中,则会使用完整的、未经丢弃的网络。

效果与隐喻 Dropout的强大效果,可以从两个角度来理解:

- 打破协同适应:它强制一个神经元不能过度依赖于其他某几个特定的神经元。因为它“身边”的任何一个“同事”,都随时可能“罢工”。这迫使网络去学习更加鲁棒、更加独立的特征表示。

- 集成学习的近似:从宏观上看,每一次迭代使用一个不同的子网络进行训练,整个Dropout的训练过程,就好像在同时训练成千上万个共享权重的、不同结构的网络。而在测试时使用完整的网络,则近似于将这些海量的子网络进行**模型集成(Ensemble)**来做预测。这是一种极其廉价而高效的Bagging集成近似,能显著提升模型的泛化能力。

6.2.4 早停(Early Stopping):见好就收的“禅定”

原理 早停是一种充满实践智慧的正则化策略。它的做法是:在训练模型的同时,我们并不只关心模型在训练集上的损失,而是持续地监控它在一个独立的验证集上的性能(例如,验证集上的损失或准确率)。 通常,训练初期的几个epoch,训练集和验证集的损失都会下降。但到某个时间点之后,训练集的损失仍在继续下降,而验证集的损失却开始停止下降,甚至不降反升。这个“拐点”,正是模型开始过拟合的信号。早停策略,就是在探测到这个拐点后,立即停止训练,并将模型恢复到在验证集上性能最好的那个状态。

实践智慧 早停的美妙之处在于其简单和高效。它不需要修改损失函数,也不需要引入额外的超参数(除了耐心等待的epoch数)。它直击问题的核心,在模型即将“走火入魔”的那一刻,果断地让它“收功禅定”,从而以最小的代价获得了极佳的正则化效果。

6.3 批归一化(Batch Normalization):重塑“地形”的“风水术”

批归一化(BN)是深度学习训练技术中的一项里程碑式的发明。它不仅能极大地加速模型的收敛速度,还兼具一定的正则化效果。它就像一位高明的“风水大师”,通过调整网络内部的数据“风水”,让训练过程变得异常顺畅。

6.3.1 内部协变量偏移(Internal Covariate Shift)

问题描述 想象一下深度网络的训练过程。当第一层的参数通过梯度下降进行更新后,它输出的数据的分布(均值、方差等)就发生了改变。对于第二层来说,它上一轮刚学会如何处理旧的输入分布,下一轮就要面对一个新的、陌生的输入分布。这种网络内部,层与层之间输入分布不断变化的现象,就被称为内部协变量偏移。 这迫使网络的每一层都需要不断地去适应其上游层输入分布的变化,就像在流沙上盖楼一样,极大地拖慢了整体的训练效率。

6.3.2 BN的工作原理

强制“水土”稳定 BN的解决方案简单而粗暴:在每一层的线性变换之后、激活函数之前,它强行将输入的数据(在一个mini-batch的范围内)进行一次标准化处理,使其均值恢复为0,方差恢复为1。 这样一来,无论上游层的参数如何变化,流到下游层的数据,其分布都被稳定在了这个标准状态,极大地稳定了“地基”。

可学习的“微调” 但新的问题来了:强行将数据都扭曲成标准正态分布,会不会破坏掉网络好不容易学到的有用特征呢?比如,某个特征的分布范围本身就蕴含着重要信息。 为了解决这个问题,BN引入了两个可以像权重一样通过学习来更新的参数:缩放因子 γ (gamma) 和 平移因子 β (beta)。在标准化之后,BN会用这两个参数对数据再进行一次线性的缩放和平移:y = γ * x_normalized + β。 这给了网络一个“反悔”的机会。在最坏的情况下,网络可以通过学习让 γ 等于原始数据的标准差,β 等于原始数据的均值,从而完全抵消掉标准化操作,恢复出原始的特征分布。这确保了BN在带来好处的同时,不会削弱模型的表达能力。

6.3.3 BN带来的好处

加速收敛:这是BN最主要的好处。由于内部数据分布被稳定,优化过程变得更加平滑,使得我们可以放心地使用更高的学习率,从而极大地加速模型的收敛。

缓解梯度消失:通过将数据拉回到激活函数(如Sigmoid)的线性区(中心区),BN有效地缓解了梯度饱和和梯度消失的问题。

自带正则化效果:由于BN是基于每个mini-batch的均值和方差进行计算的,而每个batch的数据都略有不同,这相当于为网络的每一层都引入了轻微的随机噪声。这种噪声,起到了类似Dropout的正则化效果,有助于提升模型的泛化能力。

6.4 超参数调优:寻找最佳“丹方”的艺术

如果说前面介绍的技术是“炼丹”中的具体“手法”,那么超参数调优,就是寻找最佳“丹方”的艺术。

6.4.1 超参数 vs. 参数

参数(Parameters):是模型在训练过程中,通过优化算法自动学习得到的值。例如,神经网络中的权重 w 和偏置 b。

超参数(Hyperparameters):是我们在训练开始之前,需要手动设定的配置。例如,学习率的大小、网络的层数、每个隐藏层的神经元数量、Dropout的丢弃率、正则化强度 λ 等。这些超参数共同决定了模型的架构和训练的方式,是模型的“基因”和“培养方案”。

6.4.2 经典的调优策略

网格搜索(Grid Search) 这是一种最暴力、最直接的地毯式搜索方法。需要为每一个所关心的超参数,设定一个候选值的列表。网格搜索会穷尽这些列表值的所有可能组合,为每一种组合都训练一个模型,并最终选出在验证集上表现最好的那个组合。 它的优点是完备,只要候选列表足够好,理论上能找到最优解。缺点是其计算成本随着超参数数量的增加呈指数级增长,在深度学习中几乎不可行。

随机搜索(Random Search) 随机搜索的做法是,不再尝试所有组合,而是在为每个超参数设定的一个范围内,随机地采样指定次数的组合来进行实验。 实践和理论都证明,随机搜索通常比网格搜索更高效。因为对于大多数模型来说,真正对性能有决定性影响的,往往只是少数几个“关键”超参数。随机搜索更有可能在这些关键超参数上探索到更优的值,而不会把大量的计算资源浪费在那些不重要的超参数的精细划分上。

6.4.3 更智能的调优:贝叶斯优化

学习如何搜索 网格搜索和随机搜索都是“盲目”的,每一次实验都是独立的,不会从过去的失败或成功中学到任何东西。贝叶斯优化则是一种更智能的策略。 它的核心思想是:根据所有已经完成的实验结果(即“(超参数组合,模型性能)”这个数据点),建立一个关于“哪个超参数组合可能会带来更好性能”的概率模型(代理模型)。然后,它利用这个模型,去智能地、有选择地挑选下一个最有希望(或者说,不确定性最大且潜力最高)的候选点进行尝试。 通过这种“边学边猜”的方式,贝叶斯优化通常能用比随机搜索少得多的实验次数,找到一个更好或相当的解,是目前进行复杂模型超参数调优的主流高级方法。

6.5 权重初始化:赢在“起跑线”

在“炼丹”的最后,我们回到起点。丹炉点火的那一刻,炉内物质的初始状态,往往对最终成丹的品质有决定性影响。权重初始化,就是这门“赢在起跑线”的学问。

6.5.1 初始化为何重要

打破对称性 一个绝对不能犯的错误,是将所有权重都初始化为0。如果这样做,那么在同一层的所有神经元,它们的输入、输出、以及接收到的梯度将永远是完全相同的。它们会像被捆绑在一起一样,学习到完全相同的特征。这被称为对称性问题,它会使得深度网络的多层结构完全失去意义。

梯度消失/爆炸 不恰当的随机初始化,也可能带来灾难。如果权重初始值过小,信号在前向传播中会逐层衰减,导致输出接近于0;梯度在反向传播中也会逐层消失,使网络难以训练。反之,如果权重初始值过大,则可能导致信号和梯度在前向和反向传播中被逐层指数级地放大,造成梯度爆炸,使训练过程发散。

6.5.2 现代初始化策略

现代的权重初始化策略,其核心目标都是为了让信号能够在网络中更稳定地流动,即保持每一层输出的方差大致稳定。

Xavier/Glorot初始化 核心思想:Xavier初始化推导出的一个关键结论是,为了保持前向传播和反向传播中信号方差的稳定,权重的初始化方差应该与该层的输入节点数 n_in 和输出节点数 n_out都有关。它通常从一个均值为0,方差为 2 / (n_in + n_out) 的均匀分布或正态分布中进行采样。 适用场景:这种初始化方法,在其推导中假设了激活函数是线性的,因此它在那些关于原点对称的激活函数(如Sigmoid和Tanh)上表现得非常好。

He初始化 对Xavier的修正:当激活函数换成现代网络中最常用的ReLU时,情况发生了变化。ReLU会将所有负的输入都置为零,这相当于直接“砍掉”了一半的信号。He初始化敏锐地考虑到了这一点,它在推导中修正了方差的计算,最终得到的采样方差为 2 / n_in。 适用场景:由于它专为ReLU及其变体(如Leaky ReLU)设计,He初始化是所有使用ReLU激活函数的现代深度神经网络的标准权重初始化方法。

小结

至此,我们已经完整地学习了深度学习“炼丹术”中的五大核心秘笈。从选择合适的优化器来高效导航,到运用正则化技术为模型设定戒律以防过拟合;从利用批归一化来稳定内部环境以加速收敛,到探索超参数调优的艺术来寻找最佳丹方;最后,我们还掌握了通过权重初始化来赢得一个良好开局的智慧。

这些技术,并非相互独立,而是相辅相成,共同构成了一个成功的深度学习实践者所必须具备的知识体系。它们将理论与工程、科学与艺术完美地结合在一起。

掌握了这些“炼-丹-术”,读者便拥有了将一个平庸模型,打磨成一个高性能模型的关键能力。现在,我们的“内功”与“招式”均已大成,是时候去挑战深度学习领域中那些更专门、更强大的“神功”了。在接下来的章节中,我们将进入计算机视觉和自然语言处理这两个最激动人心的应用领域。

第三部分:进阶篇 —— 掌握核心网络架构

第七章:卷积神经网络(CNN) —— 洞悉图像的奥秘

超越像素 —— 让机器“看”懂世界

欢迎来到深度学习最令人激动、也最符合我们人类直觉的领域——计算机视觉。我们的世界,是一个由图像和视频构成的视觉信息的海洋。让机器能够像我们一样“看”懂这个世界,是人工智能长久以来的梦想。在深度学习浪潮兴起之前,这个梦想遥不可及。而卷积神经网络(CNN)的出现,则如同一道划破长夜的闪电,彻底改变了这一切。

在前面的章节中,我们已经熟悉了多层感知机(MLP)。如果我们试图用MLP来处理一张图像,会遇到两个难以逾越的障碍。首先,我们需要将二维的图像矩阵展平(Flatten)成一个长长的一维向量。这个粗暴的操作,会彻底丢失图像宝贵的空间结构信息——一个像素与其上下左右邻居的关系,对于理解图像至关重要。其次,即使是一张很小的彩色图片,展平后的向量维度也极其巨大,这意味着MLP的输入层和第一隐藏层之间将产生天文数字般的参数量,这不仅让模型极易过拟合,也使其在计算上难以承受。

CNN,正是为解决这些问题而生的、一种专为处理像图像这类网格状数据而精心设计的神经网络架构。它的设计中,蕴含着深刻的仿生学智慧,其核心思想源于对生物视觉皮层工作方式的模仿。它不再将图像视为一个无序的像素集合,而是通过一种巧妙的方式,逐层地、有结构地从中提取信息——从最底层的边缘、角点,到中间层的眼睛、鼻子等部件,再到最高层的物体乃至场景。

在本章的探索中,我们将首先深入CNN赖以成功的三大基石思想:局部连接、权值共享与池化。随后,我们将像解剖学家一样,逐一剖析构成CNN的核心组件。接着,我们将穿越时空,回顾从LeNet-5到ResNet的经典CNN架构波澜壮阔的演进史诗,见证一代代AI先驱们如何将网络推向新的深度与高度。最后,我们将学会如何站在巨人的肩膀上,利用迁移学习来解决我们自己的问题,并一窥CNN在图像分类、目标检测、图像分割等更广阔世界中的强大应用。

准备好开启机器的“慧眼”了吗?让我们一同进入CNN的奇妙世界。

7.1 CNN的核心思想:源于视觉的智慧

CNN之所以能在计算机视觉领域取得如此巨大的成功,并非偶然。它的设计哲学,与我们生物视觉系统处理信息的方式惊人地相似。这三大核心思想——局部连接、权值共享和池化——共同构成了CNN高效而强大的基础。

7.1.1 局部连接(Local Connectivity):专注“一隅”

生物视觉的启发 让我们先思考一下我们自己的眼睛是如何工作的。诺贝尔奖得主Hubel和Wiesel的研究发现,猫的视觉皮层中,每个神经元都只对视野中的一个非常小的局部区域有反应。这个区域,被称为神经元的感受野(Receptive Field)。我们看世界,并不是一眼就感知到所有像素,而是由无数个这样的神经元,各自负责自己的一小片“责任田”,然后大脑再将这些局部信息整合起来,形成完整的视觉感知。

CNN的实现 CNN完美地借鉴了这一机制。在一个卷积层中,其神经元(或者说,输出特征图上的一个单元)不再与前一层的所有神经元相连接(这正是MLP的做法),而仅仅连接到输入图像(或前一层特征图)的一个很小的局部区域。 这个设计背后,蕴含着一个非常符合直觉的假设:物体的局部特征,是由其局部像素决定的。例如,要判断一个地方是否存在一个“角点”,我们只需要观察这个点周围一小圈像素的模式即可,而无需关心图像远处的内容。 局部连接这一思想,使得CNN的连接数和参数数量,相较于全连接的MLP,得到了指数级的减少,这是CNN能够处理高分辨率图像的第一个关键。

7.1.2 权值共享(Weight Sharing):一把“标尺”量天下

局部连接解决了参数过多的问题,但如果每个局部区域都需要一套独立的权重去学习,参数量依然庞大。权值共享,是CNN的第二个、也是更具革命性的思想。

图像的平移不变性 让我们再思考一个视觉常识:一个特定的模式,比如一只鸟的眼睛,无论它出现在图像的左上角,还是右下角,它作为“眼睛”的这个本质特征是不会改变的。我们大脑中的“眼睛探测器”,不会因为目标位置的改变而需要重新学习。这种特性,我们称之为平移不变性(Translation Invariance)。

卷积核(Kernel/Filter) 为了在神经网络中实现这一点,CNN引入了卷积核(Kernel),也常被称为滤波器(Filter)。一个卷积核,本质上就是一个小型的权重矩阵(例如3x3或5x5),它被设计用来检测一种特定的局部特征(如一个特定的边缘、一种特定的颜色组合或一个角点)。 权值共享的核心在于,这个卷积核会像一个滑动窗口一样,系统性地扫描整张输入图像。在每一个位置,它都与图像的对应局部区域进行计算(点积运算),并将结果记录在输出特征图的相应位置。重要的是,在整个滑动的过程中,这个卷积核的权重是固定不变的。

巨大的效率提升 权值共享的意义是巨大的。它意味着,我们只需要学习一个“眼睛探测器”(即一个卷积核),就可以用它来检测出图像中所有位置的眼睛。我们不再需要为图像的每一个像素位置,都单独去学习一个“眼睛探测器”。 通过这种方式,一个卷积层需要学习的参数数量,仅仅是其包含的卷积核的权重数量,这与输入图像的尺寸完全无关。这使得CNN在参数效率上达到了极致,也是其能够从有限数据中学到泛化能力极强的特征的根本原因。

7.1.3 池化(Pooling):去粗取精,降维减参

在通过卷积层提取到一系列特征之后(例如,我们得到了一张图,上面标记了所有“眼睛”特征被激活的位置),CNN通常会进行一次池化操作。

目的与思想 池化的核心思想是降低特征图的空间分辨率,即进行下采样(Downsampling)。这基于一个洞见:当我们检测到一个特征后,其精确到像素级别的位置,往往不如它与其他特征的相对位置关系来得重要。例如,知道一只眼睛的左边有一个鼻子,比知道这只眼睛在图像的(105, 210)像素位置要有用得多。 池化操作,就是在一个局部邻域内(例如一个2x2的窗口),用一个单一的值来概括这个区域的特征信息,从而实现信息的浓缩和降维。

效果 池化层通常不包含任何需要学习的参数,但它带来了三大好处:

- 降低计算量:它显著减小了特征图的尺寸(例如,一个

2x2的池化会将特征图的宽高各减半,尺寸变为原来的1/4),从而大幅降低了后续网络层的参数数量和计算负担。 - 增加感受野:这是一个非常重要的间接效果。由于池化层缩小了特征图,使得后续的卷积层虽然其卷积核尺寸不变,但其每一个单元所能“看到”的**原始输入图像的区域(即感受野)**却变大了。这使得网络能够学习到更大尺度、更抽象的特征。

- 提供平移不变性:池化操作使得模型对于特征在图像中的微小位移,具有了一定的容忍度。例如,即使目标在

2x2的窗口内移动了一个像素,只要它仍然是这个窗口内的最强响应,最大池化的输出结果就不会改变。这增强了模型的鲁棒性。

这三大思想——局部连接、权值共享、池化——如三根擎天之柱,共同支撑起了CNN这座宏伟的大厦。它们使得CNN能够以一种极其高效、且符合视觉规律的方式,从原始像素中逐层提取出越来越抽象、越来越有意义的特征表示。

7.2 核心组件详解:构建CNN的“乐高积木”

理解了CNN的核心思想后,我们就可以来详细审视构成一个典型CNN模型的“乐高积木”了——卷积层、池化层和全连接层。

7.2.1 卷积层(Convolutional Layer):特征提取的引擎

卷积层是CNN的心脏和灵魂,它负责执行最主要的特征提取工作。

关键元素 一次卷积操作,涉及以下几个关键元素:

- 输入特征图(Input Feature Map):它可以是原始的图像(例如,一个

224x224x3的彩色图像,3代表RGB三个颜色通道),也可以是前一个卷积层输出的特征图。 - 卷积核(Kernel / Filter):一个小的权重矩阵。需要注意的是,卷积核的深度必须与输入特征图的深度相匹配。例如,如果要在一个

224x224x3的图像上做卷积,那么卷积核的尺寸就必须是kxk_x3(如3x3x3)。它会同时在三个通道上进行计算,并将结果相加,得到一个单一的输出值。 - 输出特征图(Output Feature Map):也称为激活图(Activation Map)。它是卷积核在输入特征图上滑动并计算后生成的结果。输出特征图上的每一个像素值,都代表了卷积核所对应的那个特定特征,在输入图像该位置的激活强度。

超参数详解 在定义一个卷积层时,我们需要设定几个关键的超参数,它们共同决定了该层的行为:

- 滤波器数量(Number of Filters):这是最重要的超参数之一。它决定了一个卷积层要学习多少种不同类型的特征。如果我们设定滤波器数量为64,那么这个卷积层就会拥有64个独立的卷积核,每个核都去学习一种不同的模式。最终,该层会输出一个深度为64的特征图。

- 滤波器尺寸(Filter Size):即卷积核的宽度和高度,通常选择较小的尺寸,如

3x3或5x5。小的滤波器尺寸意味着更少的参数和更精细的特征。 - 步长(Stride):指卷积核在输入特征图上每次滑动的像素距离。步长为1表示逐像素滑动,步长为2则表示每次跳过一个像素。较大的步长会产生更小的输出特征图,有类似池化的降采样效果。

- 填充(Padding):如果在卷积操作前,不先在输入特征图的边缘进行填充,那么输出特征图的尺寸将会比输入小。填充通常是在输入的边缘周围补上一圈或几圈的0。最常用的

padding='same'设置,可以确保在步长为1的情况下,输出特征图的空间尺寸与输入特征图完全相同,这在构建深层网络时非常方便。

7.2.2 池化层(Pooling Layer):信息的高度浓缩

池化层通常紧跟在卷积层之后,用于对提取出的特征进行降维和概括。

最大池化(Max Pooling) 工作原理:这是最常用、最有效的池化方式。它将特征图划分为若干个不重叠的矩形区域(池化窗口,如2x2),然后,在每个区域内,只取最大值作为唯一的输出。 直观理解:最大池化传递了一个非常明确的信息:“我只关心这个区域内是否存在我想要的那个特征,以及这个特征的最强响应是什么”。它对特征的位置不敏感,只对特征的有无和强度敏感,这是一种非常有效的非线性下采样。

平均池化(Average Pooling) 工作原理:与最大池化类似,但它计算的是池化窗口内所有像素值的平均值作为输出。 直观理解:平均池化保留了每个区域特征的“整体背景信息”,其输出更为平滑。在历史上它曾被使用,但在现代CNN中,除了在网络末端用于全局平均池化(Global Average Pooling)之外,在中间层,其效果通常不如最大池化。

7.2.3 全连接层(Fully Connected Layer):特征的“翻译官”

在经过了多轮“卷积-激活-池化”的特征提取之后,我们得到了一组高度抽象、但空间维度较小的特征图。现在,我们需要根据这些特征来做出最终的决策。这个任务,就交给了位于CNN架构末端的全连接层。

角色与位置 全连接层通常是CNN的最后几个层。在它之前,最后一层卷积或池化层输出的立体特征图(例如,一个7x7x512的特征图)会被**展平(Flatten)**成一个长长的一维向量(7*7*512 = 25088维)。

工作原理与功能 这个一维向量,随后会被送入一个或多个我们早已熟悉的全连接层(即MLP)。 全连接层的作用,就像一个“翻译官”。它接收前面所有卷积层辛辛苦苦提取出的、高度抽象的、分布式的特征表示(例如,“有毛茸茸的耳朵”、“有胡须”、“有猫一样的眼睛”等特征的激活值),然后对这些高级特征进行加权组合与非线性变换,最终将它们“翻译”成我们任务所需要的最终输出。 例如,在一个1000类的图像分类任务中,最后一个全连接层的输出维度就是1000,并通过Softmax激活函数,将其转换为对这1000个类别的预测概率。

通过这三种核心组件的有机组合与堆叠,CNN构建起了一个从局部到全局、从具体到抽象的、强大的分层特征学习体系。

7.3 经典CNN架构演进:一部浓缩的视觉AI史

从第一个能够实际应用的CNN,到如今动辄上百层的庞然大物,这条演进之路充满了智慧的闪光与思想的碰撞。理解这些经典架构,就是理解CNN发展的脉络与精髓。

7.3.1 LeNet-5 (1998):开山鼻祖

历史地位 在深度学习还未成为潮流的20世纪90年代,Yann LeCun教授便设计出了LeNet-5,并成功地将其应用于美国邮政系统的手写数字识别任务中。它被公认为第一个被成功大规模商业应用的卷积神经网络,是当之无愧的开山鼻祖。

核心贡献 LeNet-5的架构虽然在今天看来非常小巧,但它却奠定了现代CNN的基本蓝图。它首次完整地展示了“输入 -> 卷积 -> 池化 -> 卷积 -> 池化 -> 全连接 -> 全连接 -> 输出”这一经典范式。它使用的激活函数是Sigmoid和Tanh,池化方式是平均池化。LeNet-5的成功,证明了这种分层特征提取的架构是行之有效的。

7.3.2 AlexNet (2012):王者归来

历史地位 在LeNet之后,由于计算能力的限制和SVM等传统方法的强势,神经网络经历了一段漫长的“寒冬”。直到2012年,Alex Krizhevsky、Ilya Sutskever和Geoff Hinton带着AlexNet,在当年的ImageNet大规模视觉识别挑战赛(ILSVRC)中,以碾压性的优势(Top-5错误率15.3%,远低于第二名的26.2%)一举夺冠。这一事件,如同一声惊雷,宣告了深度学习时代的王者归来,引爆了至今仍在持续的人工智能革命。

核心贡献 AlexNet的成功并非偶然,它建立在LeNet的基础上,并引入了几个关键的、具有划时代意义的创新:

- 更深更宽的网络:它拥有5个卷积层和3个全连接层,比LeNet-5大得多,能够学习更复杂的特征。

- ReLU激活函数:它首次在大型CNN中用ReLU替换了传统的Sigmoid/Tanh。ReLU的非饱和性极大地缓解了梯度消失问题,使得训练深层网络成为可能,收敛速度也快得多。

- Dropout:在最后的全连接层中使用了Dropout技术,有效地抑制了由于模型参数过多而导致的过拟合问题。

- GPU训练:这是其成功的关键秘诀。作者创造性地使用了两块NVIDIA GTX 580 GPU进行并行训练,极大地提升了计算效率,使得训练如此庞大的网络成为现实。

7.3.3 VGGNet (2014):极致的简约与深度

设计哲学 AlexNet之后,牛津大学的视觉几何组(Visual Geometry Group, VGG)提出了VGGNet。它的核心设计哲学是:大道至简。VGGNet摒弃了花哨的结构,旨在探索一个纯粹的问题——网络深度对性能究竟有多大影响?为此,它将整个网络都用一种极其规整、统一的组件来搭建。

核心贡献 VGGNet最核心的贡献,是证明了使用多个堆叠的、非常小的(3x3)卷积核,其效果优于使用一个大的卷积核。例如,两个3x3的卷积层堆叠,其感受野等效于一个5x5的卷积层,但参数量更少,且能引入更多的非线性变换,表达能力更强。VGGNet凭借其极致简约、规整的“积木块”式结构,将网络深度推向了16-19层,取得了优异的性能。由于其结构简单清晰,VGGNet至今仍是许多研究和应用中非常受欢迎的基线模型。

7.3.4 GoogLeNet (Inception) (2014):宽度的探索

设计哲学 与VGGNet同年,Google团队提出了GoogLeNet,并赢得了2014年的ImageNet挑战赛。它提出了一个不同的问题:在网络不断变深的同时,我们能否让网络也变得更“宽”,并且更高效?GoogLeNet的核心,是其精巧设计的Inception模块。

核心贡献 Inception模块的思想是,对于一个输入特征图,我们很难预知用多大尺寸的卷积核去处理才是最优的。那么,何不将不同尺寸的操作并行地执行一遍,然后让网络自己去学习如何组合它们? 一个Inception模块会并行地对输入使用1x1卷积、3x3卷积、5x5卷积以及3x3最大池化,然后将所有这些操作的输出特征图在深度这个维度上**拼接(Concatenate)**起来。这种“网络中的网络”(Network-in-Network)结构,极大地提升了网络的宽度和对不同尺度特征的适应能力。同时,它还巧妙地使用1x1的卷积核来进行降维,极大地减少了计算量。

7.3.5 ResNet (Residual Network) (2015):跨越深度的天堑

面临的问题 随着网络越来越深,人们发现了一个令人困惑的现象:网络退化(Degradation)。按理说,一个更深的模型,其解空间包含了那个更浅的模型,性能至少不应该更差。但实验表明,当网络堆叠到一定深度后(例如56层),其训练误差和测试误差反而会比一个较浅的网络(例如20层)更高。这说明,让一个深度网络去学习一个恒等映射(即什么都不做,直接输出输入)都是非常困难的。

核心贡献 2015年,何恺明等几位华人研究员提出的残差网络(ResNet),天才般地解决了这个问题。其核心是引入了残差连接(Residual Connection),也常被称为快捷连接(Shortcut Connection)。 这个连接允许输入信号 x 可以“抄近道”,直接跳过一个或多个卷积层,在这些层的输出 F(x) 之后,直接与之相加,得到最终的输出 H(x) = F(x) + x。 这个简单的改动,彻底改变了网络的学习目标。网络不再需要去拟合一个期望的完整映射 H(x),而仅仅需要去学习输入与输出之间的残差(Residual)F(x)。如果某个层对于当前任务是冗余的,网络只需要将这一层的权重 F(x) 学成0即可,此时 H(x) = x,一个恒等映射被轻松实现。

历史地位 ResNet的出现,如同一座桥梁,跨越了阻碍网络走向更深的天堑。它使得训练数百层甚至上千层的超深神经网络成为可能,极大地提升了模型的性能,并再次刷新了ImageNet的记录。残差连接的思想,成为了后续几乎所有先进CNN架构的标配。

7.4 迁移学习与微调:站在巨人的肩膀上

我们刚刚回顾的这些经典架构,尤其是ResNet等,它们的强大性能背后,是在ImageNet这样拥有上百万张图片、上千个类别的数据集上,使用海量GPU资源训练数周的结果。这对于绝大多数个人和中小型组织来说,是完全无法复现的。那么,我们是否就无法享受到这些强大模型的红利了呢?答案是:我们可以,通过迁移学习。

7.4.1 迁移学习的核心思想

迁移学习的基石是一个重要的洞见:知识是可以迁移的。一个在ImageNet上预训练好的CNN模型,它在靠近输入的浅层网络中,学到的是非常通用的视觉特征,比如边缘、角点、纹理、颜色块等。这些基础特征,对于解决几乎所有的计算机视觉任务都是有用的,无论是识别猫狗,还是诊断医疗影像。

7.4.2 迁移学习实践策略

我们可以“借用”这些在大规模数据集上预训练好的模型(Pre-trained Model),将其作为我们自己任务的一个强大的、现成的特征提取器。具体操作上,通常有两种策略:

-

作为固定的特征提取器 这是最简单的方法。我们加载一个预训练模型(如ResNet-50),然后“冻结”其所有卷积层(即在训练中保持它们的权重不变)。我们只移除其原始的分类头(即最后的全连接层),换上我们自己为新任务设计的、新的、未训练的分类头。在训练时,我们只更新这个新分类头的参数。这种方法非常适合当我们的新任务数据集很小的时候。

-

微调(Fine-tuning) 这是一种更强大、也更常用的策略。我们同样加载预训练模型并替换分类头。但这一次,我们不完全冻结卷积层。我们用一个非常小的学习率,解冻并继续训练预训练模型的部分或全部卷积层(通常是更靠近输出的、更抽象的高层特征层)。 这样做,可以让那些预训练好的、通用的特征,根据我们新任务的数据分布,进行一些细微的调整,使其更能“专精”于我们的特定任务。微调通常能带来比固定特征提取器更好的性能,尤其是在我们的新任务数据量不是特别小的情况下。

迁移学习,让我们得以站在巨人的肩膀上,用有限的数据和计算资源,快速地构建出性能优异的视觉模型。

7.5 CNN的应用:从分类到更广阔的世界

虽然我们本章的讨论大多围绕图像分类展开,但这仅仅是CNN能力的冰山一角。掌握了分层特征提取这一核心能力后,CNN被广泛地应用于各种更复杂的视觉任务中。

7.5.1 图像分类(Image Classification)

这是CNN最基础、最核心的应用,即回答“这张图片里有什么?”的问题。它是所有其他视觉任务的基础。

7.5.2 目标检测(Object Detection)

目标检测的任务更进一步,它需要回答“图片里的物体分别是什么?它们在哪里?”。它不仅要识别出图像中所有物体的类别,还要用一个紧密的**边界框(Bounding Box)**来标出每个物体的位置。

- 经典方法:

- 两阶段方法:以 Faster R-CNN 为代表。它首先通过一个“区域提议网络”(RPN)来生成上千个可能包含物体的“候选区域”,然后,再对这些候选区域逐一进行分类和边界框的精确回归。这类方法通常精度更高。