逆天的智谱realtime api调用!附完整源代码

智谱清言Realtime API的开放,为开发者提供了强大的实时交互能力,但是目前真正的尝试和代码实现我们还没见到多少,所以欢迎大家在评论区分享你的实现过程!(不想再看哪个文档第二眼hh)

·

深度剖析:智谱清言Realtime API的技术实现与行业洞察

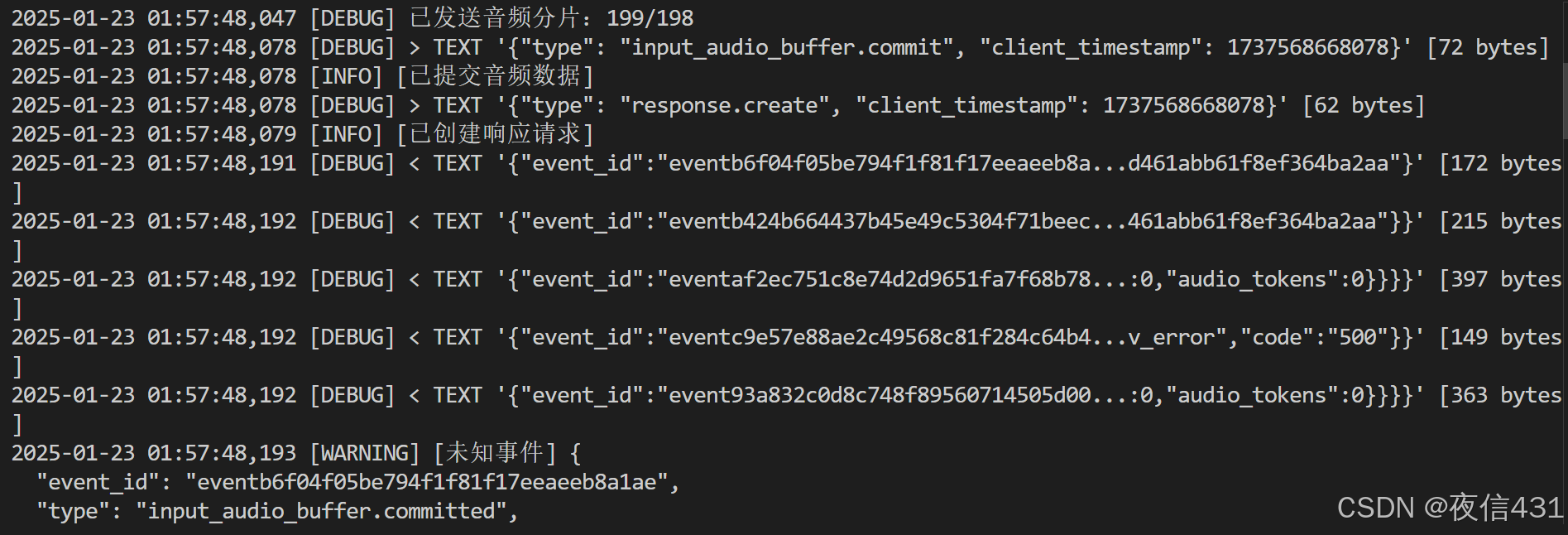

智谱清言(GLM-Realtime)近几日刚刚发布,我看CSDN上还没有具体的代码实现,确实,我看了他的官方docs,我只能说:不是很想让大家用。。。经过我昨晚五小时的尝试,算是用python实现了他的音频功能,真的很逆天这个文档写的。。话不多说,简单介绍一下我们直接看代码。

一、技术原理:Realtime API的核心机制

1. 多模态实时交互

智谱清言Realtime API支持文本、音频和视频的实时推理,能够实现流畅的人机对话。其核心机制包括:

- WebSocket协议:基于WebSocket的全双工通信,确保低延迟的实时数据传输。

- 多模态输入输出:支持视频帧、图片、音频输入,以及文本和音频输出。

- VAD(声音活动检测):支持服务器端和客户端的语音检测,实现智能打断和响应。

2. 关键技术点

- JWT鉴权:通过JWT(JSON Web Token)实现客户端鉴权,确保API调用的安全性。

- 实时音频流处理:支持分块上传音频数据,模拟实时流式传输。

- 会话管理:通过

session.update事件动态调整会话配置,支持音频、视频模式的切换。

3. 代码实现解析

以下是一个基于Python的Realtime API调用示例:

import asyncio

import websockets

import json

import base64

import time

import jwt

def generate_jwt_token(api_key, expire_seconds=600):

api_key_parts = api_key.split('.')

api_key_id, api_secret = api_key_parts

payload = {

"api_key": api_key_id,

"exp": int(time.time()) + expire_seconds,

"timestamp": int(time.time() * 1000)

}

token = jwt.encode(payload, api_secret, algorithm='HS256', headers={"alg": "HS256", "sign_type": "SIGN"})

return token

async def realtime_client(api_key, audio_path):

jwt_token = generate_jwt_token(api_key)

headers = [("Authorization", f"Bearer {jwt_token}")]

async with websockets.connect(

"wss://open.bigmodel.cn/api/paas/v4/realtime",

additional_headers=headers

) as websocket:

# 发送会话配置

session_config = {

"type": "session.update",

"session": {

"input_audio_format": "wav",

"output_audio_format": "mp3",

"turn_detection": {"type": "server_vad"},

"beta_fields": {"chat_mode": "audio", "tts_source": "e2e", "auto_search": True}

}

}

await websocket.send(json.dumps(session_config))

# 发送音频数据

with open(audio_path, "rb") as f:

audio_data = f.read()

for i in range(0, len(audio_data), 320):

chunk = audio_data[i:i+320]

await websocket.send(json.dumps({

"type": "input_audio_buffer.append",

"audio": base64.b64encode(chunk).decode('utf-8'),

"client_timestamp": int(time.time() * 1000)

}))

await asyncio.sleep(0.02)

# 提交音频

await websocket.send(json.dumps({

"type": "input_audio_buffer.commit",

"client_timestamp": int(time.time() * 1000)

}))

# 处理服务器响应

async for message in websocket:

response = json.loads(message)

if response.get('type') == "response.text.done":

print(f"[AI回复] {response.get('text')}")

elif response.get('type') == "error":

print(f"[错误] {response.get('error', {}).get('message')}")

if __name__ == "__main__":

asyncio.get_event_loop().run_until_complete(

realtime_client("your_api_key_here", "input.wav")

)

二、行业现状:实时AI交互的应用场景

1. 智能客服

- 实时语音对话:通过Realtime API实现智能客服的语音交互,提升用户体验。

- 多模态支持:结合视频和文本,提供更丰富的服务形式。

2. 在线教育

- 实时答疑:学生可通过语音或视频与AI助教实时互动。

- 课堂辅助:AI实时分析课堂内容,提供知识点补充和问题解答。

3. 医疗健康

- 远程问诊:患者通过视频与AI医生实时沟通,获取初步诊断建议。

- 健康监测:结合可穿戴设备,实时分析用户健康数据。

三、未来展望:赶紧优化吧智谱,看好你~

1. 更低延迟和更好用

- 边缘计算:将AI推理能力下沉到边缘设备,减少数据传输延迟。

- 5G网络:利用5G的高带宽和低延迟特性,提升实时交互体验。

2. 更自然的交互

- 情感计算:通过分析用户的表情、语调和肢体语言,实现更自然的人机交互。

- 多语言支持:支持更多语言的实时翻译和交互,打破语言障碍。

四、总结

智谱清言Realtime API的开放,为开发者提供了强大的实时交互能力,但是目前真正的尝试和代码实现我们还没见到多少,所以欢迎大家在评论区分享你的实现过程!(不想再看哪个文档第二眼hh)

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)